想必視頻內容已經成爲人們獲取知識、記錄觀點和進行內容創作的重要媒介。相比圖文,視頻的信息呈現更豐富,但也更難檢索、難以快速覆盤。尤其在面對教育講座、操作教程、會議錄播等類型的視頻時,不少人往往希望能夠提煉出一份清晰的筆記以備後用。然而,手動整理視頻筆記的過程不僅繁瑣、耗時,而且極易遺漏重點信息。因此,藉助 AI 工具自動提取視頻內容、生成結構化筆記,已成爲一種高效且趨勢化的解決方案。

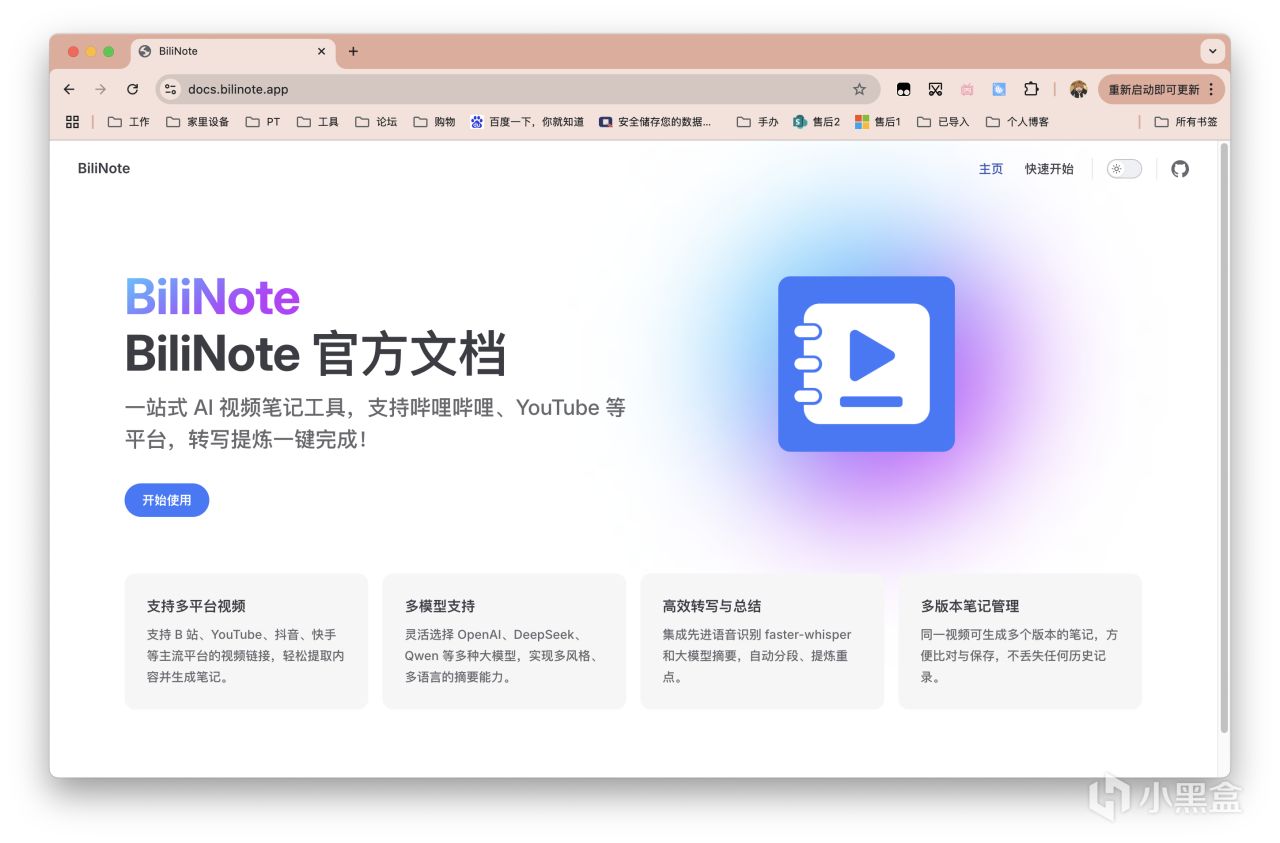

本期來介紹一個開源的AI視頻筆記生成工具,能夠讓AI替你的視頻做筆記:BiliNote。

📖 項目介紹

BiliNote 是一款開源的 AI 視頻筆記助手,支持通過嗶哩嗶哩、油管、抖音、本地視頻鏈接或文件,自動提取語音內容,並將其結構化爲清晰、重點明確的 Markdown 格式筆記。

它內置 FastAPI 後端和 React 前端,支持本地部署的大模型或調用 API 接口完成語言總結,同時可選集成 Whisper 本地模型進行語音識別。BiliNote 提供截圖插圖、原片跳轉(時間戳)、任務追蹤等功能,適配不同工作流需求;部署方式上,既可使用 Windows/Mac 打包版,也可通過 Docker Compose 容器部署,適用於本地自用或私有化部署環境。

🤔 應用場景

以下這些都是 BiliNote 可以高效介入的實際使用場景,包含但不侷限於此:

在處理 B 站公開課、技術講座等學習類視頻時,用戶可以使用 BiliNote 生成包含段落標題、要點總結的 Markdown 筆記,方便後續複習。也可通過筆記直鏈跳轉到對應時間節點,直接從對應部分觀看。

在運營或產品部門回看公司內部培訓錄播視頻時,可以快速提取要點、同步任務記錄,免去重複觀看的煩惱。

在進行短視頻選題調研、內容剪輯時,可以將視頻鏈接導入系統,自動生成視頻結構草稿、抓取關鍵語句與截圖素材。

在錄製視頻播客或會議紀要後,也可以本地上傳音視頻文件,通過 Whisper 轉寫與 GPT 總結組合,自動生成完整內容筆記。

🍀 部署流程

先囉嗦幾句

演示設備爲威聯通NAS,型號TS-464C,處理器N5095。

本文會介紹Docker Compose的方式進行部署使用。關於配置文件,以及包含Windows打包版的包體在內,會放在文末,網絡不方便的朋友可取用。

項目名:JefferyHcool/BiliNote,想了解更多的朋友直接在GHUB搜索即可。

修改配置可通過vi命令,或者NAS自帶的工具對配置文件進行編輯。除非你清楚自己在做什麼,否則建議只修改docker-compose.yml或.env.example,或者不改動直接部署。

如果你的設備有獨顯,或對自己的設備性能不夠自信,又或是非常自信,請至到注意事項章節查看。

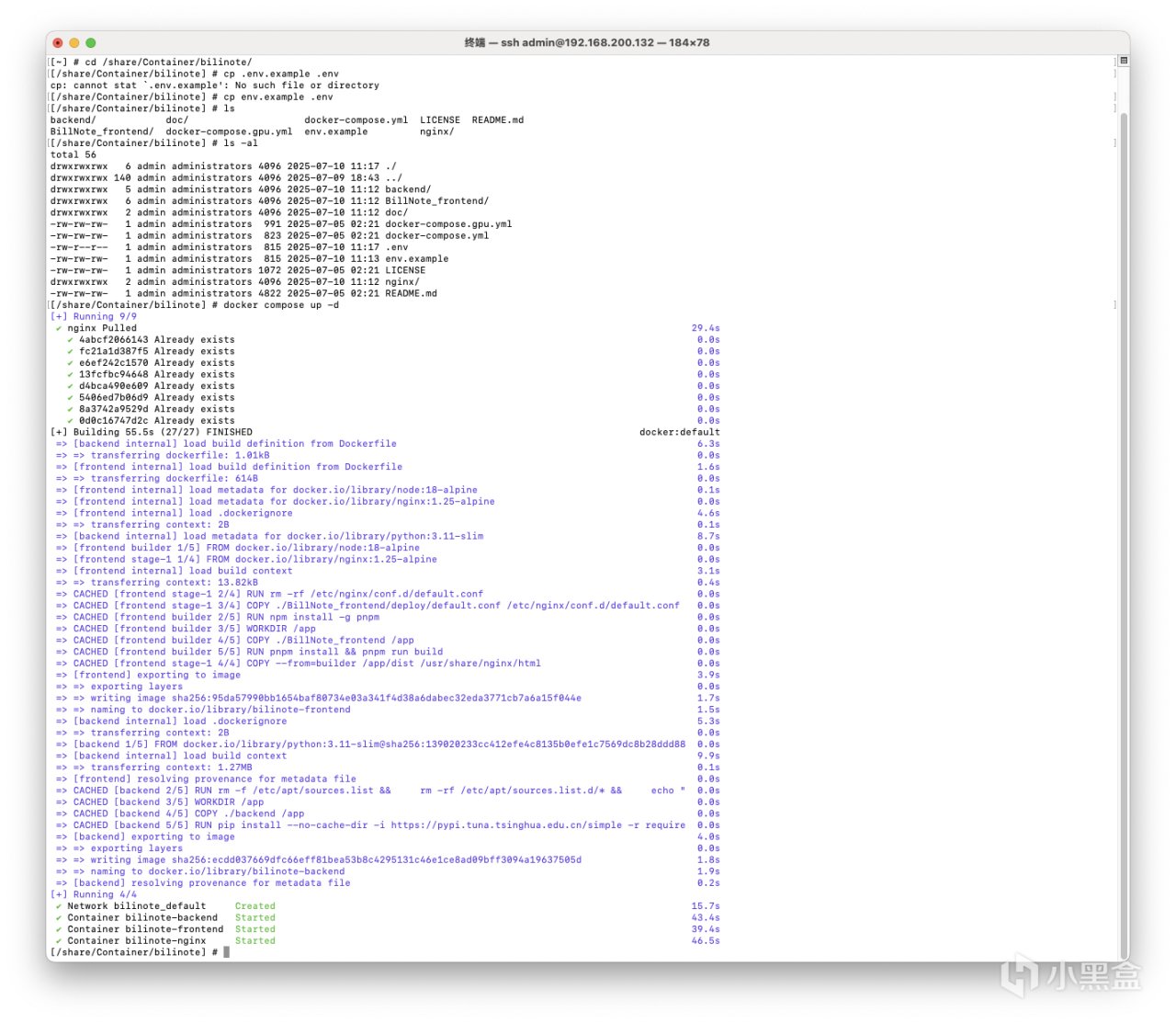

情況一:能成功連通GHUB(簡單)

SSH鏈接至NAS,輸入以下命令,克隆部署倉庫。

cd <docker 目錄下> # 例如威聯通NAS輸入 cd /share/Container

git clone https://github.com/JefferyHcool/BiliNote.git

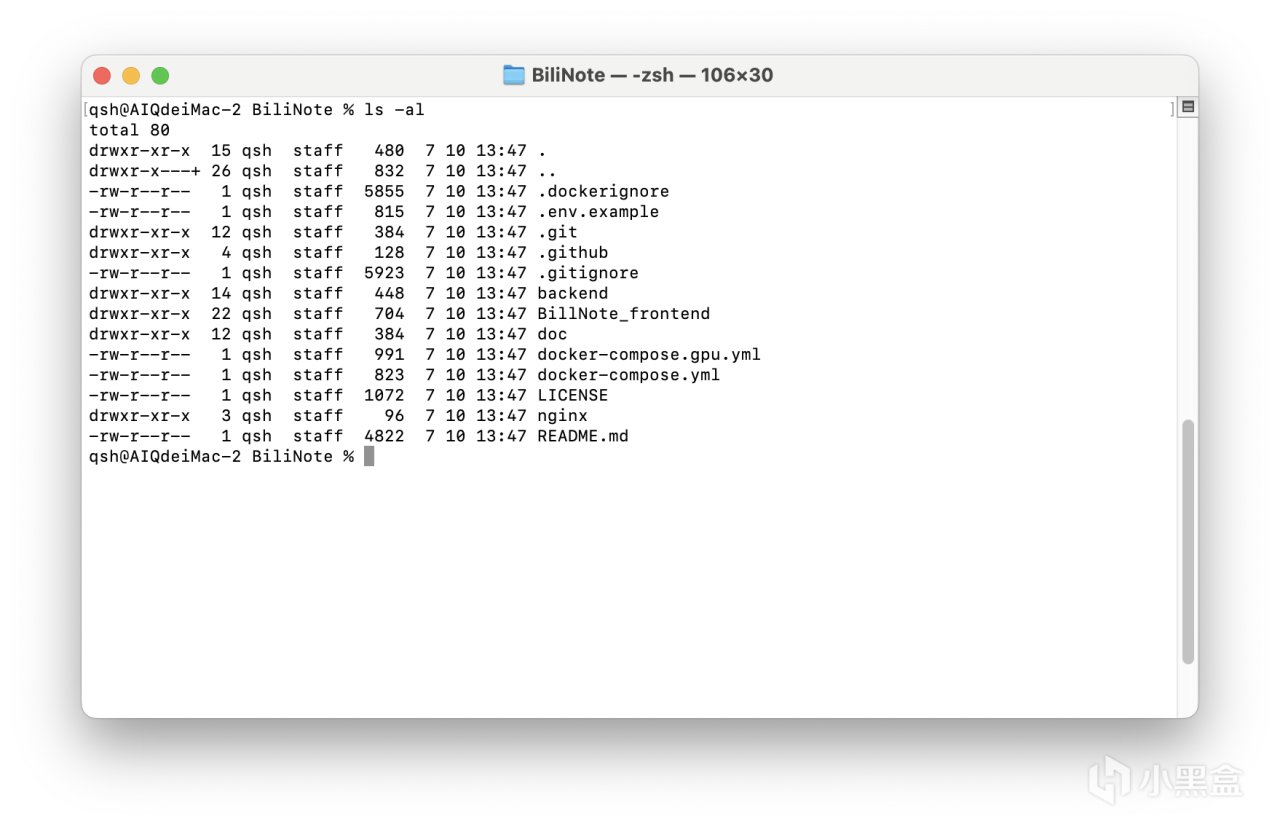

cd BiliNote

接着輸入命令,查看文件:

ls -al

確認無誤後,接着輸入以下命令:

# 將環境文件重命名

mv .env.example .env

# 構建Docker鏡像並啓動

docker compose up -d # 或 docker-compose up -d

等待部署即可。

情況二:無法連通GHUB(簡單)

文末我提供的文件包先下載下來。

在NAS準備好對應的文件目錄,威聯通爲例:/share/Container/BiliNote,將解壓好的全部內容全部拖入該目錄下。

可選擇用自帶的編輯器重命名另存爲.env,也可重複情況一的操作用命令行重命名。如果你看不到.env文件,請勾選顯示隱藏文件。

命名完畢後接着重複:

# 情況一二都必須執行該命令

cd /share/Container/BiliNote

# 已改名的忽略

mv .env.example .env

# 情況一二都必須執行該命令

docker compose up -d

等待部署即可。

⚠ 注意事項

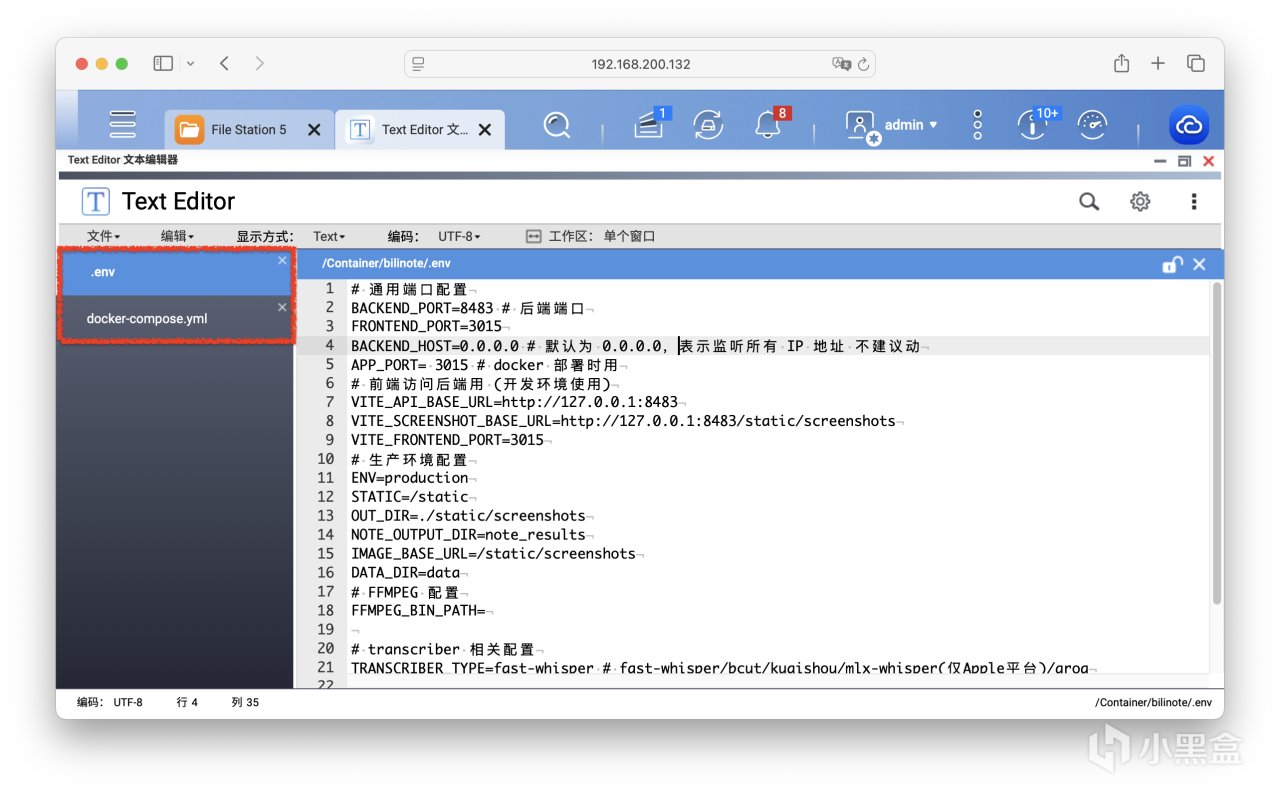

文件.env 詳解

BACKEND_PORT=8483 # 後端服務監聽端口,默認 8483

FRONTEND_PORT=3015 # 前端 Web 頁面監聽端口,默認 3015

BACKEND_HOST=0.0.0.0 # 後端服務監聽的地址。默認 0.0.0.0 表示監聽所有 IP,不建議修改

APP_PORT= 3015 # 容器前端的訪問端口,與 FRONTEND_PORT 保持一致

VITE_API_BASE_URL=http://127.0.0.1:8483 # 前端訪問後端 API 的基礎地址(開發時用)

VITE_SCREENSHOT_BASE_URL=http://127.0.0.1:8483/static/screenshots # 前端訪問截圖資源的地址

VITE_FRONTEND_PORT=3015 # 前端項目運行端口,與上面一致

ENV=production # 環境模式,可選:development / production

STATIC=/static # 靜態資源的 URL 路徑前綴,默認 /static

OUT_DIR=./static/screenshots # 視頻截圖保存路徑(相對路徑)

NOTE_OUTPUT_DIR=note_results # 筆記結果輸出目錄(markdown 和狀態文件將保存在此)

IMAGE_BASE_URL=/static/screenshots # 前端訪問圖片的路徑前綴

DATA_DIR=data # 數據文件保存目錄,例如轉錄中間件產生的緩存數據等

FFMPEG_BIN_PATH= # 可選項:如果需要自定義 ffmpeg 路徑可填此項;默認使用系統自帶 ffmpeg

TRANSCRIBER_TYPE=fast-whisper # 語音轉文字使用的模型類型

# 可選項:

# - fast-whisper(推薦,支持 CPU/GPU)

# - bcut(字節跳動轉寫 API)

# - kuaishou(快手轉寫 API)

# - mlx-whisper(僅限 Apple MLX 框架)

# - groq(使用 groq 平臺 Whisper)

WHISPER_MODEL_SIZE=base # fast-whisper 模型尺寸(base、small、medium、large)

# 如果 TRANSCRIBER_TYPE 設置爲 groq,使用以下模型

GROQ_TRANSCRIBER_MODEL=whisper-large-v3-turbo # groq 平臺提供的 whisper-large-v3-turbo 模型,

關於語音識別配置

如果你的設備帶有獨立的顯卡,請修改.env並運行docker-compose.gpu.yml文件進行構建。

威聯通TS-464C的CPU性能在默認配置下跑得還算可以,如果你的配置較低則建議降低模型版本,否則更容易出現幻覺導致結果不準確。

.env中的默認配置如下:

TRANSCRIBER_TYPE=fast-whisper # fast-whisper/bcut/kuaishou/mlx-whisper(僅Apple平臺)/groq

WHISPER_MODEL_SIZE=base

GROQ_TRANSCRIBER_MODEL=whisper-large-v3-turbo # groq提供的faster-whisper 默認爲 whisper-large-v3-turbo

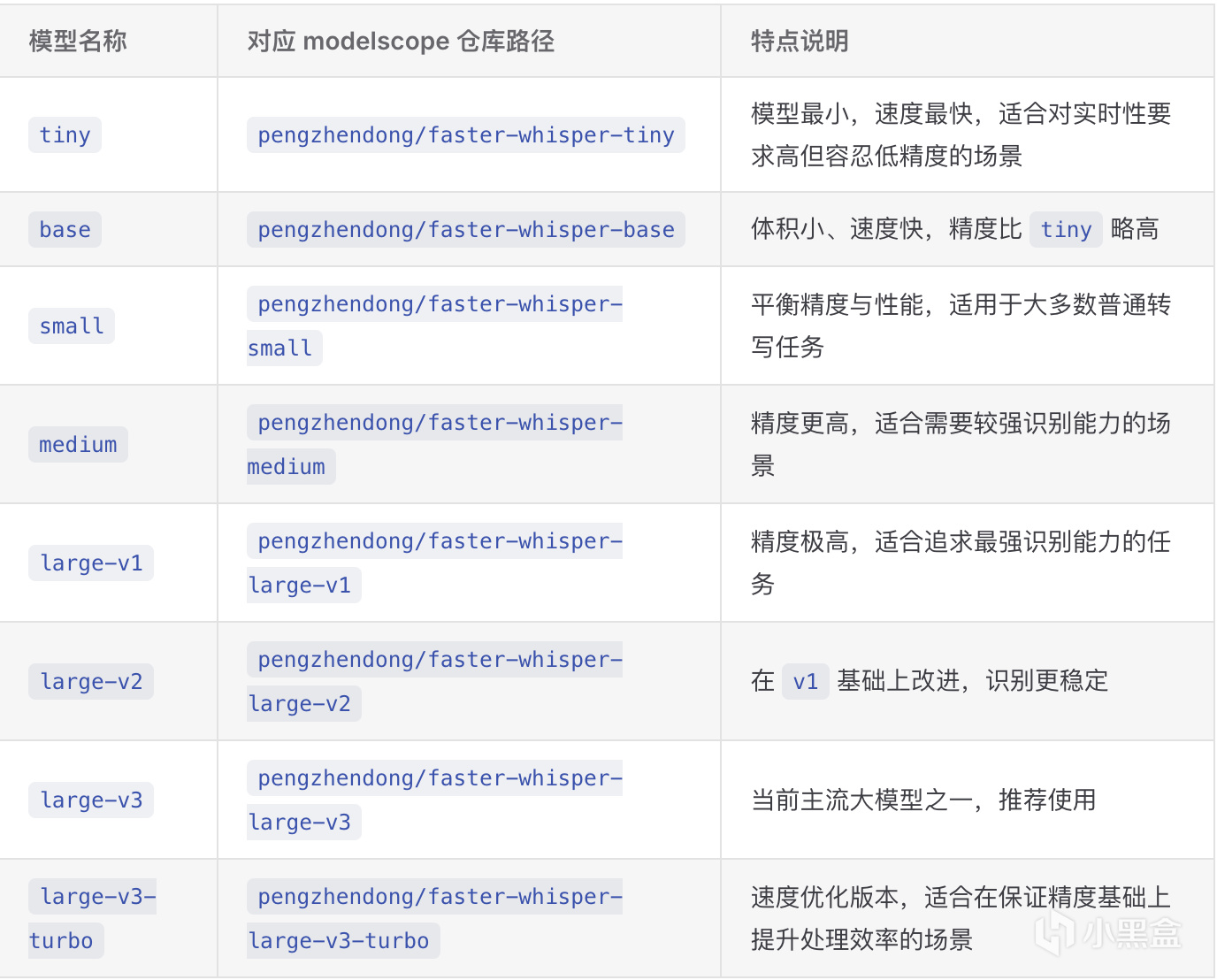

Fast-Whisper 模型選擇

截圖來自項目Wiki。

🎉 使用展示

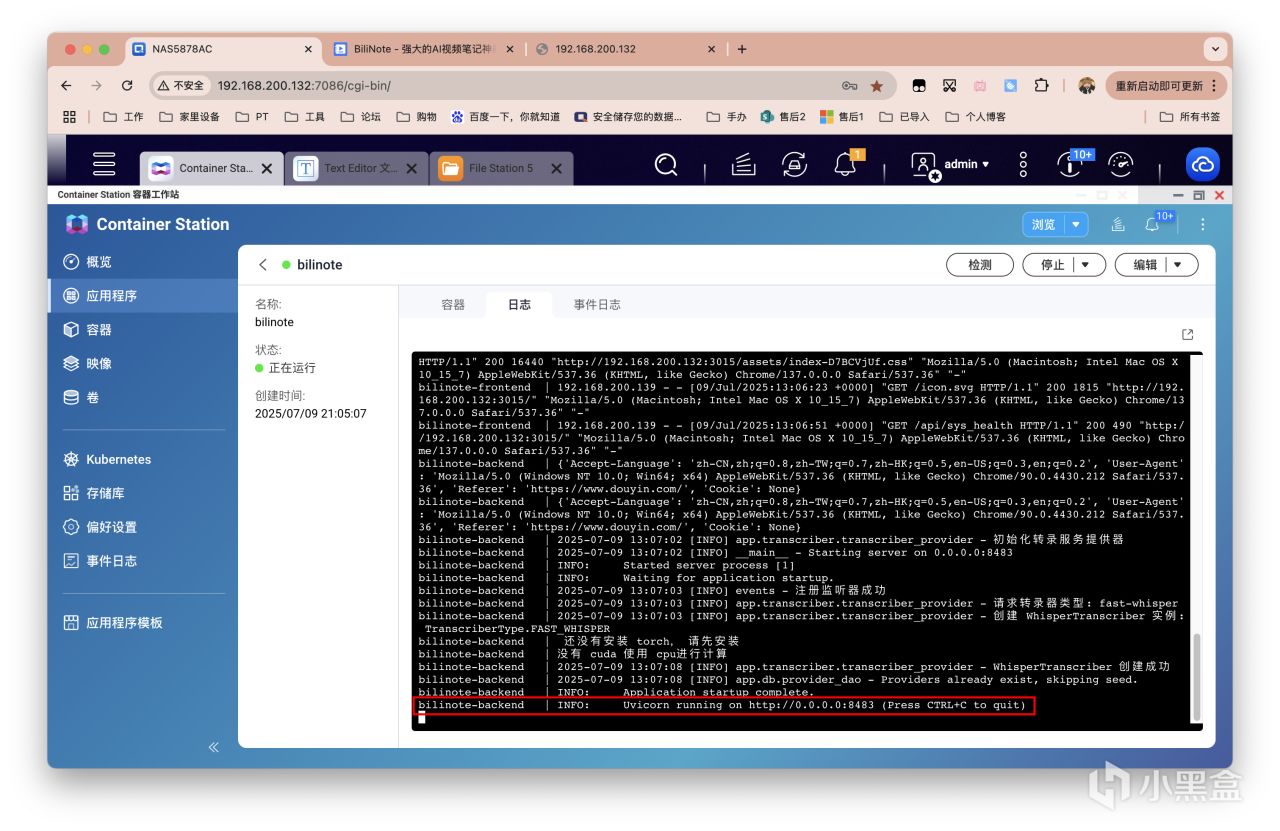

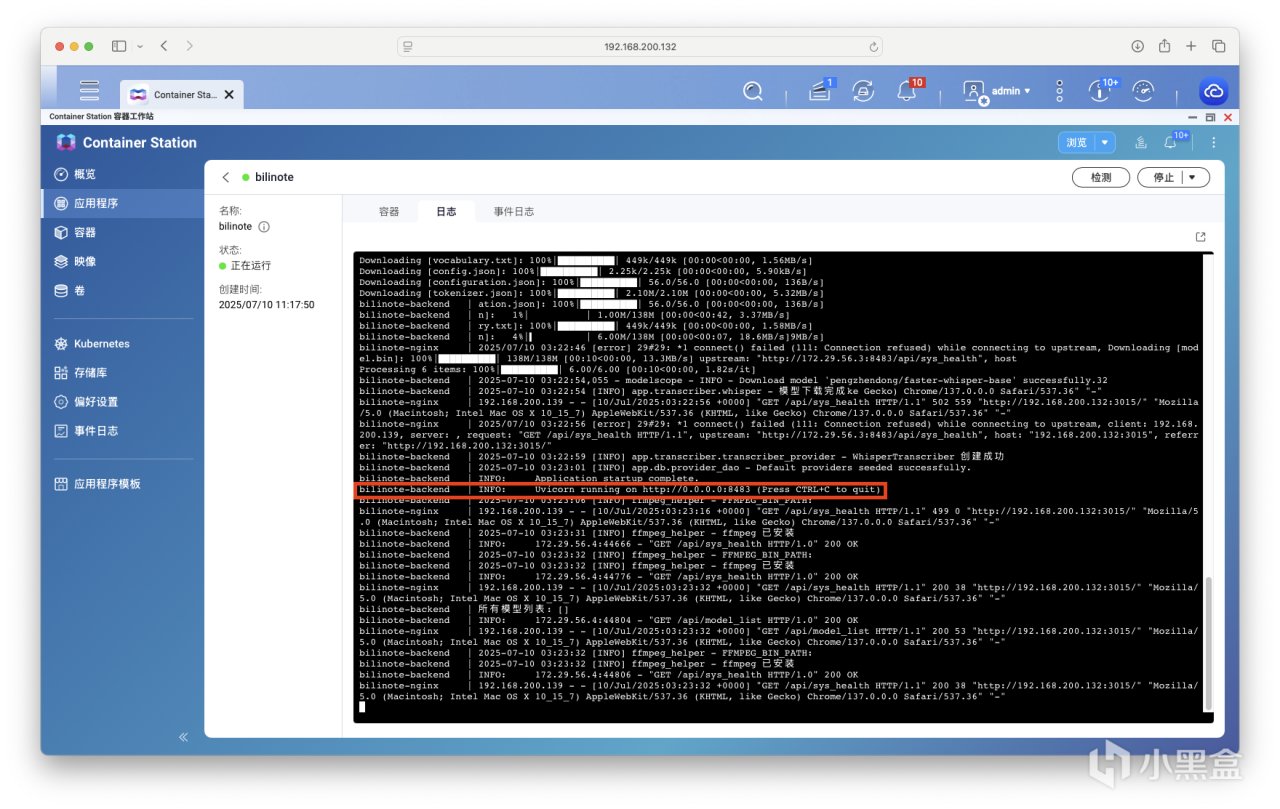

因爲項目問題,需要等系統初始化環境配置完成後纔可成功訪問並使用,如果你在日誌中看到以下輸出則證明部署成功,此時可以訪問前端界面。

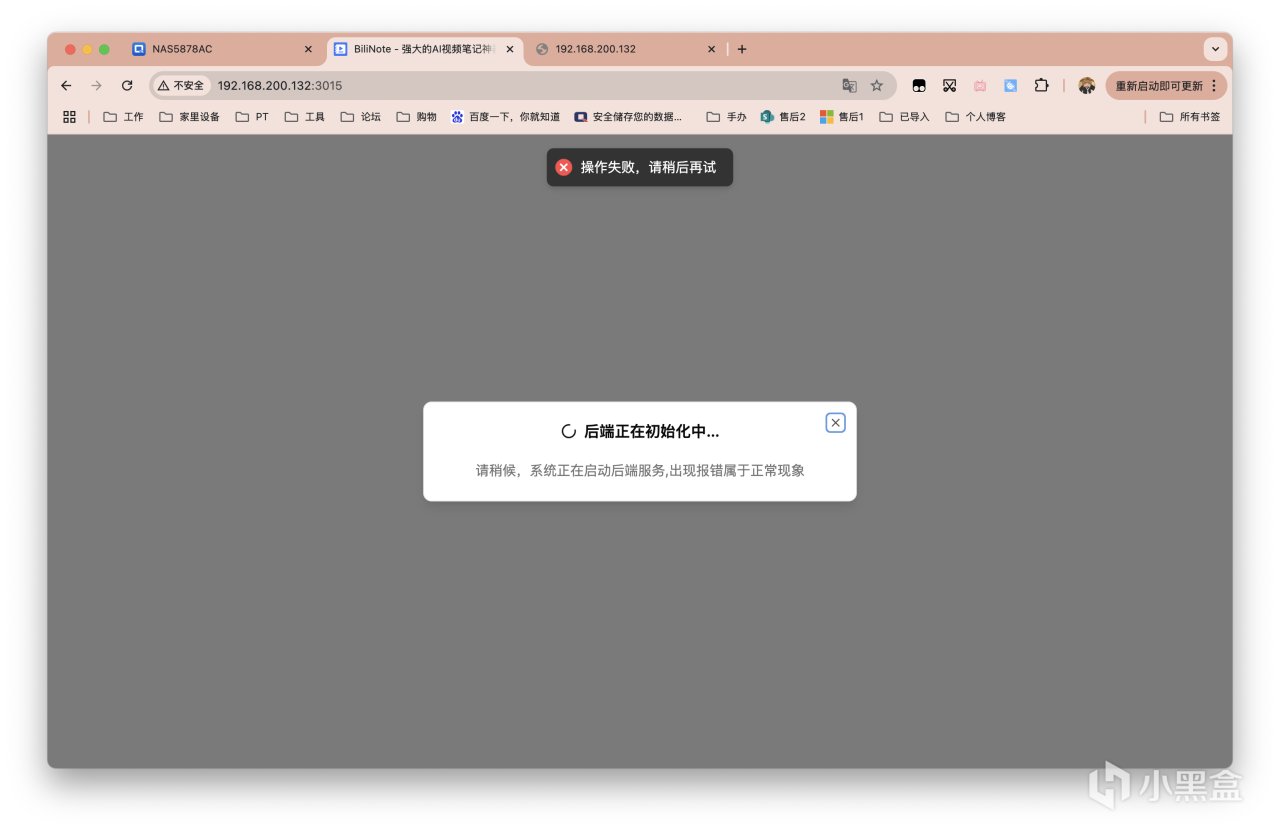

此時瀏覽器輸入NAS_IP:3015即可訪問。大概率會出現如下界面,提示報錯(大概率),再耐心等項目跑會兒。

我成功進入項目界面的日誌輸出如下,可作參考。此時便可使用了。

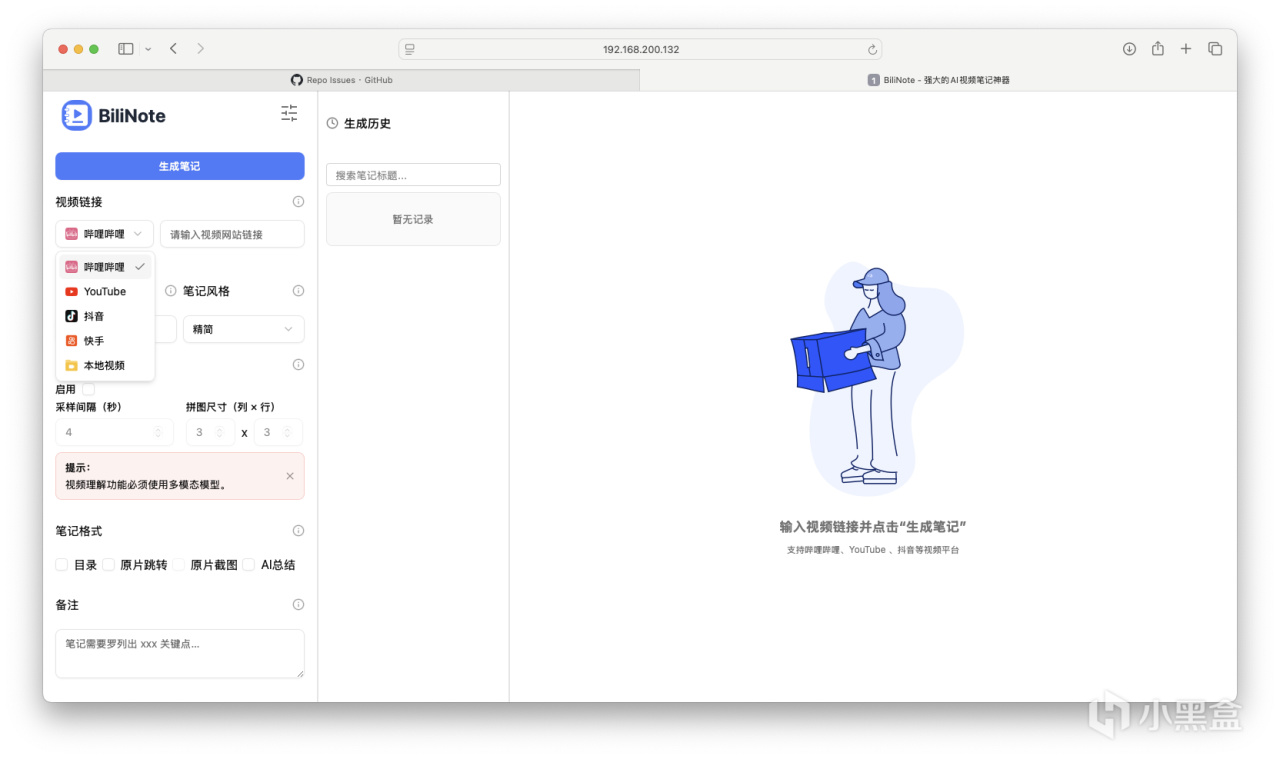

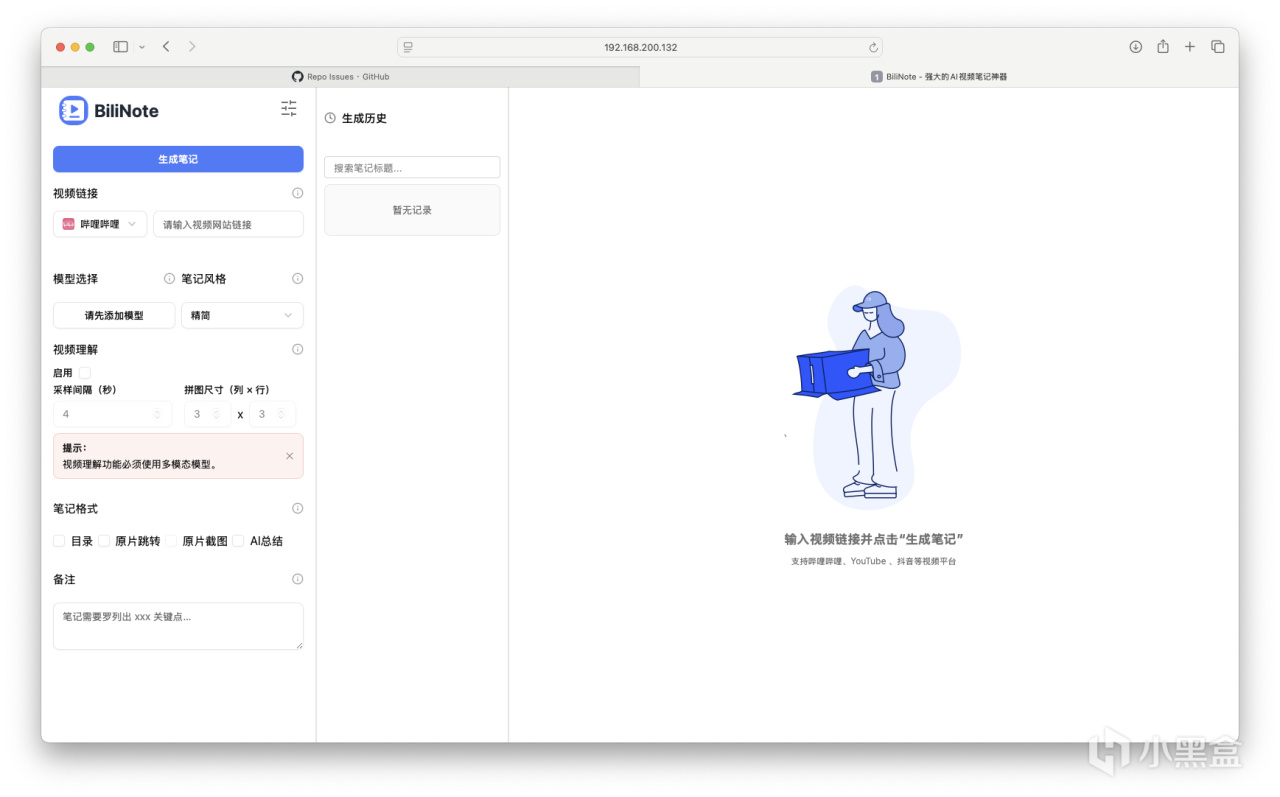

界面如下。支持B站、油管、快手、抖音的鏈接直接導入,也支持本地視頻導入。

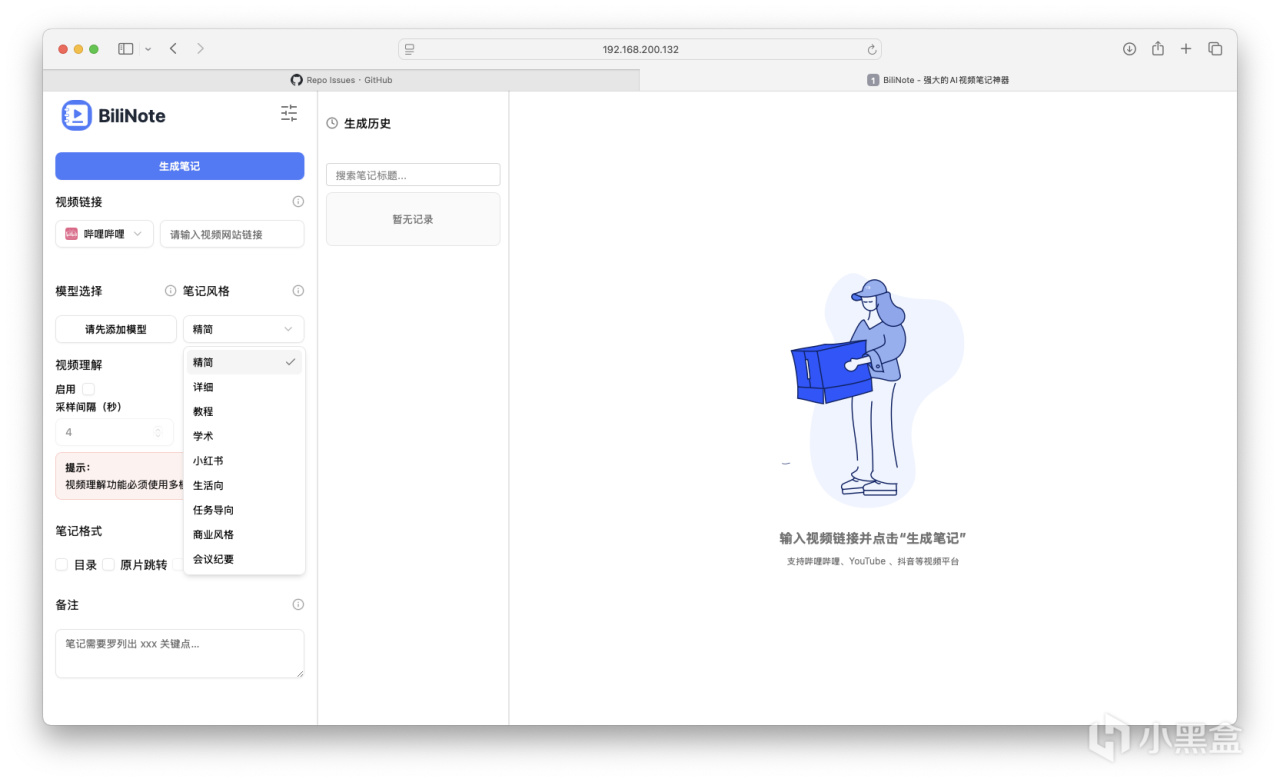

支持各種不同文案風格的輸出,可選擇目錄、原片跳轉/截圖、AI總結等多種輸出格式。

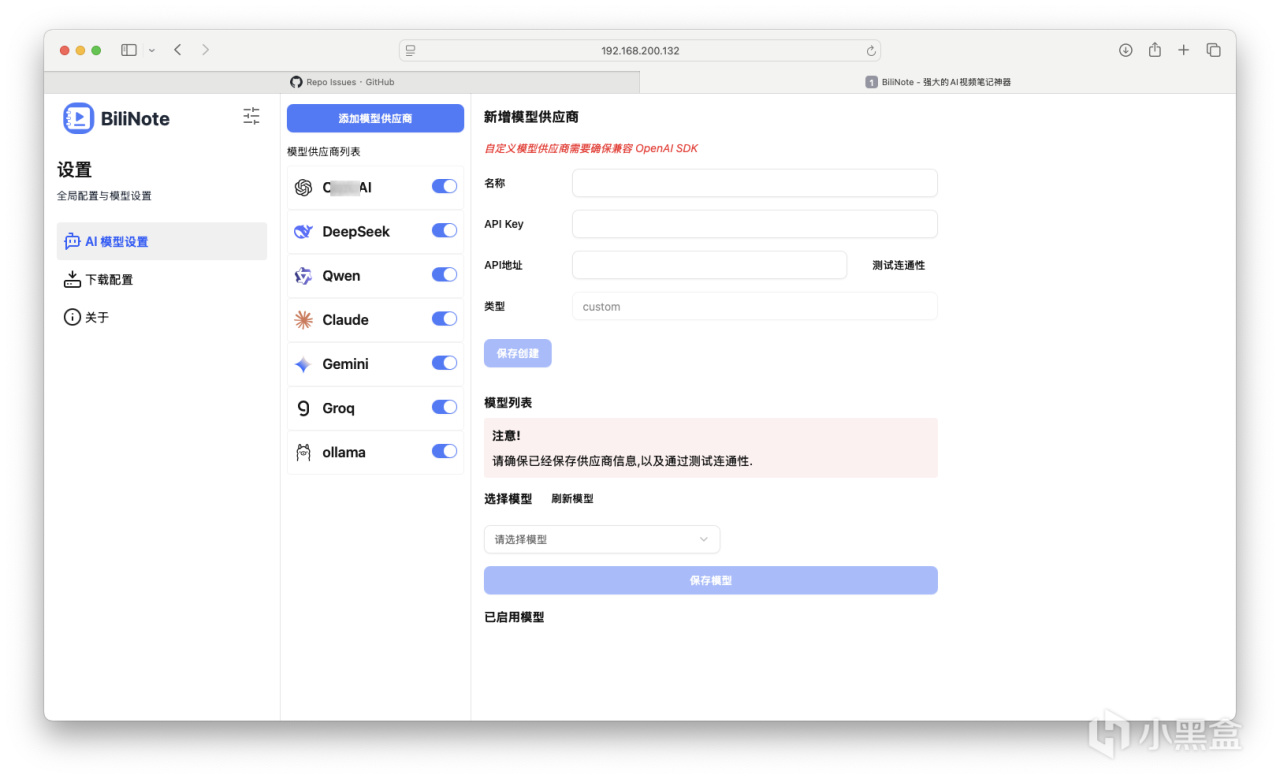

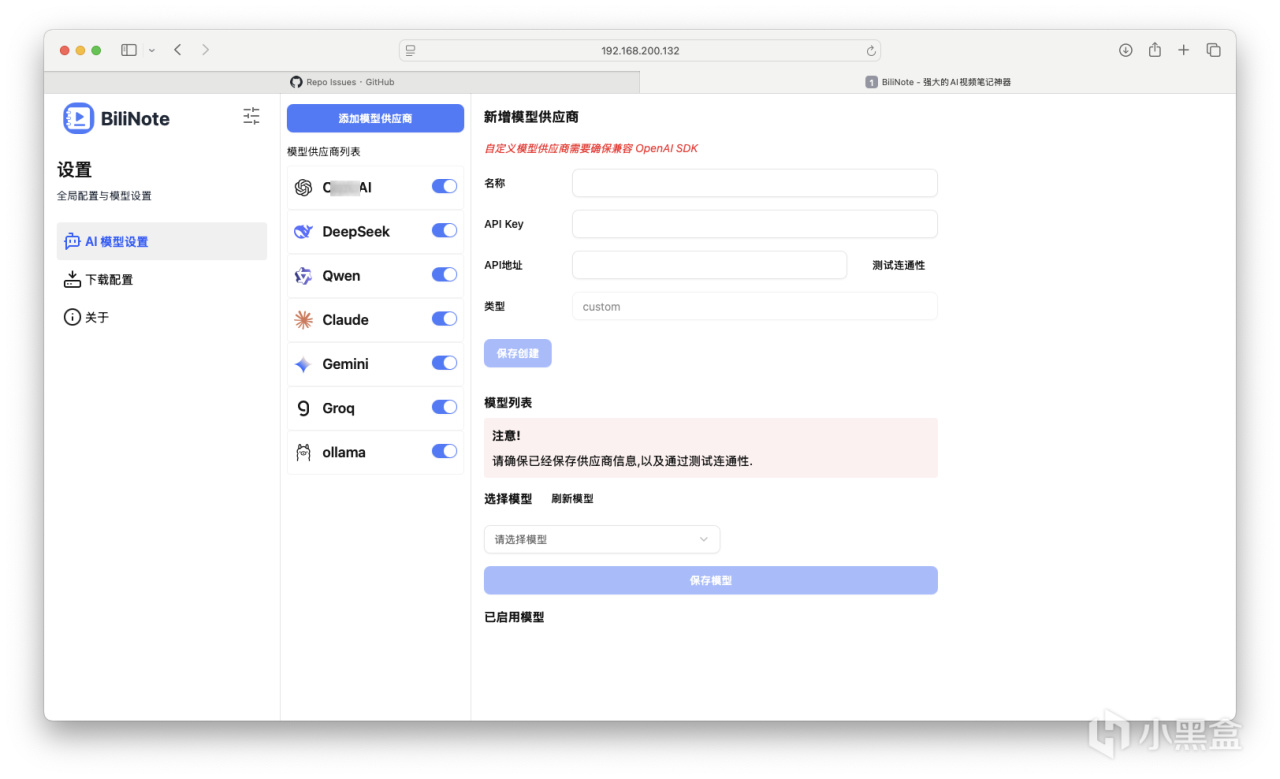

內置默認支持的大模型供應商如下,Ollama本地部署也同樣支持。如果要得到理想輸出結果,請選擇具備相應功能的大模型版本。關於API如何獲得使用還請自行搜索。(通義千問有白嫖福利)

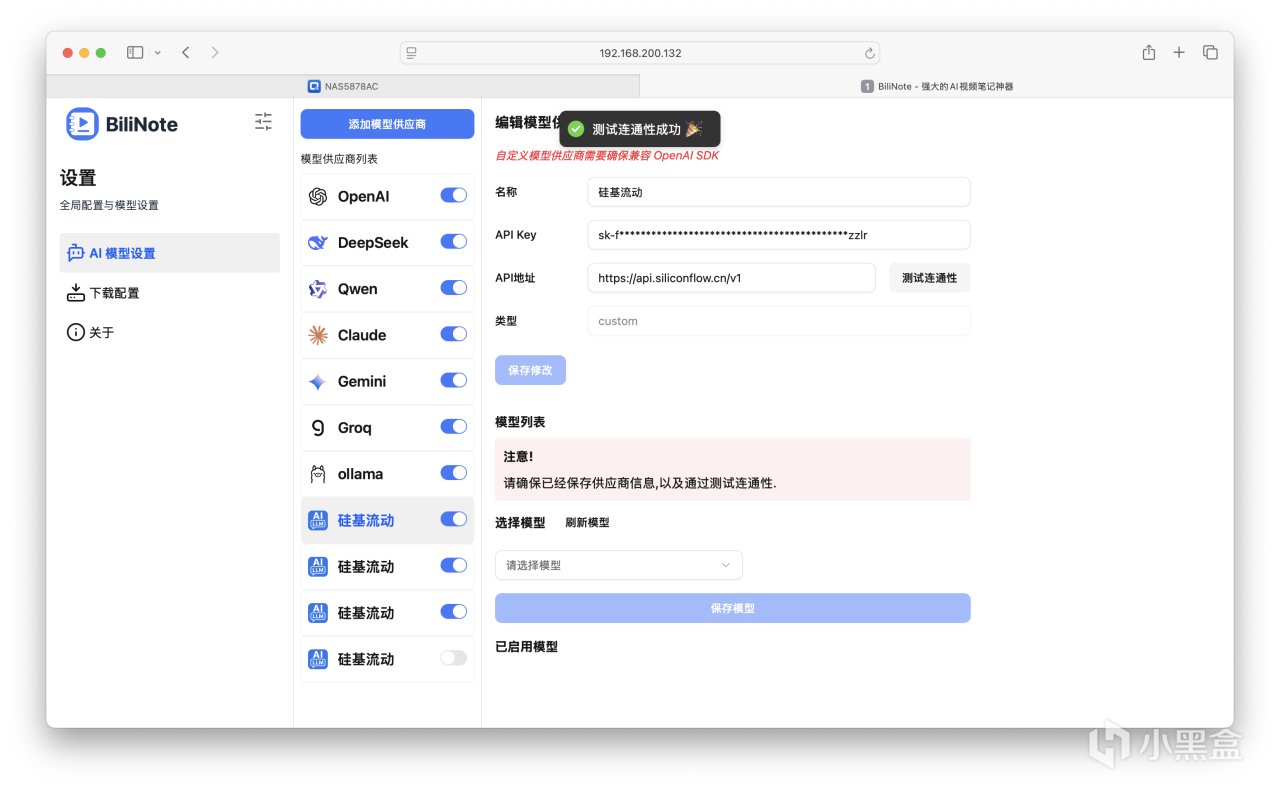

也可自行添加其他提供商例如硅基流動,不過要確保兼容性。

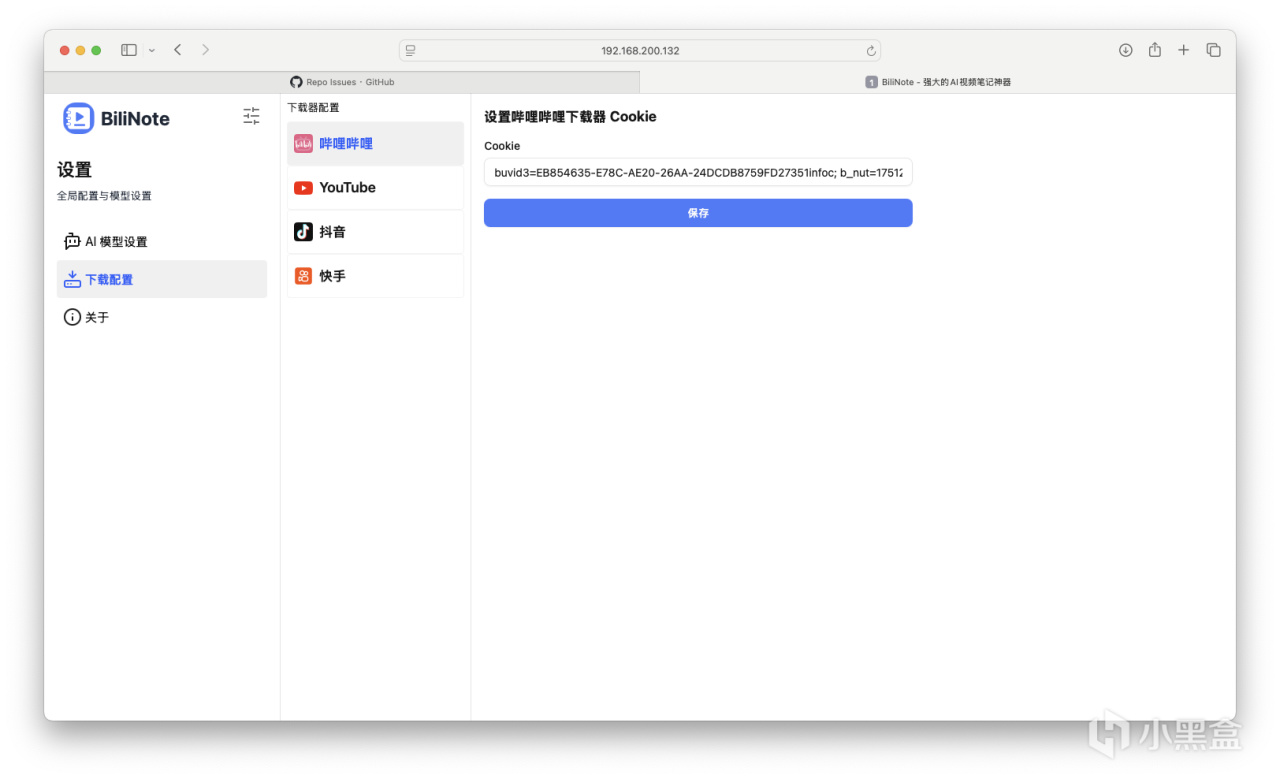

配置相關Cookie,這個也不再進行贅述。

下面我用油管鏈接進行演示。隨機刷到一個時長8min的三星手機評測,鏈接搞進去進行筆記生成。還蠻快的。動圖爲2.5倍速。

生成的效果如下。可以展示爲思維導圖,支持直接內容複製,可導出爲Markdown,支持原文參照。點擊時間戳,便可跳轉到對應的章節進行閱讀。

總結

原片跳轉這個功能我個人覺得非常實用,作者應該會在後增加直接導入字幕文件的總結功能。

大家有需要的建議搞個強一些的CPU或GPU進行部署~

感謝觀看,本文完。

PS:相關文件點我下載,提取碼:zLQV。

更多遊戲資訊請關註:電玩幫遊戲資訊專區

電玩幫圖文攻略 www.vgover.com