平时大伙儿用各种AI模型生图的时候,最心塞的时刻莫过于出了一张接近完美的画面,结果发现背景里多了一根电线杆,或者海报上的文字拼写错了。

总之就是有那么点令人不快的瑕疵。

如果你想稍微改动一下,即便是用了局部重绘,最后生成的图往往也跟原图关系不大。

这种抽奖式的生图体验,确实让很多设计师在尝鲜之后又默默打开了 Photoshop。

于是乎,阿里千问团队再次出手,开源了一个叫 Qwen-Image-Layered 的模型,试图从底层逻辑上解决这个问题。

他们给出的思路非常直白,既然人类设计师是靠分层作图的,那 AI 为什么不能学会分层。

以前的 AI 模型把图像看作是一堆像素的集合,所有的东西都焊死在一张画布上,你要改一点东西,模型就得重新猜剩下的像素长什么样。

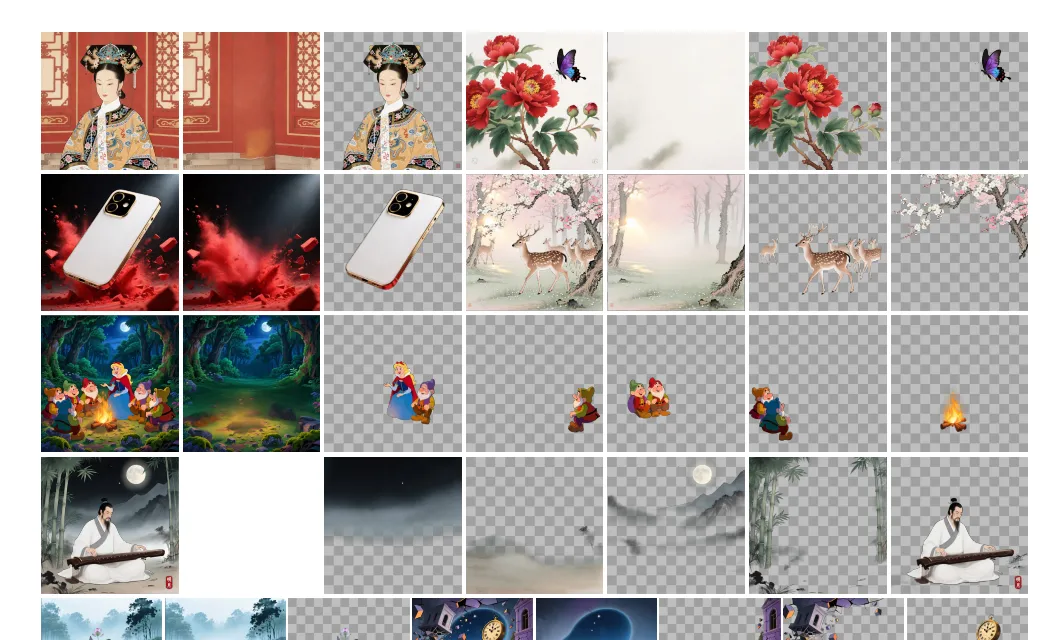

阿里这个新模型则是在内部实现了图层拆解,它能把一张平整的图片强行剥离成若干个 RGBA 图层。

所谓 RGBA 也就是带透明通道的图层,这意味着 AI 终于能看懂什么是主体,什么是背景,什么是漂浮在最上层的文字。

有了这个逻辑,很多以前让 AI 抓狂的操作就变得顺理成章了。

你想给第一个图层里的物体换个颜色,模型只需要处理那一层的像素,其他层物理隔离,根本不会发生偏移。你想把画面里的女孩换成男孩,或者是想把一段英文改成中文,模型都能在对应的图层上精准动刀。

更有意思的是,由于是分层操作,你现在甚至可以在 AI 生成的画布里自由地移动物体,或者是把某个元素放大缩小。

在传统的扩散模型里,这种操作几乎必然会导致背景出现扭曲或空洞,但在 Qwen-Image-Layered 这里,它知道每一层后面盖着什么,所以能实现所谓的零漂移编辑。

不过咱们有一说一,阿里的这个黑科技并不是没有门槛的。

如果你想在本地跑这个模型,显存要求可能会让你瞬间冷静下来,目前在 16 位浮点精度下,这玩意儿得吃掉 31G 的显存。

这意味着绝大多数家用显卡基本可以直接告别本地部署了,除非你手里有一张5090、40948或者是别的大显存专业计算卡(谁能v一张 RTX 6000Pro)。

而且从目前社区反馈的实测情况来看,这个模型也并非全能。

它更像是一个极其擅长处理海报、UI 设计稿的专家,对于那种边缘清晰、语义明确的平面设计作品,它的分层和修改效果好得惊人。

但如果是一张光影复杂、虚实结合的图片,它的拆图精度可能就没那么理想了(换人来其实也不行)。

现在的逻辑更像是拆图重绘,即模型先通过算法猜出图层,再针对单层进行扩散生成。这意味着如果你想追求极致的精准,可能还是得面对 AI 的不确定性,也就是大家常说的抽卡。

这里其实引出了一个问题:AI 厂商拼命往 PS 的地盘里钻,到底是想取代专业软件,还是只是在给现有生图流程打补丁?

有人觉得这是 AI 走向专业生产力的必经之路,毕竟不能编辑的图,在商业交付里就是废纸。

但也有人认为,高显存门槛加上生成随机性,让这类模型更像是秀肌肉的 Demo,而不是能直接上生产线的工具。

对设计师来说,真正的需求仅仅是需要“帮我把图层分好”,AI最好能听懂那些极其细微、甚至带点玄学的修改意见。

现在的 Qwen-Image-Layered 已经能完成换色、移动、删减这些重活,这确实是实打实的一步进展。

真正的争议在于:当 AI 越来越像 PS,我们究竟是离全自动设计更近了,还是只是把 PS 里的手动痛苦,换成了 AI 里的算力焦虑?

三十多 G 显存换来改字、换色、挪位置,这笔账对普通用户到底值不值?

可以预见的是,随着分层模型开源,轻量化插件大概率会出现。

如果显存门槛真能降到 16G 甚至 12G,PS 的护城河才可能松动。到那时,设计师也许真的只要动动嘴,剩下的就是看 AI 在图层面板里折腾。

至于这种只给结果、不留过程的创作方式,会不会让设计变得更好,亦或者是制造更多流水线工业品。

恐怕得等显存门槛降下来之后,才能真正见分晓。

但说到显存门槛,或者说跟“存”有关的电脑硬件我就想笑。

更多游戏资讯请关注:电玩帮游戏资讯专区

电玩帮图文攻略 www.vgover.com