平時大夥兒用各種AI模型生圖的時候,最心塞的時刻莫過於出了一張接近完美的畫面,結果發現背景裏多了一根電線杆,或者海報上的文字拼寫錯了。

總之就是有那麼點令人不快的瑕疵。

如果你想稍微改動一下,即便是用了局部重繪,最後生成的圖往往也跟原圖關係不大。

這種抽獎式的生圖體驗,確實讓很多設計師在嚐鮮之後又默默打開了 Photoshop。

於是乎,阿里千問團隊再次出手,開源了一個叫 Qwen-Image-Layered 的模型,試圖從底層邏輯上解決這個問題。

他們給出的思路非常直白,既然人類設計師是靠分層作圖的,那 AI 爲什麼不能學會分層。

以前的 AI 模型把圖像看作是一堆像素的集合,所有的東西都焊死在一張畫布上,你要改一點東西,模型就得重新猜剩下的像素長什麼樣。

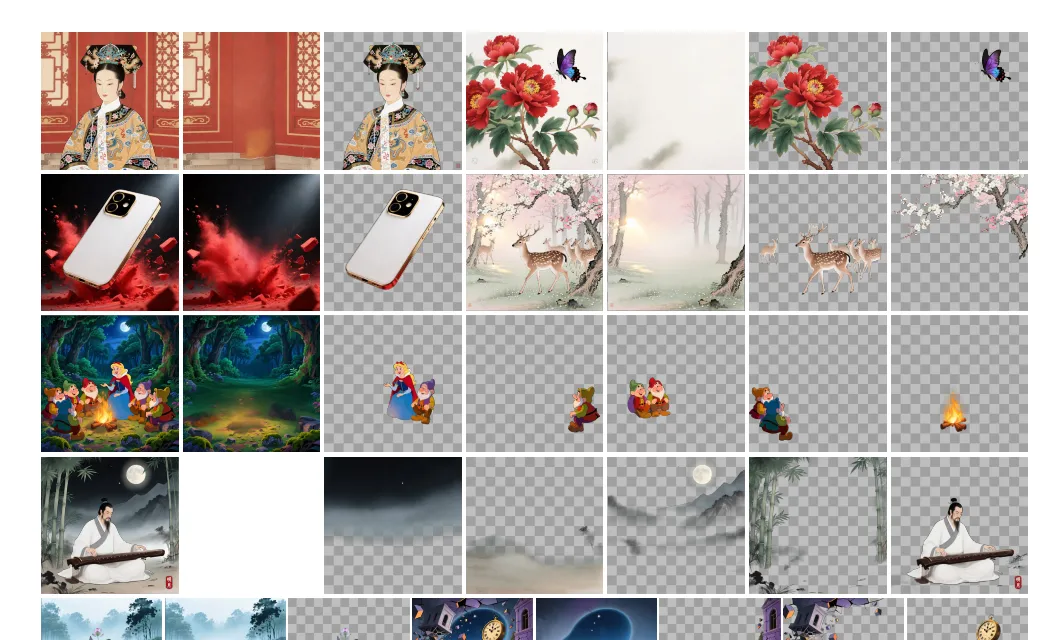

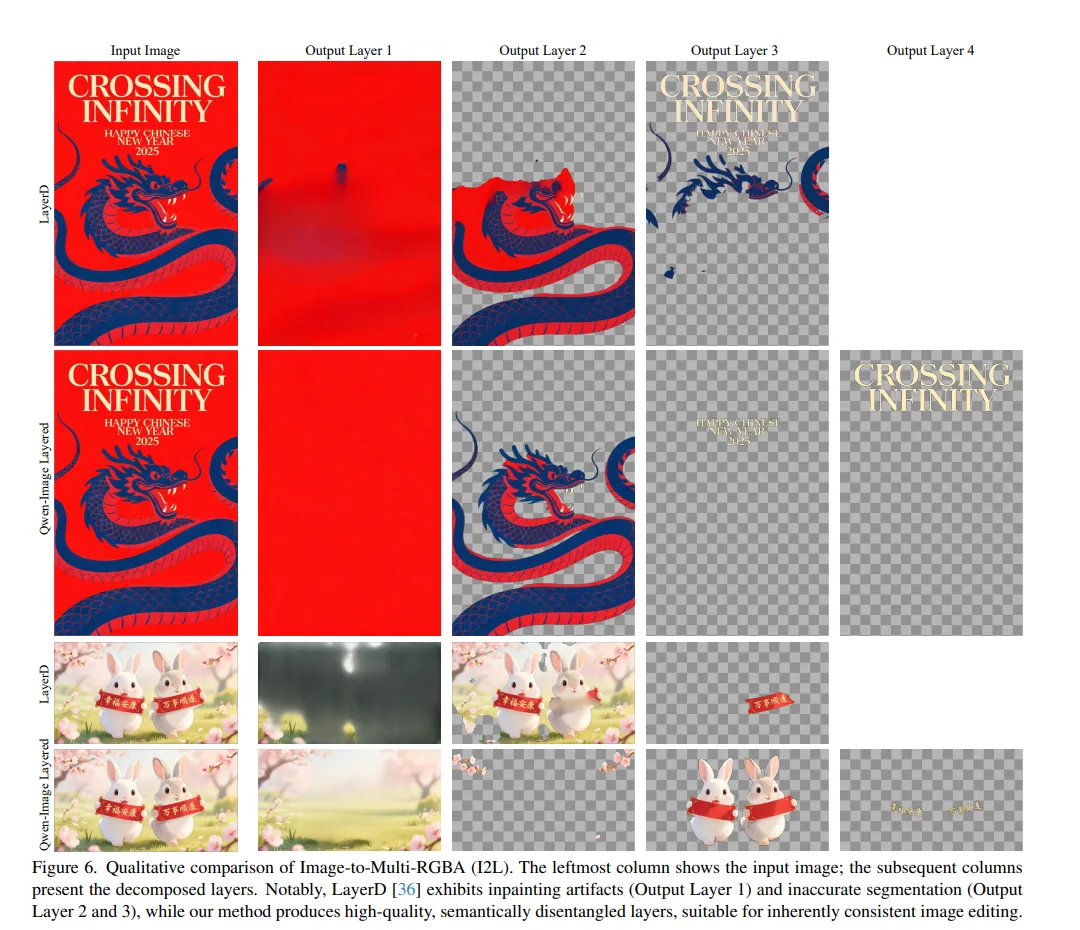

阿里這個新模型則是在內部實現了圖層拆解,它能把一張平整的圖片強行剝離成若干個 RGBA 圖層。

所謂 RGBA 也就是帶透明通道的圖層,這意味着 AI 終於能看懂什麼是主體,什麼是背景,什麼是漂浮在最上層的文字。

有了這個邏輯,很多以前讓 AI 抓狂的操作就變得順理成章了。

你想給第一個圖層裏的物體換個顏色,模型只需要處理那一層的像素,其他層物理隔離,根本不會發生偏移。你想把畫面裏的女孩換成男孩,或者是想把一段英文改成中文,模型都能在對應的圖層上精準動刀。

更有意思的是,由於是分層操作,你現在甚至可以在 AI 生成的畫布裏自由地移動物體,或者是把某個元素放大縮小。

在傳統的擴散模型裏,這種操作幾乎必然會導致背景出現扭曲或空洞,但在 Qwen-Image-Layered 這裏,它知道每一層後面蓋着什麼,所以能實現所謂的零漂移編輯。

不過咱們有一說一,阿里的這個黑科技並不是沒有門檻的。

如果你想在本地跑這個模型,顯存要求可能會讓你瞬間冷靜下來,目前在 16 位浮點精度下,這玩意兒得喫掉 31G 的顯存。

這意味着絕大多數家用顯卡基本可以直接告別本地部署了,除非你手裏有一張5090、40948或者是別的大顯存專業計算卡(誰能v一張 RTX 6000Pro)。

而且從目前社區反饋的實測情況來看,這個模型也並非全能。

它更像是一個極其擅長處理海報、UI 設計稿的專家,對於那種邊緣清晰、語義明確的平面設計作品,它的分層和修改效果好得驚人。

但如果是一張光影複雜、虛實結合的圖片,它的拆圖精度可能就沒那麼理想了(換人來其實也不行)。

現在的邏輯更像是拆圖重繪,即模型先通過算法猜出圖層,再針對單層進行擴散生成。這意味着如果你想追求極致的精準,可能還是得面對 AI 的不確定性,也就是大家常說的抽卡。

這裏其實引出了一個問題:AI 廠商拼命往 PS 的地盤裏鑽,到底是想取代專業軟件,還是隻是在給現有生圖流程打補丁?

有人覺得這是 AI 走向專業生產力的必經之路,畢竟不能編輯的圖,在商業交付裏就是廢紙。

但也有人認爲,高顯存門檻加上生成隨機性,讓這類模型更像是秀肌肉的 Demo,而不是能直接上生產線的工具。

對設計師來說,真正的需求僅僅是需要“幫我把圖層分好”,AI最好能聽懂那些極其細微、甚至帶點玄學的修改意見。

現在的 Qwen-Image-Layered 已經能完成換色、移動、刪減這些重活,這確實是實打實的一步進展。

真正的爭議在於:當 AI 越來越像 PS,我們究竟是離全自動設計更近了,還是隻是把 PS 裏的手動痛苦,換成了 AI 裏的算力焦慮?

三十多 G 顯存換來改字、換色、挪位置,這筆賬對普通用戶到底值不值?

可以預見的是,隨着分層模型開源,輕量化插件大概率會出現。

如果顯存門檻真能降到 16G 甚至 12G,PS 的護城河纔可能鬆動。到那時,設計師也許真的只要動動嘴,剩下的就是看 AI 在圖層面板裏折騰。

至於這種只給結果、不留過程的創作方式,會不會讓設計變得更好,亦或者是製造更多流水線工業品。

恐怕得等顯存門檻降下來之後,才能真正見分曉。

但說到顯存門檻,或者說跟“存”有關的電腦硬件我就想笑。

更多遊戲資訊請關註:電玩幫遊戲資訊專區

電玩幫圖文攻略 www.vgover.com

![[Ra]分享我的離譜剪髮和租房經歷](https://imgheybox1.max-c.com/web/bbs/2025/12/23/4325011c749e311da2b9e452b93ac760.png?imageMogr2/auto-orient/ignore-error/1/format/jpg/thumbnail/398x679%3E)