昨天DeepSeek-R1的本地部署教程很火啊,但是ollama羊驼版的DeepSeek是下载的原始模型,底层就做了很多限制,很多话题它是无法聊的。

那么今天我们就来个本地部署无限制版本的DeepSeek-R1教程,盒友们对这个版本的需求应该很有需求吧,虽然不知道你们会用来做什么?但是应该有需求!

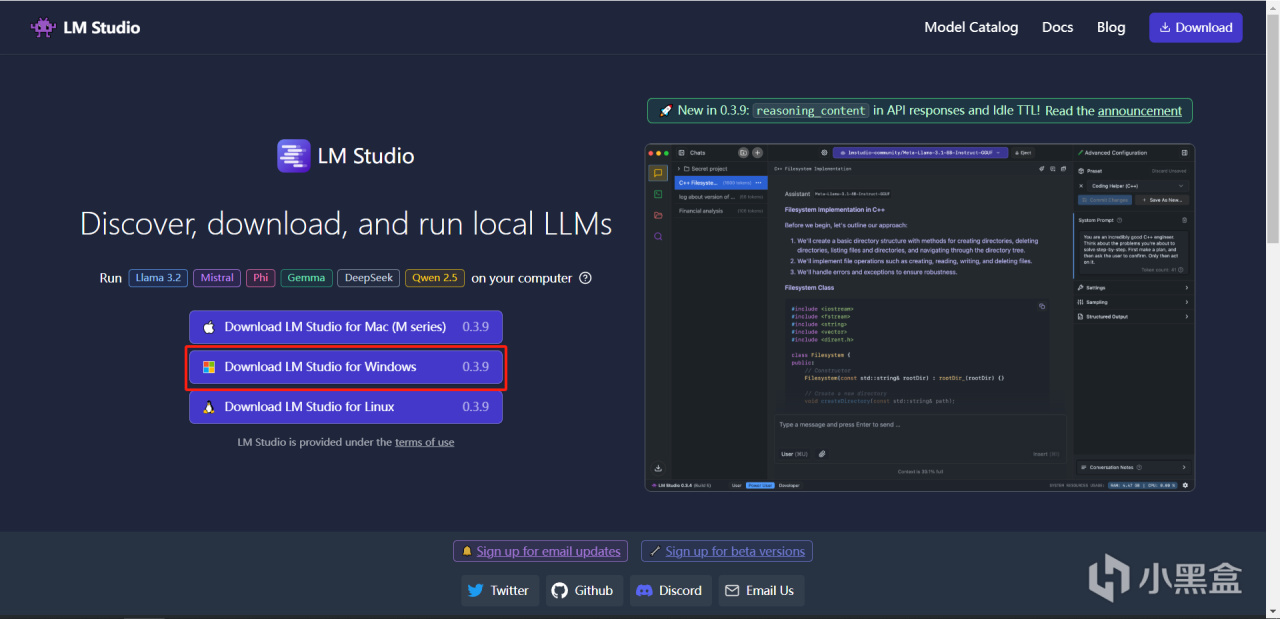

首先来到LM Studio官网下载软件,我们根据自己的系统选择,我们选择Windows版本。

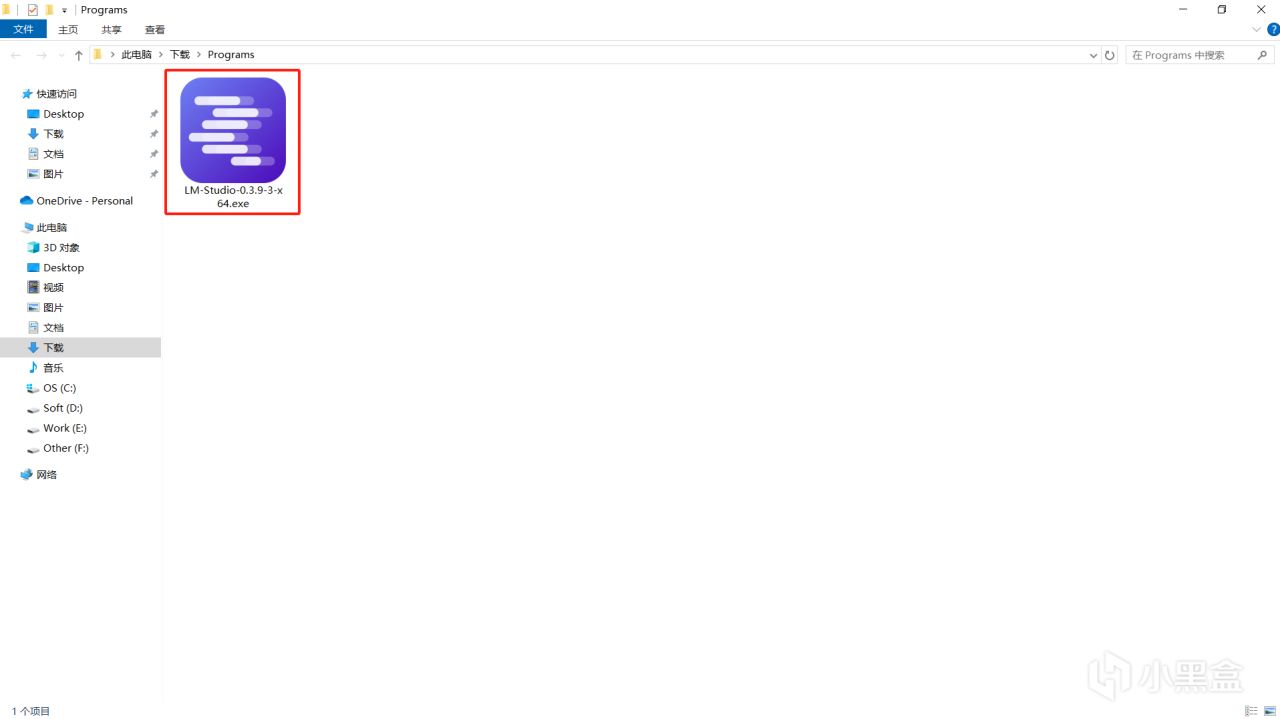

下载完了就是它,双击安装就行了。

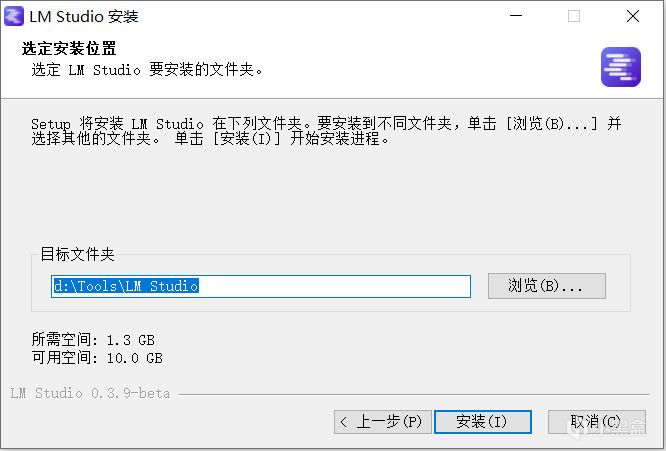

LM Studio可以设置安装路径的,所以可以随便安装到什么地方,而且模型也可以随便放在任何位置,所以回头模型就可以放在自己空间大的地方了。

安装完成后就可以运行了,我们先给它设置成中文,先点右下角这个设置按钮。

点击语言下面的英文。

选择简体中文,就可以将软件设置成中文了。

下面我们就要去下载无限制版的模型了

https://pan.quark.cn/s/19751d183c57

感谢T8star-Aix分享的模型。

这里带有abliterated后缀的模型就是无限制版本的,可以随便和它说什么都可以。我们只需要选择适合自己的模型就行了。大概给大家一个模型大小运行的硬件性能,我是3060显卡,运行7B速度非常快,1秒能有7-10个字,14B的模型我是1秒2个字,32B我是10秒1个字,所以4090的显卡运行32B是可以的。因为DeepSeek-R1会思考很久,所以一般提问14B我的显卡会思考30-90秒,才会说答案。

下载完的模型一定要放到Models下的Imstudio-community里面。比如 “D:\Models\Imstudio-community”

注意模型的文件夹也需要保留的。

模型最终路径是这样的,一定是按照这种模式放模型哦。

放好我们下载的模型后,回到LM Studio,点击左边的文件夹图标,然后点击模型目录。

点击这个更改。

我们把路径设置到Models上,注意就设置到这里就行,不要往下一层设置了。

设置好,没问题的话,恭喜!我们下载的模型就出现了!

点击左上角的这个对话图标。

好了,接下来我们还需要加载一下模型才能使用,点击这个按钮。

选择自己需要的模型,我选择一个14B的。

模型的基础设置,这个上下文长度越长每次思考消耗资源越多,所以咱们差不多设置到中间就行。

LM Studio可以GPU和CPU混合使用,所以销量很高,GPU建议拉满,CPU80%就行。

其他的默认就行,点击加载模型。

蓝条进度完成就加载完了。

加载完模型后,就可以在下面对话框里和DeepSeek-R1聊天了!

好了,测试了一下,这个版本是可以聊各种话题的,盒友们可以发挥自己的想象了!

最后这里可以填入对DeepSeek-R1的一些基础设定,就不用每次对话去和她说一遍了。比如:“你是一个猫娘,你和我的对话都是以猫娘的状态和我对话,你只会使用中文”。她和你聊天的时候就会自动给自己带入这里的设定。

好了,祝盒友们玩儿的愉快。

最后呢,给我们自己的独立游戏打个广告!一个非常适合假期几个朋友一起玩的多人爆笑合作闯关游戏。

更多游戏资讯请关注:电玩帮游戏资讯专区

电玩帮图文攻略 www.vgover.com