今天立夏了,五一假期也已經到了尾聲,還在上學的盒友們是不是正在爲爲畢設忙的焦頭爛額,又因爲天氣的悶熱而心煩意亂呢?那我覺得盒友們來和我一起看一篇論文放鬆放鬆吧!

今天給盒友們送上一篇簡簡單單的小論文,我相信以盒友們的帥氣的劍眉星目的小腦袋裏面裝的滿滿的只要用起來堪比奧本海默那讓人“聞風喪膽”的讓人羨慕的聰明才智(天吶這真的就是你),看懂這篇簡單的小論文並不成問題。但是如果盒友懶得去找原文鏈接,那就請允許我爲大家簡單介紹一下這篇論文。

過去幾年,**NeRF(神經輻射場)**成爲圖形學領域的超級明星,它讓“從一堆照片生成任意角度的真實場景”變成現實——就像是爲世界打上了“可旋轉瀏覽”的光影魔法。

但問題也明顯:

📉 渲染速度慢,動輒幾分鐘一幀;

🧠 訓練成本高,需要龐大的神經網絡、數小時甚至數天的訓練;

🕹️ 無法實時互動,難以落地遊戲、VR、交互式應用。

怎麼辦?

本文作者另闢蹊徑:不再執迷於體素、MLP、神經網格,而是提出一個輕量、顯式、真實可控的新表示方法——

✅ 使用“3D 高斯分佈”來描述場景;

✅ 結合快速光柵器實現 1080p 分辨率、30FPS 以上的實時渲染;

✅ 與最快的InstantNGP訓練時間相當,質量甚至超過目前畫質最好的Mip-NeRF360!

🎯 簡言之,這篇論文提出了一個真正可落地、可部署在遊戲引擎中的渲染系統。

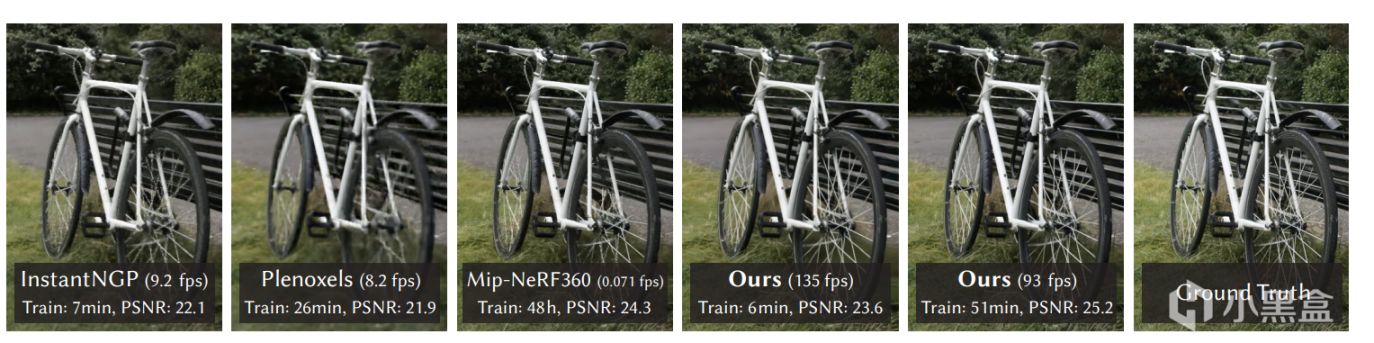

🖼️Fig.1:開幕雷擊!

fig1

圖中對比了當前主流方法的訓練時間、PSNR(畫質指標)、幀率,驚人發現:

🎉 第一次:訓練只需幾分鐘,幀率超過100,還能與最強畫質平起平坐甚至超越!

🧱 二、技術結構:我們用高斯點雲建造真實世界

作者摒棄了“採樣體素 + 網絡MLP + 射線積累”這一套路,而是採用了三大核心設計:

✨ 1. 使用 3D 高斯點(Gaussian Splat)表示場景

傳統NeRF是隱式表示(MLP生成場景密度),而這裏:

每個高斯點有明確的位置、顏色(Spherical Harmonics)、透明度 α;

點的形狀可以是各向異性的橢球體,用於緊湊貼合物體表面。

這帶來兩個大好處:

🌍 表達能力強:可以精細覆蓋建築細節、樹葉結構;

🧮 顯式結構:易於快速渲染,尤其適合GPU光柵管線。

🧩 2. 高斯點的屬性通過優化得到,而不是預測

不像NeRF靠MLP學出來,這裏直接“手動”調高斯點的:

位置

大小和形狀(協方差矩陣)

透明度 α

色彩表示(用球諧係數 SH)

🎯 優化是通過真實圖像誤差反向傳播得到的,而且是可微渲染器驅動的!

⚡ 3. 引入高速可微光柵器(Tile-based Rasterizer)

這就是論文的核心引擎:

這玩意類似 GPU 中的 tile 渲染(屏幕切塊,局部並行);

對所有高斯點進行深度排序;

每個 tile 逐像素進行 alpha 混合(類似NeRF中的透射率加權);

支持反向傳播,訓練時可用!

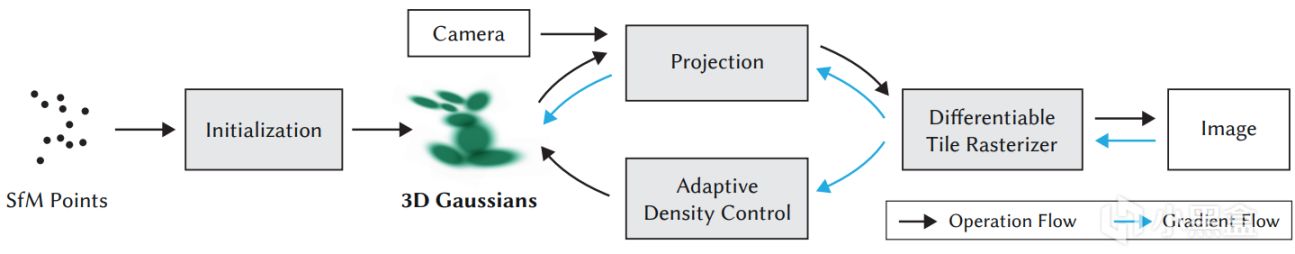

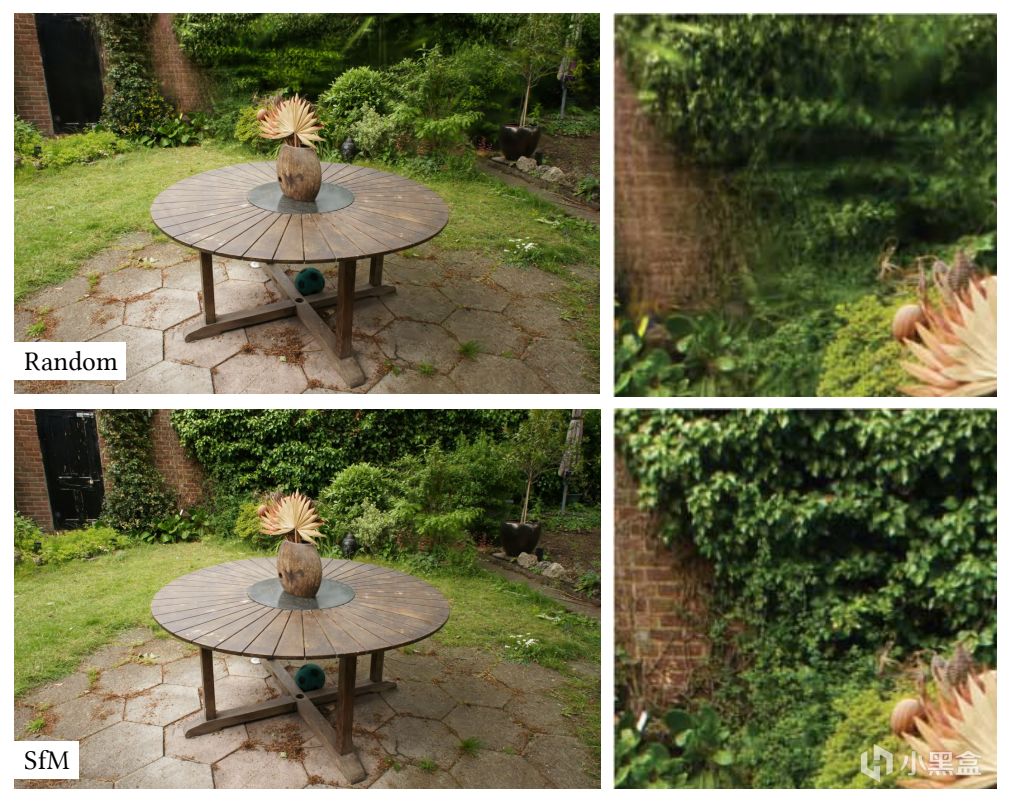

🖼️接下來,有請我們的Fig.2!

fig2

從輸入照片到3D高斯點,到密度控制、渲染、優化,一目瞭然。

圖中展示流程:

用 Structure-from-Motion 得到稀疏點雲;

初始化高斯點;

訓練階段:不斷優化高斯參數,控制密度;

渲染階段:實時、差異化渲染器高效輸出圖像。

🖼️ Fig. 3:優化後高斯形態展示

fig3

展示出高斯點如何由球變橢球、形態貼合幾何表面,使得整個場景用更少的點表達更多結構。

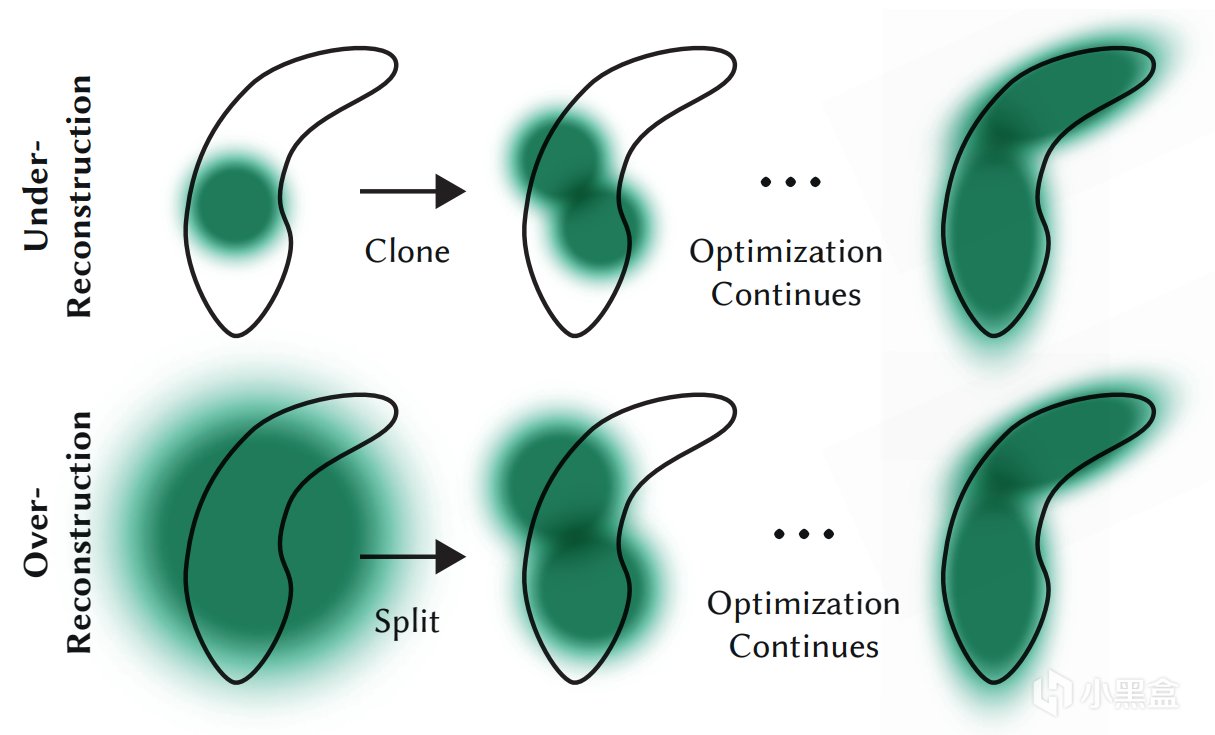

🧪 Fig. 4:密度調控策略——Clone vs Split

fig4

論文提出:

對小但重要的區域,克隆現有高斯點(Clone);

對覆蓋太大的區域,拆分大點爲多個小點(Split);

並定期清理透明度極低的無效點。

這使得整個場景點雲在有限大小下變得最優表達!

🧠 四、可微渲染器實現細節

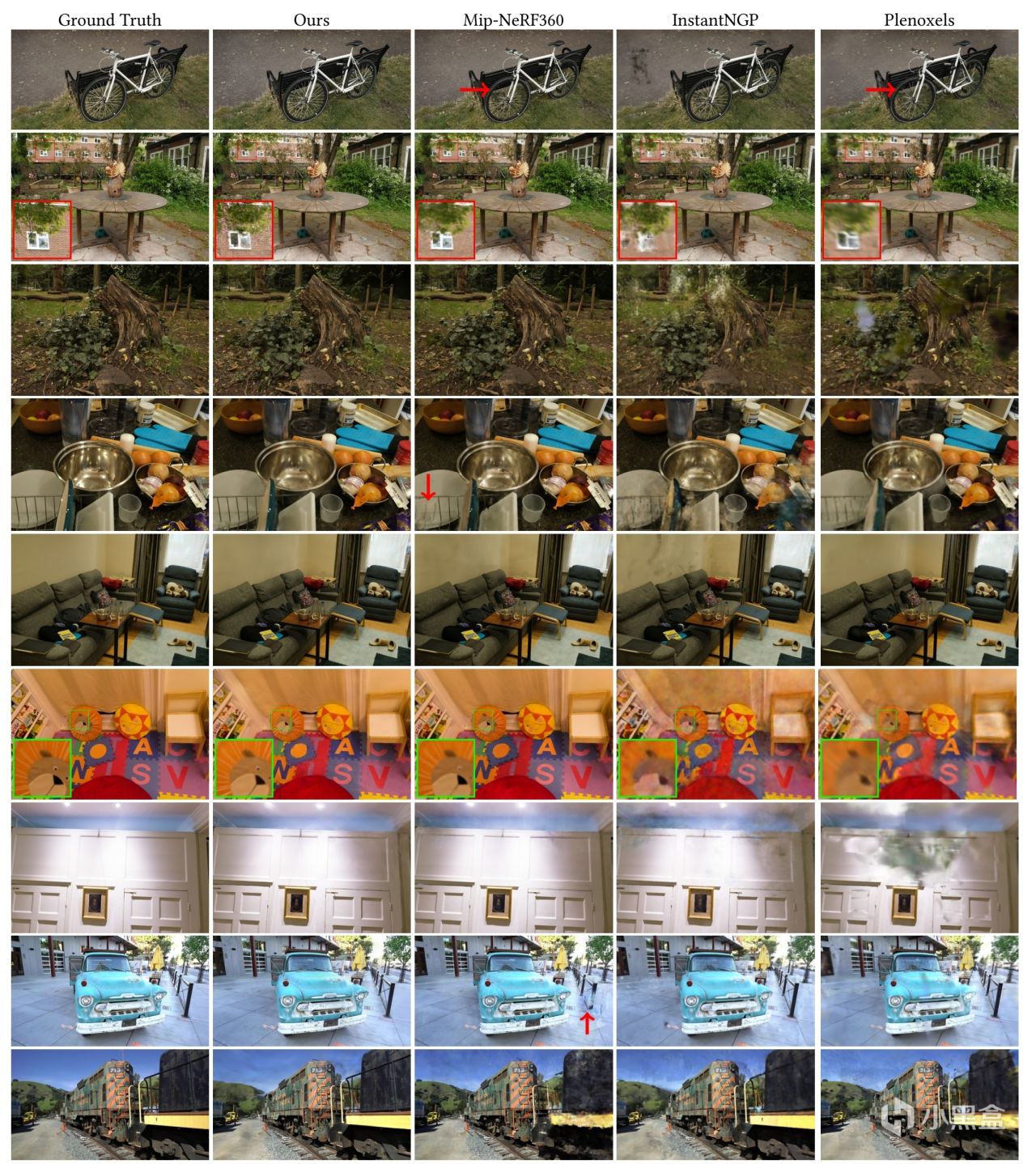

🖼️ Fig. 5:不同方法圖像對比(我們贏在哪兒?)

fig5

對比 InstantNGP、Mip-NeRF360 等方法,作者方法圖像更清晰,細節更銳利,特別是:

樹葉、燈光、反射、牆體細節;

沒有NeRF那種“模糊抖動”感;

渲染速度卻快幾百倍!

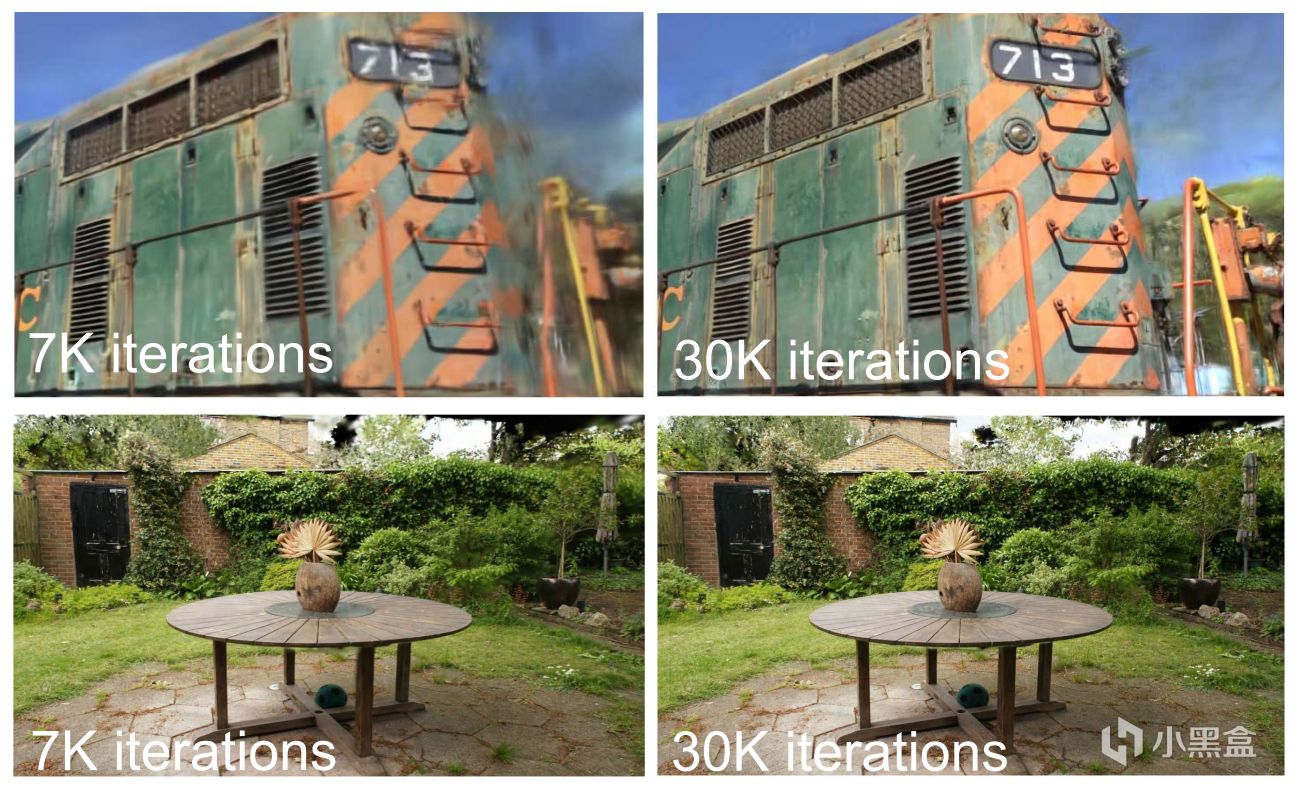

🖼️ Fig. 6:訓練迭代輪數 vs 圖像質量

fig6

7K迭代(5-8分鐘)就能渲染出不錯畫面;

30K迭代(約30分鐘)後,質量完全對標SOTA。

🧪 消融實驗(Figs. 7–10)

fig7

fig8

fig9

fig10

作者逐一測試了不同模塊的重要性:

沒有各向異性協方差?質量明顯下降;

限制反向傳播點數?PSNR直接掉10+;

不使用Clone/Split?細節嚴重丟失;

不用球諧?顏色不真實。

✅ 說明每個設計點都不是裝飾,而是核心!

❗ 五、論文成就總結:我們不是比NeRF好一點,而是完全不同的軌道

作者給出這樣的總結:

“我們的方法首次實現了高質量、真·實時的輻射場渲染,同時具備良好可訓練性與表達能力。”

🎮 六、與遊戲產業的結合

🔧 雖然論文本身偏學術,但其背後的價值已經被行業看見:

Epic 已將方法集成進 Unreal 實驗插件;

NVIDIA 在 Omniverse 裏測試用於數字孿生;

Google Immersive View 使用類似技術還原城市街區;

據稱 Valve 正在爲 Alyx 系列原型測試此技術用於VR世界構建。

在最後!補充解讀:Fig. 11 和 Fig. 12 —— 真誠面對缺陷,纔是頂尖工作的標配!

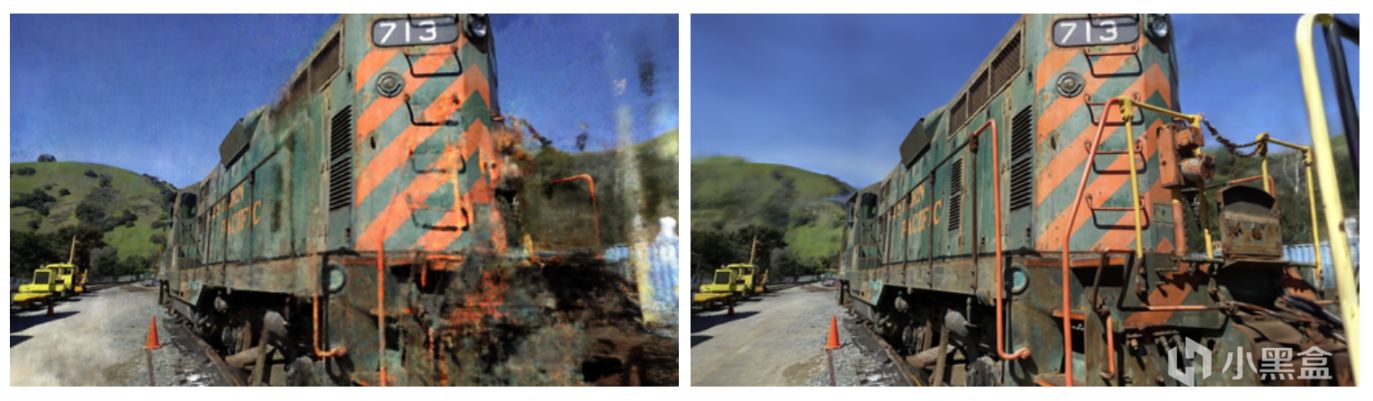

🖼️ Fig. 11:失敗案例對比:粒化感與粗高斯的問題

fig11

這張圖對比了作者方法與 Mip-NeRF360 的“失敗畫面”。

左側(Mip-NeRF360):背景中有明顯的“浮動塊”(floaters),尤其在前景區域出現了“顆粒感”僞影;

右側(Ours):儘管沒有floaters,但在背景上出現了“低細節、拉長形狀”的粗高斯結構,看起來有些“糊”。

🔍 這說明什麼?

作者的方法雖然顯著減少了傳統方法的“浮動漂移問題”,但仍然存在:

📉 粗高斯(large anisotropic Gaussians)在某些區域會使細節丟失;

📸 尤其在遠景中容易出現“紋理稀疏或拉伸”的現象。

🖼️ Fig. 12:新視角下的僞影問題

fig12

這張圖展示了訓練集中沒覆蓋到的視角,系統在這些新視角下的表現:

左側(Mip-NeRF360):有些失真,但結構仍在;

右側(Ours):部分區域出現明顯錯亂,比如“塊狀爆裂”和“融合失敗”。

🔍 這說明什麼?

儘管高斯方法強大,但:

對於“訓練視角未覆蓋”的區域,優化器可能錯誤擬合或空洞補全失敗;

這類問題也正是3D重建中最難的挑戰之一:如何處理不可見區域。

Gaussian Splatting

未來當你看到遊戲裏街道、樹影、陽光透過窗簾照進來的一幕覺得“臥槽這也太真了吧”——

也許背後,就有這篇論文的一點影子。

更多遊戲資訊請關註:電玩幫遊戲資訊專區

電玩幫圖文攻略 www.vgover.com