快科技11月16日消息,正在舉行的微軟Iginte全球技術大會上,微軟發佈一系列AI相關的全新優化模型、開發工具資源,幫助開發者更深入地釋放硬件性能,拓展AI場景。

尤是對於當下在AI領域佔據絕對主導地位的NVIDIA來說,微軟這次送上了一份大禮包,無論是面向OpenAI Chat API的TensorRT-LLM封裝接口,還是RTX驅動的性能改進DirectML for Llama 2,以及其他熱門大語言模型(LLM),都可以在NVIDIA硬件上獲得更好的加速和應用。

其中,TensorRT-LLM是一款用於加速LLM推理的庫,可大大提升AI推理性能,還在不斷更以支持越來越多的語言模型,而且它還是開源的。

就在10月份,NVIDIA也發佈了面向Windows平臺的TensorRT-LLM,在配備RTX 30/40系列GPU顯卡的臺式機、筆記本上,只要顯存不少於8GB,就可以更輕鬆地完成要求嚴苛的AI工作負載。

現在,Tensor RT-LLM for Windows可以通過全新的封裝接口,與 OpenAI 廣受歡迎的聊天 API 兼容,因此可以在本地直接運行各種相關應用,而不需要連接雲端,有利於在 PC 上保留私人和專有數據,防範隱私泄露。

只要是針對TensorRT-LLM優化過的大語言模型,都可以與這一封裝接口配合使用,包括Llama 2、Mistral、NV LLM,等等。

對於開發者來說,無需繁瑣的代碼重寫和移植,只需修改一兩行代碼,就可以讓AI應用在本地快速執行。

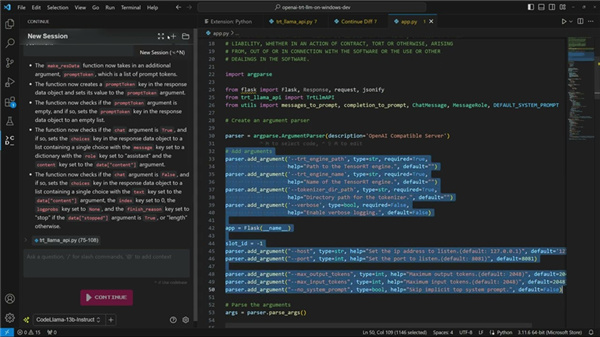

↑↑↑基於TensorRT-LLM的微軟Visual Studio代碼插件——Continue.dev編碼助手

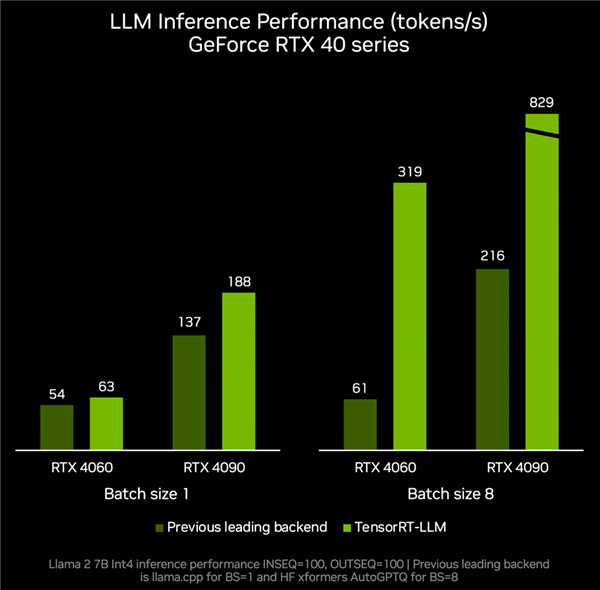

本月底還會有TensorRT-LLM v0.6.0版本更新,將會在RTX GPU上帶來最多達5倍的推理性能提升,並支持更多熱門的 LLM,包括全新的70億參數Mistral、80億參數Nemotron-3,讓臺式機和筆記本也能隨時、快速、準確地本地運行LLM。

根據實測數據,RTX 4060顯卡搭配TenroRT-LLM,推理性能可以跑到每秒319 tokens,相比其他後端的每秒61 tokens提速足足4.2倍。

RTX 4090則可以從每秒tokens加速到每秒829 tokens,提升幅度達2.8倍。

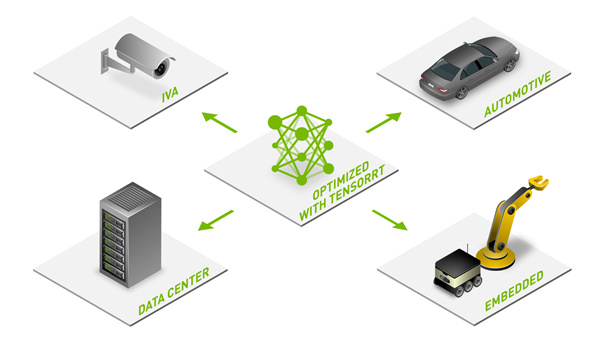

基於強大的硬件性能、豐富的開發生態、廣闊的應用場景,NVIDIA RTX正成爲本地端側AI不可或缺的得力助手,而越來越豐富的優化、模型和資源,也在加速AI功能、應用在上億臺RTX PC上的普及。

目前已經有400多個合作伙伴發佈了支持RTX GPU加速的AI應用、遊戲,而隨着模型易用性的不斷提高,相信會有越來越多的AIGC功能出現在Windows PC平臺上。

來源:快科技

更多遊戲資訊請關註:電玩幫遊戲資訊專區

電玩幫圖文攻略 www.vgover.com