说真的,我第一眼看到这篇论文的时候,

我真的以为是谁在恶搞开玩笑,要么就是出来骗的。

还以为是哪个炼丹佬重云之后产生的幻觉。

之前但凡折腾过AI视频生成的人都懂:开始生成任务后,去搞点别的是基本操作。

回来能看到几秒视频算你运气好,运气差点,可能只等来一个显存溢出/流程错误的报错,改完了又得重新生成重新等。

可在那份刚出炉的技术报告里,清华大学、生数科技和加州大学伯克利分校的一群研究员,几乎是用不讲道理的方式,把视频生成的速度给硬生生提了一大截。

他们为这个框架起的名字页丝毫没有辜负其性能:TurboDiffusion (涡轮增压式扩散模型)。

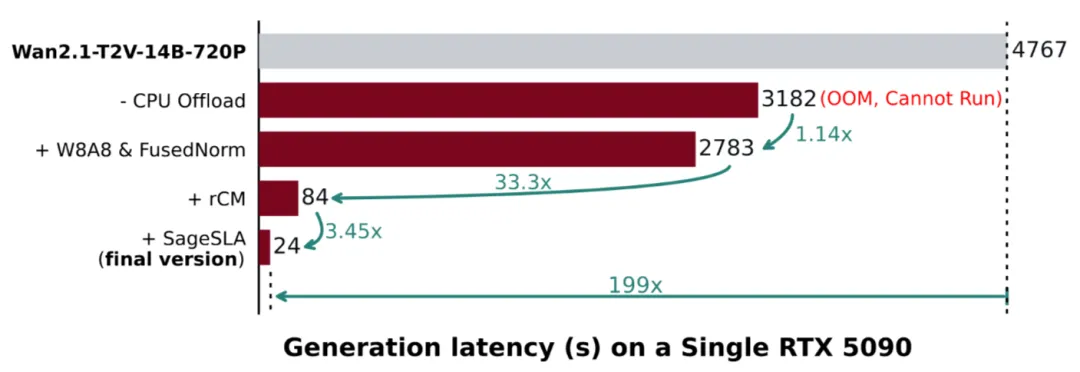

实验平台是一张 RTX 5090(甚至都不是 RTX 6000Pro)。

在 Wan2.1 (阿里通义万相 2.1视频生成模型)上生成一段 5 秒视频,原本需要 184 秒——刷几条短视频绰绰有余。但在 TurboDiffusion 加持下,耗时直接被压到 1.9 秒。

不是快一倍、十倍,而是一百倍以上!什么概念?很多生图模型都没它快!甚至你网速慢一点甚至没它生成出来的快!

这意味着视频生成,正在向工业流水线转变。以前要做一个AI视频,可能需要大半天,但是现在,也许10分钟就能搞定。

那么,他们到底往模型到底怎么实现的?

逻辑其实不复杂,主要动了三刀。

第一刀,砍在注意力机制上。

视频模型慢,很大一部分原因就是注意力太吃算力。

他们引入了低比特的 SageAttention,相当于给计算过程换了一套更省力的做法,在几乎不损失画质的前提下实现插件级提速。同时配合 SLA(稀疏线性注意力),让模型在超长序列下也能轻装上阵。

第二刀,是把扩散步数浓缩了。

传统扩散模型,本质就是反复去噪,动辄几十上百步。TurboDiffusion 用的是 rCM 步数蒸馏,原本要走一百步的路,被硬生生压缩成三五步。

第三刀,直接对参数动手。

他们采用 W8A8 量化,把模型参数压到 8 位,不仅算得更快,显存压力也直接松了一大口。

同时,这一整套方案已经全家桶式开源了。模型权重、训练代码、推理脚本,全都摆在 GitHub 上。大家可以去共同完善,有了社区支持,会让框架变得更完美。

这对普通开发者和个人创作者来说,几乎是天上掉馅饼,纯福利。

以前想玩视频生成,得租服务器、烧算力,财力不雄厚,根本玩不转;现在一张顶级民用显卡,就能体验接近实时的创作反馈。

这种技术红利的释放,科技平权这词的含金量在此时被无限放大。

使用通义万相2.2生成

不过呢,

大家冷静下来想一个问题:当视频生成真的进入“秒级时代”,那些靠卖算力、卖等待时间盈利的公司,那不就完蛋了嘛?

以前一段 AI 视频能火,是因为大家默认它背后烧了大量算力和耐心;可当两秒钟就能出一个,创作门坎被无限降低。

对创作者来说,终于熬到春天了,效率不再束缚灵感;但我也担心,这会带来一场更严重的视觉垃圾泛滥。

当门槛低到几乎不存在时,真正值钱的,就不是视频本身了。更值钱的东西就是那自动化无法复制的创意原点。

清华这波操作,不只是把视频生成加速,整个行业的成本结构都撬松了。

当算力不再是瓶颈、速度快到可以忽略,人还能拿什么作为自己的核心竞争力?

这,或许才是 TurboDiffusion 真正丢给整个行业的问题。

(论文与GitHub地址在下方。)

我是 CyberImmortal,关注我们,带你畅游AI世界!

GitHub:

https://github.com/thu-ml/TurboDiffusion

论文:

https://arxiv.org/pdf/2512.16093

更多游戏资讯请关注:电玩帮游戏资讯专区

电玩帮图文攻略 www.vgover.com