這就很DeepSeek。

沒有發佈會,沒有預熱視頻,連張像樣的倒計時海報都沒有。就在大家還在回味前段時間各家大模型亂鬥帶來的震撼時,DeepSeek在昨天——也就是12月1日,搞了一波“偷襲”。

這次他們也不跟你廢話,直接甩出來了兩個新模型:DeepSeek-V3.2 和 DeepSeek-V3.2-Speciale。

說實話,這幫人確實有點“不講武德”。

你看隔壁Sam Altman,發個GPT-5.1恨不得把地球都搖勻了再通知你,DeepSeek倒好,每次都是等各家都把大模型發差不多了,然後越共探頭,直接把模型往那一扔,技術報告一丟。

然後說:東西在這,愛用不用,我要去訓練下一個了。

先說說這個 DeepSeek-V3.2。

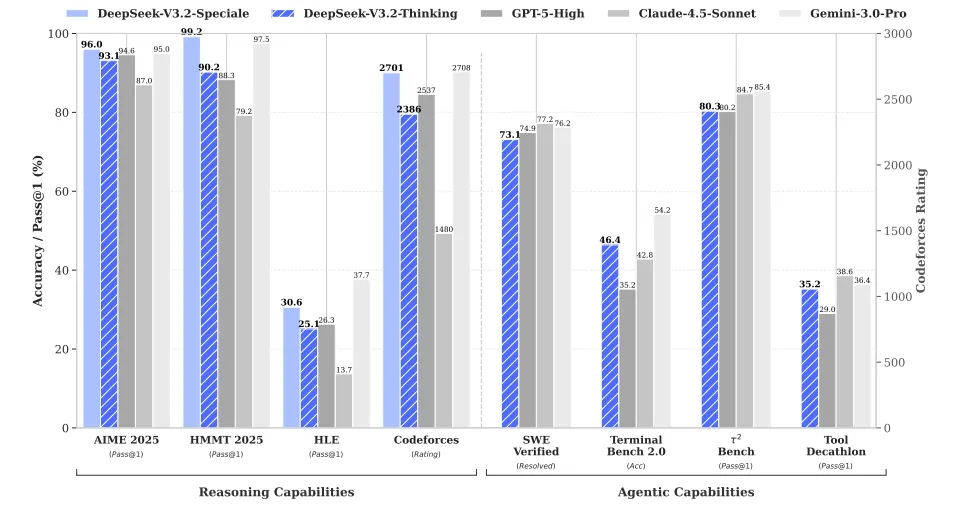

官方的說法是,這個版本平衡了推理能力和輸出長度,適合咱日常拿來當聊天搭子或者乾點正經活。我看了一下技術報告裏的數據,這傢伙在推理能力上已經摸到了GPT-5(就是8月份出的那個)的屁股,僅僅略微輸給谷歌那個剛出的 Gemini-3.0-Pro。

最關鍵的是,它解決了一個痛點。

之前的思考模型(比如R1或者K2-Thinking)都有個毛病,就是囉嗦。爲了想通一個問題,它們能在後臺把上下五千年的邏輯都盤一遍,等你看到答案時黃花菜都涼了。V3.2 這次學聰明瞭,它大幅降低了輸出長度,也就是“想得快了”,但腦子沒變笨。

但真正讓我覺得後背發涼的,是那個帶後綴的傢伙——DeepSeek-V3.2-Speciale。

這個詞在意大利語裏是“特別”的意思,但我看應該翻譯成“變態”。

這個模型完全不考慮什麼成本和速度,就是奔着極致推理去的。

它是個典型的“偏科生”,專門搞數學和編程。有多偏科?它在今年的國際數學奧林匹克(IMO)和國際信息學奧林匹克(IOI)裏都拿了金牌。

這還不算完,在 ICPC World Finals(國際大學生程序設計競賽全球總決賽)裏,它的水平相當於人類選手的第二名。

這意味着如果你把這貨塞進一個編程比賽的現場,它能把絕大多數頂尖的人類選手按在地上摩擦。這已經不是“好用”的範疇了,這屬於“降維打擊”。

不過這玩意兒目前只給研究用,因爲它思考起來消耗的算力簡直是吞金獸,普通人拿來問“今天中午喫什麼”不僅浪費,而且可能會破產。

除了秀肌肉,DeepSeek這次在技術上也整了點新活。

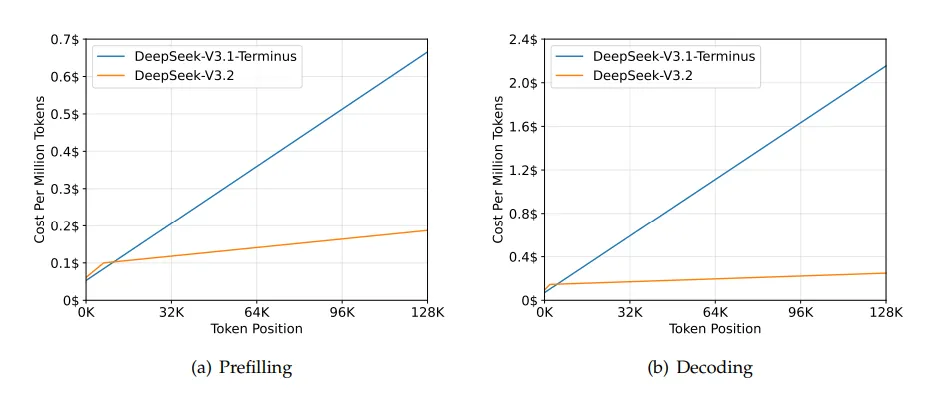

他們在報告裏提到了一個叫 DSA(DeepSeek Sparse Attention)的技術。咱們都知道,大模型處理長文本特別費勁,因爲字數越多,計算量是呈指數級爆炸的。DSA 簡單來說就是給模型配了個“閃電索引”,它不用每次都把幾萬字全文背誦一遍,而是隻挑相關的重點看。

這樣一來,處理128K這種超長上下文的時候,計算量直接暴跌。報告裏有個數據挺嚇人,在長文本任務下,它的推理成本比上一代降低了好幾倍。

這也解釋了爲什麼他們敢在GPT-5.1漲價的背景下,把API的價格還能壓得這麼低,合着是家裏真有省錢的祕方。

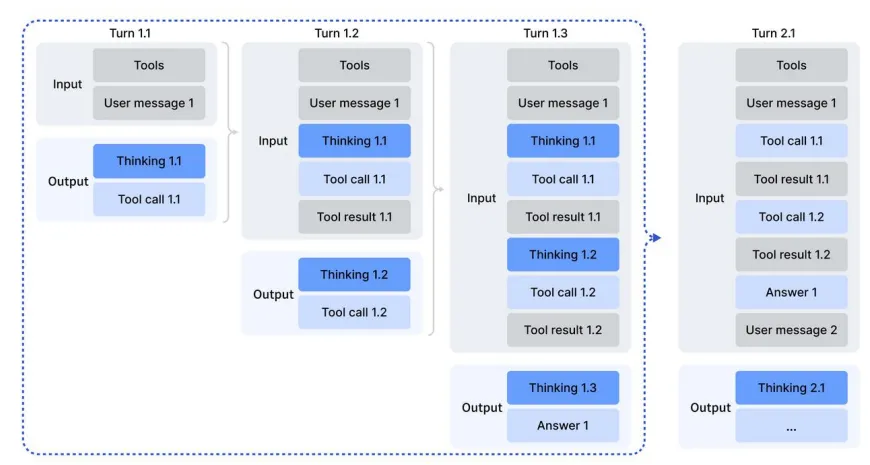

不過,這次更新裏最讓我感興趣的,其實是“思考融入工具”這件事。

之前的推理模型有個很尷尬的短板:腦子很好使,但手腳不協調。它能給你推導出一套完美的數學公式,但你要讓它順手調個計算器算個結果,或者寫段代碼跑一下,它往往就歇菜了。

這就好比一個物理學家,理論無敵,但連個螺絲刀都不會擰。

DeepSeek V3.2 這次打通了“思考”和“動手”的任督二脈。它可以在思考的過程中,發現自己算不過來,然後暫停思考,去調用外部工具(比如Python解釋器或者搜索),拿到結果後接着思考。

這聽起來好像沒什麼,但其實是質的飛躍。

以前的模型是“想完了再幹”或者“幹完了再想”,現在是“邊幹邊想”。爲了練成這招,DeepSeek搞了1800多個模擬環境和85000條複雜指令來特訓它。

讀完這份技術報告,我發現了一個很容易被忽略但極具深意的數據。

DeepSeek 提到,他們在後訓練階段(Post-Training)投入的算力,已經超過了預訓練成本的10%。

這可不是個小數目。以前大家做模型,大頭都在預訓練,就是讓模型海量閱讀互聯網數據。後訓練通常只是微調一下,教它怎麼說話好聽點。但現在,DeepSeek把大量的資源砸在了讓模型“學會思考”和“強化學習”上。

這說明大模型的遊戲規則變了。光靠堆數據、堆顯卡去“背書”已經不夠了,現在的競爭核心,是誰能讓模型在已有的知識上,通過反覆的自我博弈和強化學習,把智商提上去。

當然,DeepSeek 也不是沒缺點。報告裏很誠實地承認,因爲訓練數據總量還是比不過那些閉源巨頭(畢竟GPT-5.1背後的資源太恐怖了),V3.2 在“世界知識的廣度”上還是差點意思。

說白了就是,做題它行,但聊些冷門的八卦或者百科知識,它可能不如 GPT-5.1 或者 Gemini 3.0 見多識廣。

而且,Speciale 版本雖然強,但它是靠瘋狂消耗 Token 換來的。爲了達到 Gemini 3.0 Pro 的質量,它可能要多絮叨很久。這就是目前開源模型面臨的現實:用效率換智商。

但不管怎麼說,DeepSeek 這一波操作,確實給開源社區打了一針強心劑。

8月份GPT-5出來的時候,大家都覺得開源模型已經被甩得連尾燈都看不見了;11月GPT-5.1出來的時候,大家都覺得比賽結束了。結果這才過了半個月,V3.2 居然能跟 GPT-5 這種級別的模型掰掰手腕。

對於我們普通用戶來說,這絕對是好事。畢竟,誰不喜歡一個更聰明、更便宜、還能幫你寫奧數題的AI呢?

OpenAI,你們的 GPT-6 最好已經在路上了,不然這桌子可能真要被這羣“卷王”給掀翻了。

更多遊戲資訊請關註:電玩幫遊戲資訊專區

電玩幫圖文攻略 www.vgover.com