各位好,我们是果核剥壳旗下的AI方向新账号 —— 飞碟AI,初来乍到小黑盒(来摸鱼,真的),还请各位多多关注我们,感激不尽!!

DeepSeek 又双叒叕发新模型了。

这次,不是语言模型,也不是图像模型(就没有),而是——DeepSeek-OCR模型。

但是但是,别被名字骗了。它不是“识字”的那个 OCR,而是反过来——让 AI 更好地看懂图片里的字,还顺带学会了“把文字压成图”。

是的,这次它在“文字视觉化”上开始发力了。

First,what's is DeepSeek-OCR?

单从名字上看,你可能以为这又是个类似 UniOCR 那样的工具,拿来做识别发票、车牌、手写字之类的工作。

但事实上,DeepSeek-OCR 其实是一个「文字—图像联合理解模型」。

它的核心思路非常有意思,我个人称之为邪修——

把原本只能靠语言理解的东西,转成视觉信号,再交给模型去处理。

大家都知道,LLM 一遇到长文本就头大——算力消耗是平方级涨的,文本越长越“烧卡”。于是乎,DeepSeek 的工程师干脆脑洞大开:既然图像能塞下更多信息,那要不把文字“画成图”?

这套操作他们称为「光学压缩」,简单说,就是让 AI 用“看”的方式理解文本,而不是“读”。

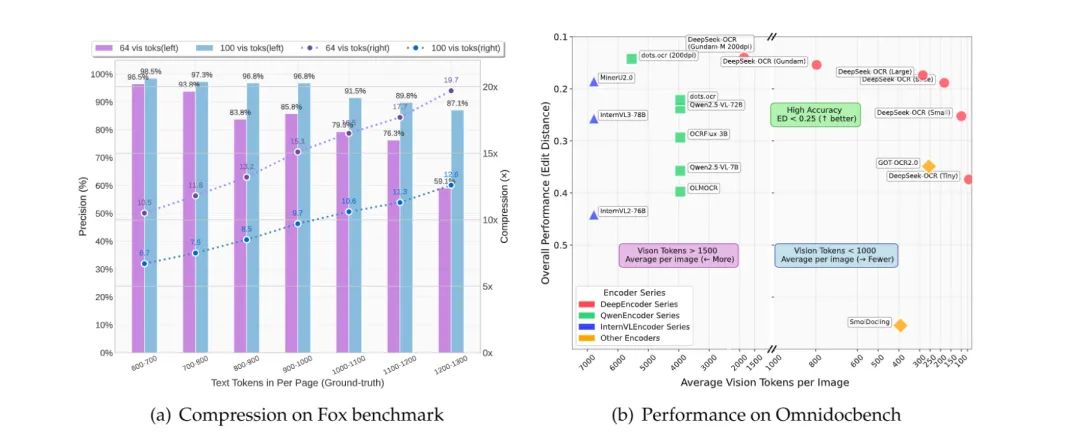

根据其论文给出的数据:压缩 10 倍还能保持 97% 的准确率。

也就是说,一篇要 1000 个 token 才能读完的长文,现在 100 个视觉 token 就够了。

甚至在 20 倍压缩下,准确率还有 60% 左右,AI 的“视觉带宽”确实被狠狠拉开了。

简单讲,它让“AI 看字”这件事,从“读”变成了“看”。

我们继续讲。

文字→图像,为什么反而更高效?

听起来有点反直觉:文字不是比图更容易处理吗?

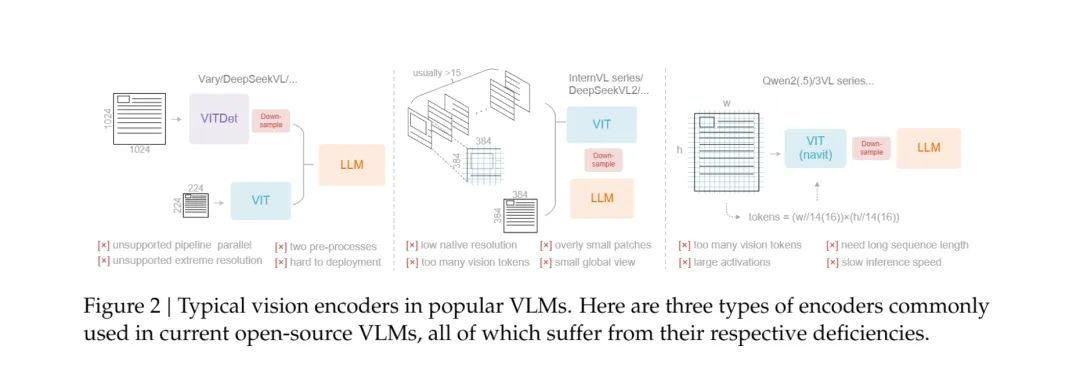

其实,DeepSeek 这里利用的是一种叫「视觉压缩」的思路。它用一种轻量的编码器(DeepEncoder)把文字嵌进视觉特征空间中,这样模型在处理时,不需要再一个字一个字去理解,而是直接在一张“信息图”上完成语义捕捉。

Tips:这个真是邪修了,但我个人感觉只适合中文等信息密度高的文字(其实就只有中文)才适合这种处理方式,有的语言(特别是英语)文字一大段,实际能传达的信息其实没多少,那么这个方式就没有那么划算了。

这意味着在相同算力下,它能处理更长的上下文,甚至能一次“看完”一本 PDF、几张截图,或者一整个网页。

如果类比一下,大多数语言模型像是看小说时用手指一行一行地滑;DeepSeek-OCR 则是直接拿无人机俯瞰整页。

在官方展示的数据里,DeepSeek-OCR 在中英文混排、公式识别、票据结构化任务上,都比主流模型(包括 Gemini-Vision 和 GPT 等)快两倍以上,精度还更稳。

甚至在某些场景下(比如含有代码截图、表格或复杂标点的内容),DeepSeek-OCR 能“看出上下文逻辑”——比如识别 Python 代码块、理解函数缩进层级,这已经不是单纯的 OCR,而是接近“视觉理解 + 语义补全”。

换句话说,它不止在“看”,它还能看懂你截图里想说什么。

如果你把这当作一个独立的 OCR 模型,那它确实是“强但没太大用”的那种——毕竟普通人用不上这种高维识别,且严格意义上讲,这个模型也不是为了OCR类工具服务的。

但如果你把它看作 DeepSeek 在多模态方向上的布局,这就有意思了。

这套技术的真正意义,是让模型在语言、图像之间自由切换信息表达方式。未来当它接入主力模型(比如 DeepSeek-V3 系列)搞多模态时,DeepSeek 的 AI 可能会出现一种新能力:

“看文档像看图一样快,写图表像写字一样准。”

就像我们的大脑也有视觉记忆区、语言区一样,DeepSeek 正在教模型学会“换个

最后,DeepSeek-OCR 看起来像个“小菜”级别的更新,若不是你看不本文,3B的参数量、名字里带OCR,你怎么也想不到这是 DeepSeek 工程师的一大“邪修”成果。

AI 的瓶颈,已经不在“算力”或“理解力”,而在信息流怎么输入。

就像我们的大脑也有视觉记忆区、语言区一样,DeepSeek 正在教模型学会“换个通道获取信息和思考”。

所以,问题来了——AI 的下一步,是更聪明地记住,

还是更优雅地忘掉?

都看到这里了,灌注我灌注我灌注我!!!!

更多游戏资讯请关注:电玩帮游戏资讯专区

电玩帮图文攻略 www.vgover.com