美團最近開源了個視頻生成模型,名字叫——LongCat-Video。

其實之前我們已經認識“LongCat”了,但對於沒接觸過的朋友,第一次看到這個名字,可能以爲是個貓貓短劇模型,結果點開一看,發現是個13.6B參數的長視頻生成大模型。

不過呢,這隻“長貓”可不是美團單純整來拿來賣萌的(雖然名字在這一衆模型中算可愛的),而是和Sora、Veo、Seedance一類的視頻生成模型。

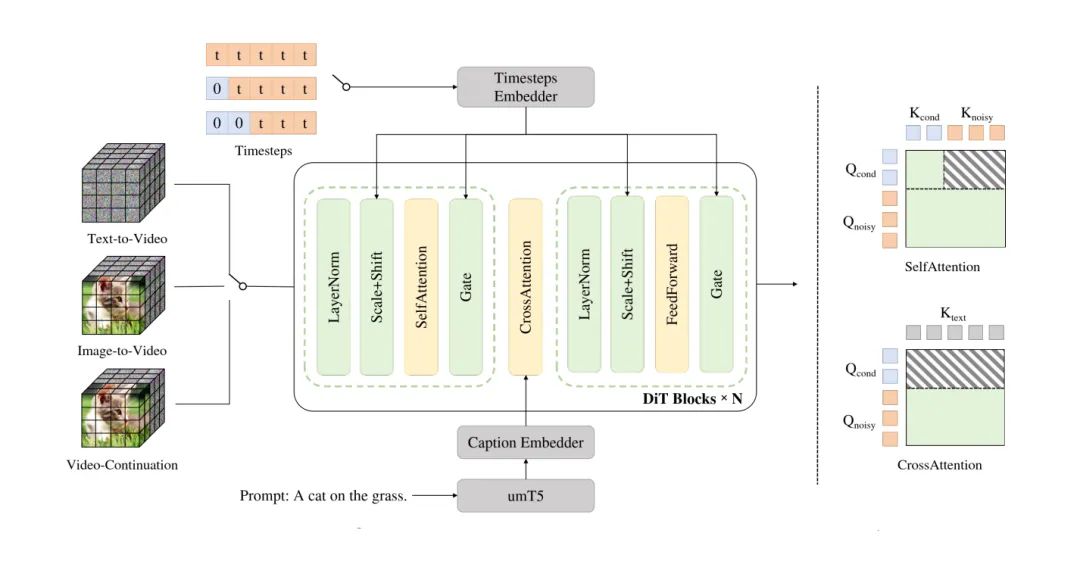

LongCat-Video最大的亮點在於“三合一”:

同一個模型,既能文生視頻(Text-to-Video),又能圖生視頻(Image-to-Video),還能視頻續寫(Video Continuation)。

簡單說,就是一個模型可以從一句話拍出短片,也可以從一張圖接着拍,還能把沒拍完的視頻接下去。

這在目前的開源模型裏算是一體化程度非常高的設計。

技術上,它是基於Diffusion Transformer架構,輸入上用“條件幀數量”區分任務:

0幀是文生視頻,1幀是圖生,多幀是續寫。

這個設計聽起來樸素,但實用得要命——因爲不用換模型。

美團直接做成了個通用視頻生成引擎,像是給自己未來的“世界模型”打地基。

LongCat-Video另一個關鍵點,是“能拍長片”。

團隊在預訓練階段就讓模型做“視頻續寫”,也就是教它從前幾幀猜後幾幀,反覆練到會拍分鐘級長視頻。

報告裏寫,它能穩定生成5分鐘級的連貫視頻,不漂色、不崩壞、不鬼畜。

對比現在市面上很多模型拍個30秒就開始抽風,這已經是“穩健型導演”了。

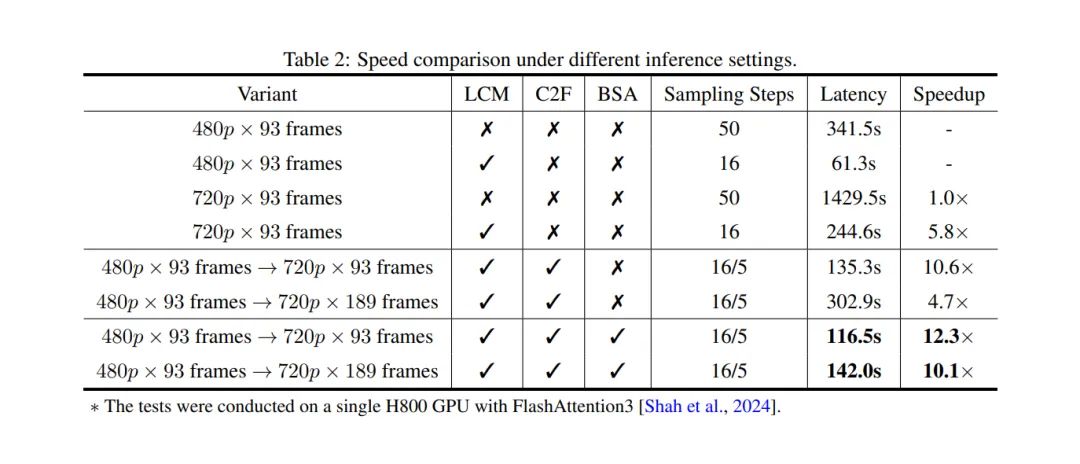

效率上,美團也下了功夫。

模型結合了塊稀疏注意力(Block Sparse Attention)和條件緩存機制,處理90多幀視頻時依然能保持流暢。

更狠的是,它支持“粗到細”生成——先拍個480p 15fps低清樣片,再升成720p 30fps高清版。

結果是:推理速度比基線快了10倍。

要知道,這個速度,已經可以讓生成視頻從“炫技”變成“能用”。

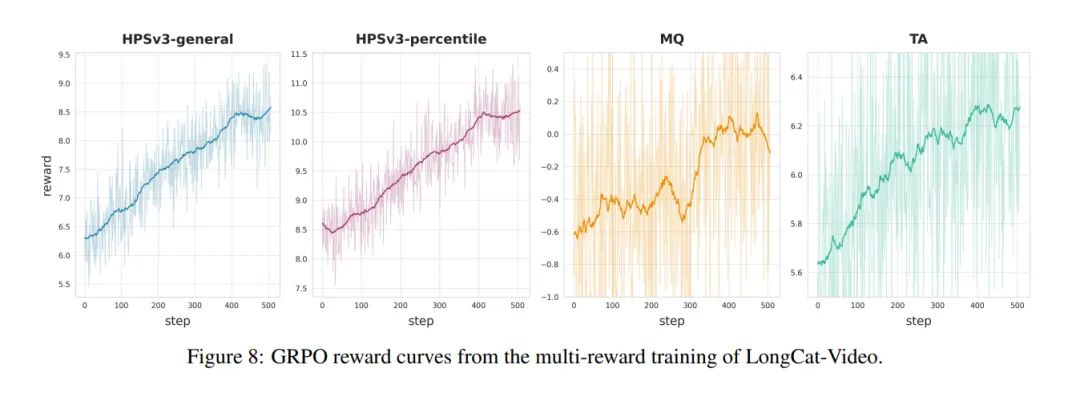

然後是訓練部分,美團的報告寫得相當“工業級”:

用多階段漸進式訓練,從低分辨率圖像到高清視頻,分階段訓練不同任務;

再用SFT精調,選高質量視頻篩數據;

最後還來了一套RLHF強化學習——用三個獎勵模型分別優化“畫質”“動作”“文本對齊”。

有點像電影學院三位導師分別管攝影、表演、劇本。

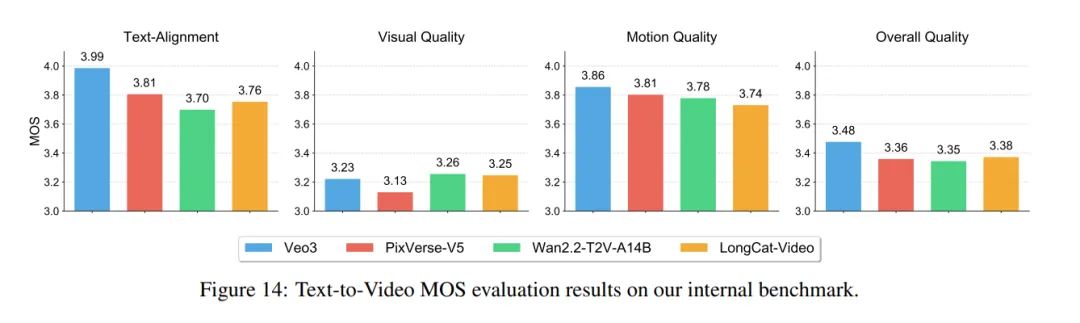

從結果看,美團這次是真的有備而來。

在內部測試中,LongCat-Video的文生視頻表現略優於PixVerse-V5、Wan2.2-T2V,但不如谷歌的Veo3;

圖生視頻則還沒打過Hailuo-02和Seedance 1.0。

不過它是MIT協議開源的,這點就很不一樣——能商用,也就是說,美團是來爲大家鋪路而不是刷論文充面子的。

那麼問題來了:美團要視頻生成模型幹嘛?

Sora要拍電影,Kling做短劇,Wan綜合選手,美團呢?

其實在他們的GitHub演示裏就已經可以看到:一堆商業宣傳風的視頻。

各種618大促、產品特寫展示視頻等,都是非常優質的材料,稍加修改直接拿來商用是完全沒問題的(當然,生成別的視頻也沒問題)。

你再想想美團本身的業務——團購、外賣、本地生活。

如果他們用LongCat做本地商戶視頻生成,那量會有多大?

“AI自動拍商家宣傳片”這件事,一下就變得合理了。

這或許是國內第一個明確走“綜合型商業視頻生成”路線的大廠模型。

不是拍藝術短片,也不是追求Sora那種物理擬真,而是直接奔着“能上架、能用、能賣”的方向去。

不妨我們大膽推想,他們後續可能會把它嵌進商家後臺,讓老闆輸入一句話就能生成宣傳視頻。

——從這個角度看,LongCat的“長”,可能不只是視頻長,而是產業鏈長。

AI視頻的戰場已經不只是模型能力的比拼,而是“誰能最快落地賺錢”。

Sora拍短片,Veo拍大片,Seedance拍MV,而美團可能要讓AI拍廣告。

這場戰爭,真有點意思。

更多遊戲資訊請關註:電玩幫遊戲資訊專區

電玩幫圖文攻略 www.vgover.com