美团最近开源了个视频生成模型,名字叫——LongCat-Video。

其实之前我们已经认识“LongCat”了,但对于没接触过的朋友,第一次看到这个名字,可能以为是个猫猫短剧模型,结果点开一看,发现是个13.6B参数的长视频生成大模型。

不过呢,这只“长猫”可不是美团单纯整来拿来卖萌的(虽然名字在这一众模型中算可爱的),而是和Sora、Veo、Seedance一类的视频生成模型。

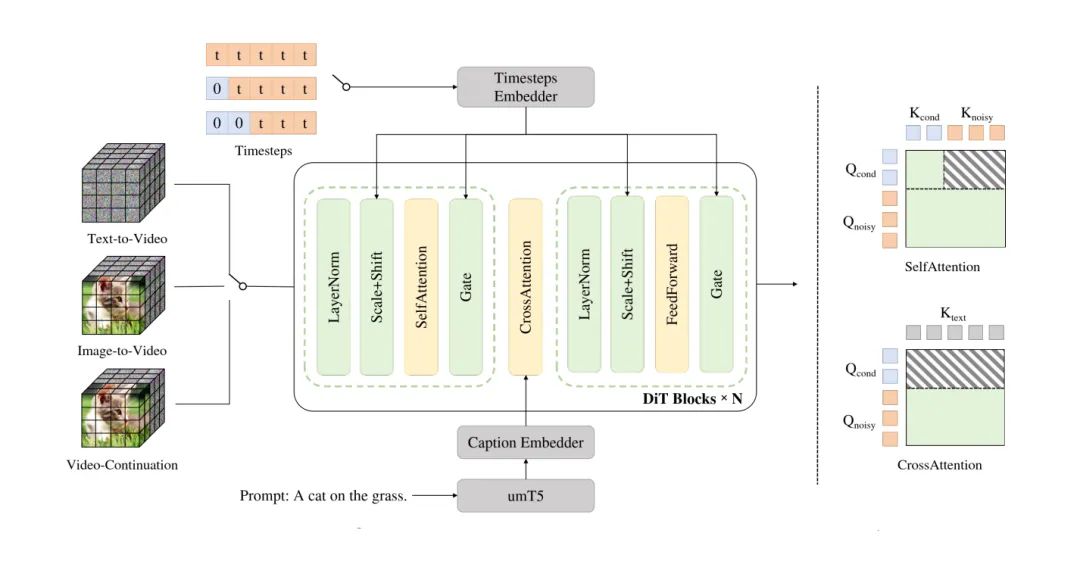

LongCat-Video最大的亮点在于“三合一”:

同一个模型,既能文生视频(Text-to-Video),又能图生视频(Image-to-Video),还能视频续写(Video Continuation)。

简单说,就是一个模型可以从一句话拍出短片,也可以从一张图接着拍,还能把没拍完的视频接下去。

这在目前的开源模型里算是一体化程度非常高的设计。

技术上,它是基于Diffusion Transformer架构,输入上用“条件帧数量”区分任务:

0帧是文生视频,1帧是图生,多帧是续写。

这个设计听起来朴素,但实用得要命——因为不用换模型。

美团直接做成了个通用视频生成引擎,像是给自己未来的“世界模型”打地基。

LongCat-Video另一个关键点,是“能拍长片”。

团队在预训练阶段就让模型做“视频续写”,也就是教它从前几帧猜后几帧,反复练到会拍分钟级长视频。

报告里写,它能稳定生成5分钟级的连贯视频,不漂色、不崩坏、不鬼畜。

对比现在市面上很多模型拍个30秒就开始抽风,这已经是“稳健型导演”了。

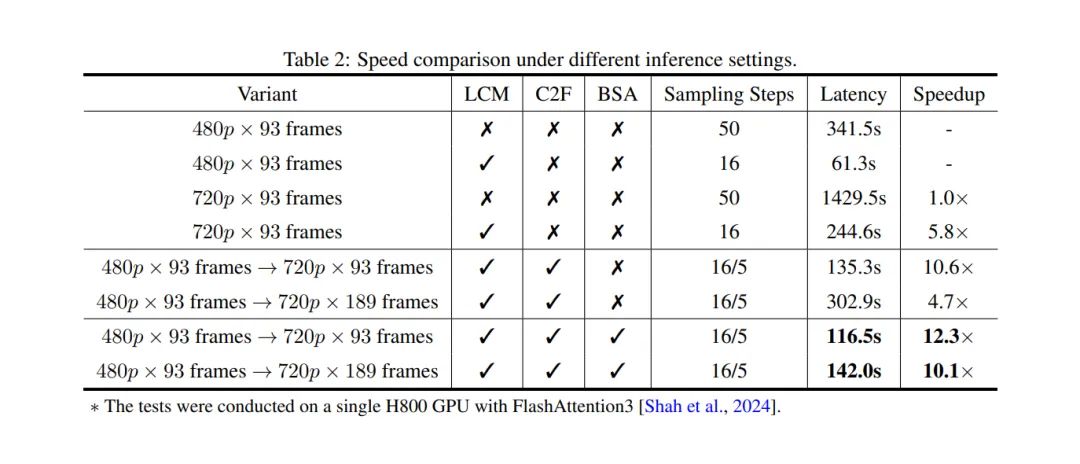

效率上,美团也下了功夫。

模型结合了块稀疏注意力(Block Sparse Attention)和条件缓存机制,处理90多帧视频时依然能保持流畅。

更狠的是,它支持“粗到细”生成——先拍个480p 15fps低清样片,再升成720p 30fps高清版。

结果是:推理速度比基线快了10倍。

要知道,这个速度,已经可以让生成视频从“炫技”变成“能用”。

然后是训练部分,美团的报告写得相当“工业级”:

用多阶段渐进式训练,从低分辨率图像到高清视频,分阶段训练不同任务;

再用SFT精调,选高质量视频筛数据;

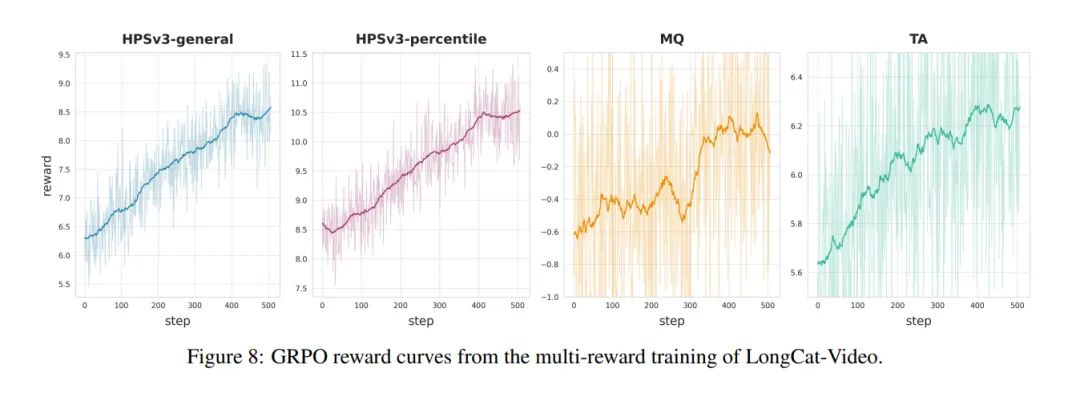

最后还来了一套RLHF强化学习——用三个奖励模型分别优化“画质”“动作”“文本对齐”。

有点像电影学院三位导师分别管摄影、表演、剧本。

从结果看,美团这次是真的有备而来。

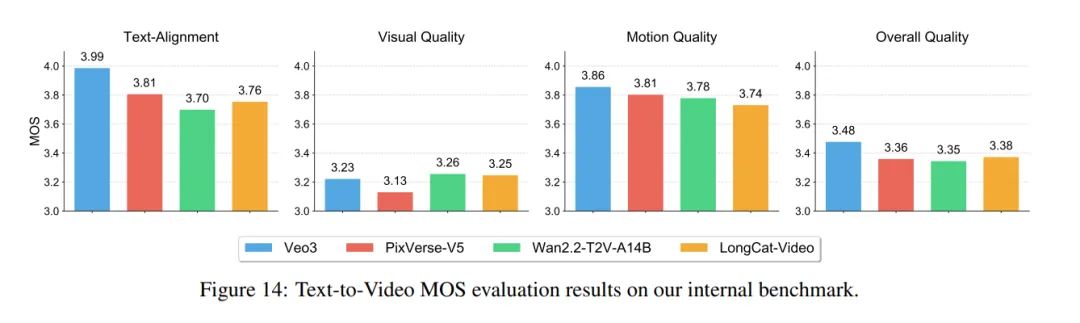

在内部测试中,LongCat-Video的文生视频表现略优于PixVerse-V5、Wan2.2-T2V,但不如谷歌的Veo3;

图生视频则还没打过Hailuo-02和Seedance 1.0。

不过它是MIT协议开源的,这点就很不一样——能商用,也就是说,美团是来为大家铺路而不是刷论文充面子的。

那么问题来了:美团要视频生成模型干嘛?

Sora要拍电影,Kling做短剧,Wan综合选手,美团呢?

其实在他们的GitHub演示里就已经可以看到:一堆商业宣传风的视频。

各种618大促、产品特写展示视频等,都是非常优质的材料,稍加修改直接拿来商用是完全没问题的(当然,生成别的视频也没问题)。

你再想想美团本身的业务——团购、外卖、本地生活。

如果他们用LongCat做本地商户视频生成,那量会有多大?

“AI自动拍商家宣传片”这件事,一下就变得合理了。

这或许是国内第一个明确走“综合型商业视频生成”路线的大厂模型。

不是拍艺术短片,也不是追求Sora那种物理拟真,而是直接奔着“能上架、能用、能卖”的方向去。

不妨我们大胆推想,他们后续可能会把它嵌进商家后台,让老板输入一句话就能生成宣传视频。

——从这个角度看,LongCat的“长”,可能不只是视频长,而是产业链长。

AI视频的战场已经不只是模型能力的比拼,而是“谁能最快落地赚钱”。

Sora拍短片,Veo拍大片,Seedance拍MV,而美团可能要让AI拍广告。

这场战争,真有点意思。

更多游戏资讯请关注:电玩帮游戏资讯专区

电玩帮图文攻略 www.vgover.com