半個多月前,谷歌搞了一波突然襲擊,毫無預兆地發佈了新一代AI模型Gemma,並宣稱這是全球性能最強大的輕量級開源系列模型。

根據Google介紹,開源模型Gemma使用了和Gemini同源的技術,總共有20億參數和70億參數兩種規模,每個規模又分預訓練和指令微調兩個版本。

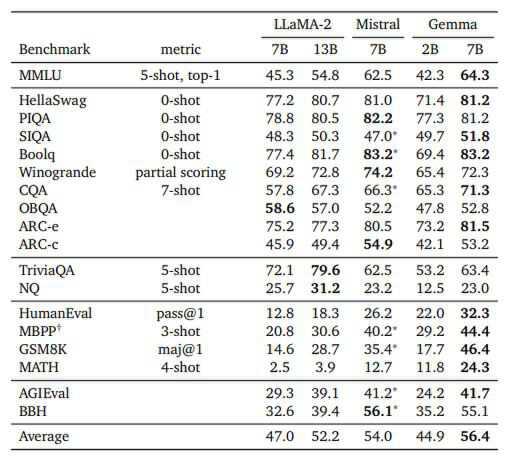

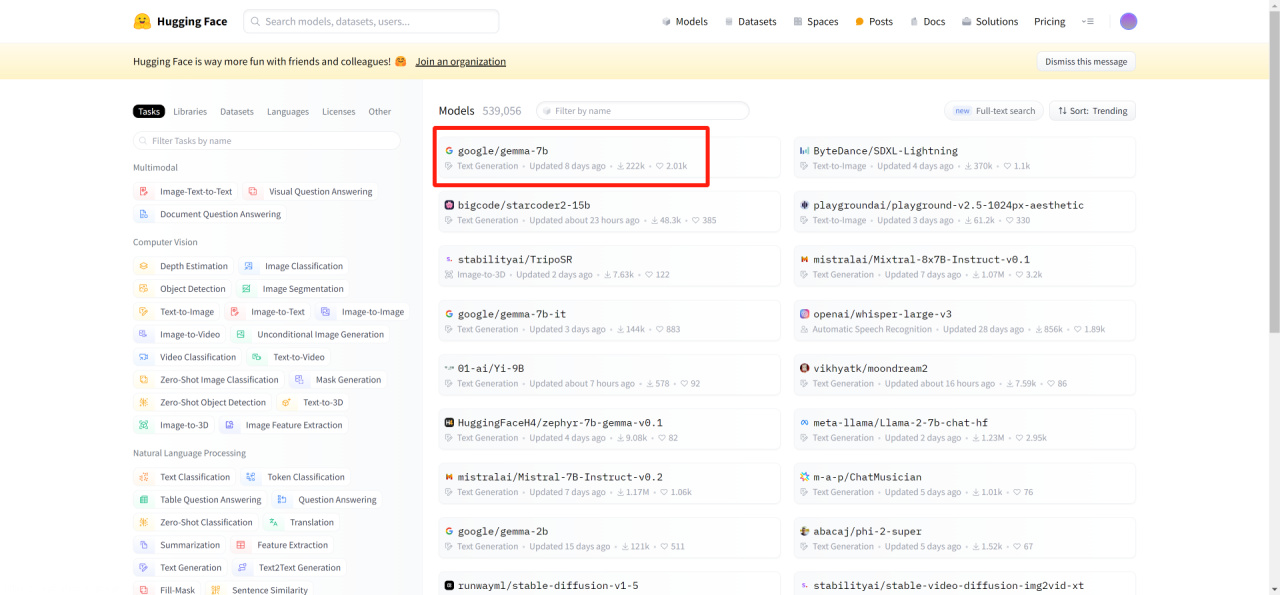

在Gemma官方頁面上,Google給出了Gemma在語言理解、推理、數學等各項標準測試中的得分,其中70億參數模型擊敗了主流開源模型Llama-2和Mistral,直接登頂Hugging Face開源大模型排行榜,成爲目前全球最火熱的開源大模型之一。

與Gemini的全家桶路線不同,Gemma這次主打輕量高性能,擁有2b、2b全量版、7b、7b全量版4種版本。

其中最基礎的2b模型即便是在沒有獨顯的筆記本電腦上都能嘗試運行,而規模更大的7b、7b全量版分別需要8GB和16GB顯存。

經過實測,雖然Gemma的使用體驗不如ChatGPT-4等成熟的閉源大模型,但是本地運行模式還是有其存在的意義的,對於私密性要求較強的用戶,也可以在斷網的情況下本地加載運行,不用擔心相關信息泄露等等。

本次就爲大家分享本地部署Gemma的操作流程,並演示如何使用JAN AI來實現UI界面訪問Gemma。

一、安裝Ollama

Ollama 是一個專爲運行、創建和分享大型語言模型而設計的開源項目,爲開發者和研究者提供了一個平臺,使得他們可以更方便地部署、管理和使用這些大型語言模型。目前Ollama支持支持 macOS、Windows、Linux 和 Docker等多種安裝方式,還能通過 API 方式爲本地 AI 服務提供便捷途徑。

目前Ollama支持的模型如下圖所示:

這裏我們以Windows系統爲例來演示,首先去Ollama的官網或者GitHub頁面下載最新的Windows版本安裝包:

https://ollama.com/

https://github.com/ollama/ollama

下載安裝包後,一路點擊“下一步”安裝即可。

完成安裝後,點擊桌面圖標運行Ollama,此時桌面右下角Windows系統托盤裏有正在運行羊駝圖標:

接下來我們進入CMD命令提示符,輸入“ollama --version",當看到ollama版本號正確顯示時,就已經完成安裝了。

二、拉取並運行Gemma模型

這一步我們直接使用最簡單的方法,使用Ollama來拉取Gemma的模型文件。請注意,由於文件服務器在國外,所以我們需要一些魔法上網的技巧,請自行研究。

以對電腦配置要求最低的Gemma 2b基礎版模型爲例,在命令提示符中,我們輸入ollama run gemma:2b代碼並回車,Ollama會自動從模型庫中拉取模型文件並進行運行。當模型加載後,會顯示success的標識,此時我們就可以輸入漢字與Gemma:2b進行對話了。

如果想要結束對話,我們可以在Gemma的信息輸入框中輸入/bye即可。

到底爲止,Gemma在我們本地已經部署成功了,這裏順帶說些其他的事兒。

1.首先Ollama雖然在GitHub頁面中只列出了Gemma 2b和7b基礎版模型的拉取代碼,但實際上我們還是能通過它來拉取全量版模型的,代碼分別如下:

ollama run gemma:2b-instruct-fp16

ollama run gemma:7b-instruct-fp16

2.想要知道目前Ollama中已經拉取了哪些模型,可以用ollama list來實現:

Ollama的其他命令可以參考下圖:

三、使用JAN AI美化UI界面

通過Ollama在本地部署Gemma後,我們雖然能在命令提示符中與模型對話,但是這種方式未免也太過麻煩了,所以還是需要有一個類似nextChat之類的軟件來美化一下UI界面,同時還可以實現更多功能。

本來Ollama官方推出了open-webui這個開源項目,不過目前該項目尚未推出Windows安裝包,在wsl中使用docker安裝的方式又有點兒麻煩,所以經過實現,這裏還是選擇UI非常好看的JAN AI來與Ollama進行鏈接吧。

首先我們要到JAN的官方網站下載Windows客戶端,並直接安裝:

https://jan.ai/

在JAN的官網上,有非常詳細的操作手冊,我們可以在其中找到關於如何鏈接Ollama的方法。

1.啓動 Ollama 服務器

首先我們要通過命令提示符啓動 Ollama 服務器,並且加載運行我們要跑的Gemma版本,這裏以7b全量版爲例:

根據有關 OpenAI 兼容性的 Ollama 文檔,Ollama在運行時會提供類似OpenAI的API服務,我們可以使用網址:

http://localhost:11434/v1/chat/completions

連接到 Ollama 服務器。

我們需要去JAN的安裝地址,一般是“C:\Users\你的用戶名\jan\engines”中找到penai.json 文件,在其中修改爲Ollama 服務器的完整網址。

示例如下:

{ "full_url": "http://localhost:11434/v1/chat/completions" }2.模型配置

進入jan安裝位置的models 文件夾,創建一個在Ollama中運行的模型同名的文件夾,例如gemma:7b-instruct-fp16。

然後在文件夾內創建一個 model.json 文件,在其中將 id 屬性設置爲 Ollama 模型名稱,將格式屬性設爲 api,將引擎屬性設爲 openai,將狀態屬性設爲 ready。

示例如下:

{ "sources": [ { "filename": "gemma:7b-instruct-fp16", "url": "https://ollama.com/library/gemma:7b-instruct-fp16" } ], "id": "gemma:7b-instruct-fp16", "object": "model", "name": "Ollama - gemma:7b-instruct-fp16", "version": "1.0", "description": "gemma:7b-instruct-fp16 by ollama", "format": "api", "settings": {}, "parameters": {}, "metadata": { "author": "Meta", "tags": ["General", "Big Context Length"] }, "engine": "openai" }3.啓動模型

重新啓動 Jan ,在模型HUB中找到我們剛纔新建的gemma:7b-instruct-fp16,然後點擊“USE”即可。

接下來我們就可以和Gemma進行正常對話了,比如問一問它,寫年終總結報告要注意點啥事兒:

四、顯卡選購小貼士

目前AIGC領域如火如荼,除了如本文所述,在本地部署的AI語言大模型之外,stable diffusion等開源文生圖的應用更是廣泛,爲我們的生活和創造提供了絕佳動力。

由於AIGC應用中,GPU用來推理的效率要比CPU強的太多,所以我們需要一張性能強、顯存大的顯卡來更好的提高本地AIGC應用的運行效率,這是剛需,真的沒法省。

而NVIDIA系列的顯卡因爲早早佈局了CUDA,所以在AI領域無疑擁有近乎無解的統治力,要玩AIGC的話還得選N卡爲主,AMD和Intel紅藍兩家目前還需要追趕。老黃家的RTX30系N卡由於已經停產,並且在算力方面整體不如RTX40系顯卡(畢竟4070Ti就要趕上前期間3090了),所以個人的建議還是買新不買舊,就從RTX40系顯卡中撿顯存大的型號選購得了。

這裏爲了方便大家對比,我整理出了當前RTX40系顯卡型號的參數列表:

可以看到,富哥的首選肯定是24GB滿配顯存的RTX4090了,無論是利用AIGC幹活兒還是遊戲娛樂都是目前消費級顯卡中的第一把好手,就是目前阿美斷供搞得價格飛漲,讓人有點難受。而4090D由於專門閹割了AIGC會用到的CUDA核心和Tensor核心數量,所以雖然市場價更低些,但是反而不如4090值得。

對於大部分玩家而言,退而求其次的選擇則是4080Super、4080、4070TiSuper、4060Ti-16G這幾張16GB顯存的顯卡。畢竟算力高低無非是影響AIGC幹活兒效率而已,但是顯存不夠大,那有些本地大模型是真的跑不起來,連門檻都進不了,確實會耽誤事兒。

其中4060Ti-16G作爲最便宜的16GB顯存N卡,還是值得着重看看的。

最後就是關於顯卡品牌的選擇了,目前華碩、微星、技嘉、七彩虹等一線顯卡商中,技嘉因爲之前大家都知道的宣發事故,導致這一兩年各產品線的價格都相對要更低一些,僅從性價比方面來看其實是真挺香的,預算緊張的話可以一試。

其他的二、三線品牌就不一一列舉了,如果不追求一線大廠的話,那大家可以憑着預算隨意選購即可。

更多遊戲資訊請關註:電玩幫遊戲資訊專區

電玩幫圖文攻略 www.vgover.com