想象一下:你家門口的超市突然宣佈:

“今天所有商品免費領取,每人限一件”。

早上超市還沒開門,門口已經排起了幾公里長的隊伍。

開門那一刻,人羣如潮水般湧入——收銀臺癱瘓、貨架被擠倒、連大門都被擠壞了。

Epic年度喜加一活動時的xhh,就像這家被擠爆的超市。

點贊收藏,我們開始

瞬間流量:數字世界的“萬人空巷”

當Epic公佈喜加一遊戲時,成千上萬的玩家會同時湧向xhh:

查看遊戲信息,獲取領取鏈接,參與社區討論,查看領取教程。

這就像成千上萬人同時擠進一扇小門。

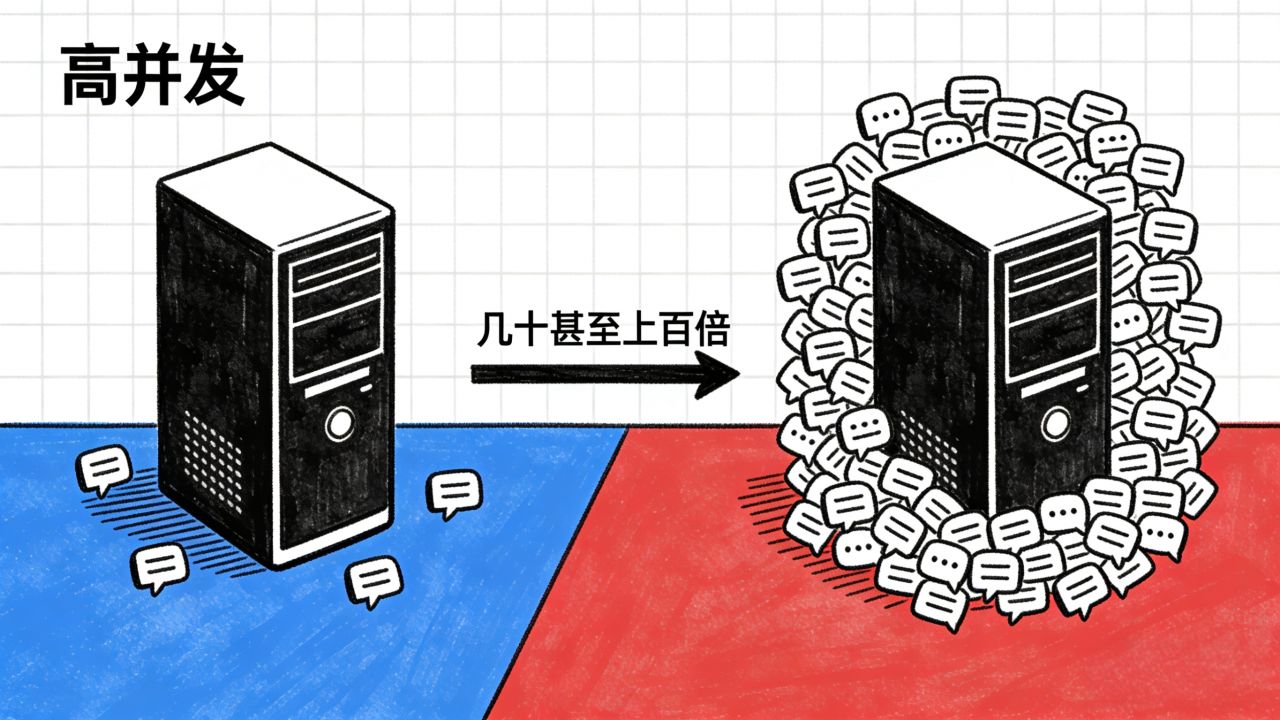

服務器每秒需要處理的請求可能是平時的幾十甚至上百倍。

這也就是我們計算機科學所說的

“高併發”

什麼是“高併發”?數字世界的瞬時洪峯

高併發就像除夕夜的短信拜年:平時每秒幾百條,零點時刻每零點幾秒數十萬條同時湧向運營商系統。

技術層面,它指的是短時間內海量請求同時到達服務器。

xhh在喜加一期間面臨的就是典型的高併發:

請求峯值:平時每秒數千次請求 → 活動時每秒數十萬次

資源爭奪:每個用戶請求都在競爭有限的CPU、內存、數據庫連接

連鎖崩潰:一個環節超載會像多米諾骨牌般引發系統級故障

高併發下的三層崩潰:從入口到核心

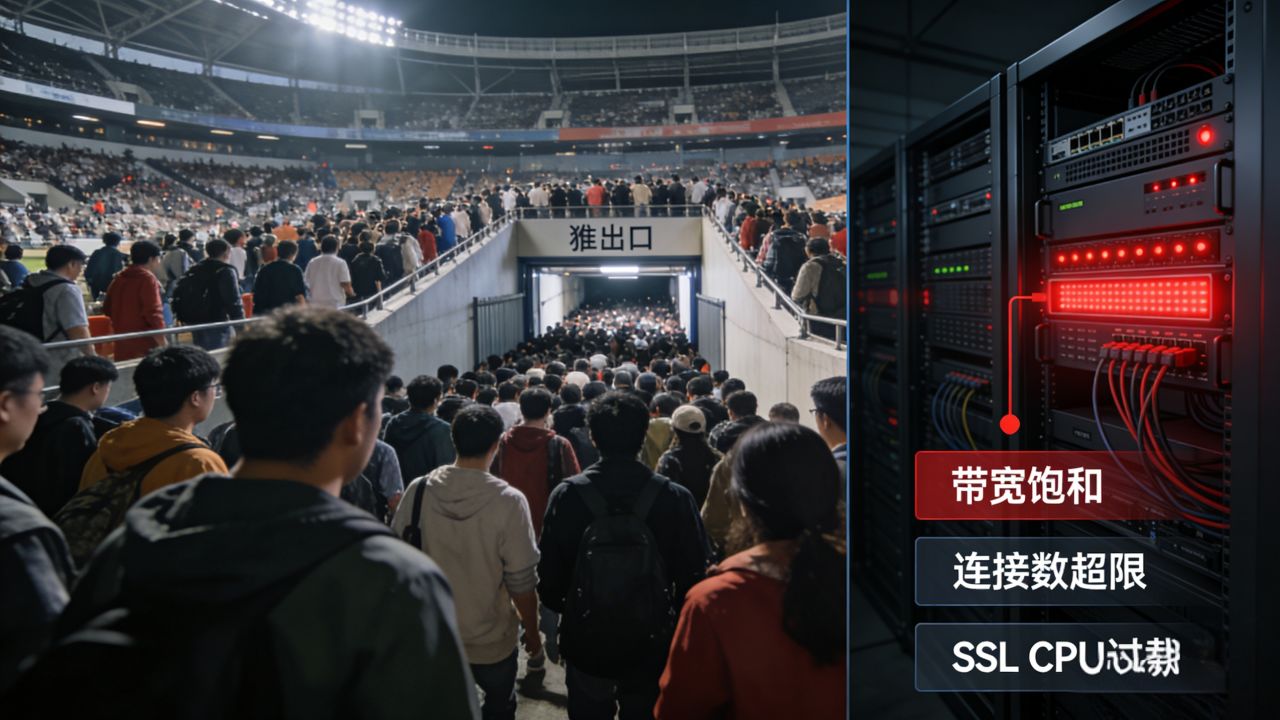

第一層:流量洪峯沖垮“入口閘機”

就像體育場所有觀衆同時湧向唯一出口,網絡入口層的負載均衡器最先遭遇衝擊:

1.網絡帶寬瞬間飽和(管道太細,水流太大)

2.新建連接數超過系統最大限制

3.SSL加密解密消耗大量CPU資源

第二層:應用服務器“線程耗盡”

每個用戶請求都需要一個處理線程,而線程池大小是有限的:

正常情況:1000個線程 → 每秒處理5000個請求

高併發時:1000個線程全部佔用 → 新請求進入等待隊列

極端情況:隊列爆滿 → 服務器開始拒絕請求 → 用戶看到“連接失敗”

第三層:數據庫“連接池枯竭”

這是最常見的瓶頸點:

數據庫同時處理的連接數有限(通常幾百到幾千)而每個查詢都需要時間(即使簡單查詢也需10-50毫秒),所以大量查詢堆積導致響應時間從毫秒級變成秒級,最後的結果就是前端等待超時,用戶看到“加載中”或白屏

爲什麼不能提前準備好?

平臺當然會做預案,但預測流量就像預測天氣:

峯值流量可能遠超預期(今年可能比去年多50%用戶),而且資源調配需要成本(爲短暫高峯購買昂貴服務器不划算)。

如何避免?技術團隊的“平衡術”

面對這種情況,技術團隊通常會用這些方法“亡羊補牢”

1.限流:像點單取號一樣,控制進入系統的用戶數量,排隊系統讓用戶有序等待而非直接拒絕

2.緩存策略:提前準備靜態內容,減少實時計算

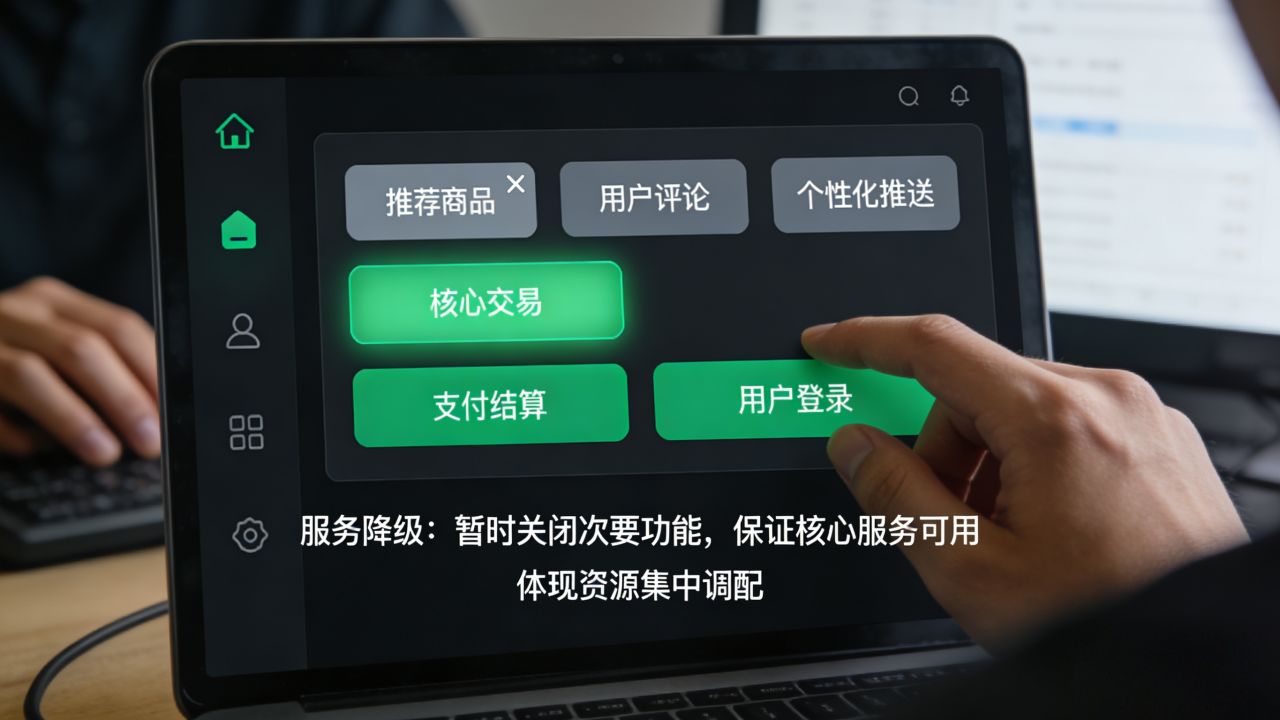

3.服務降級:暫時關閉次要功能,保證核心服務

小知識:爲什麼有些平臺更“抗壓”?

像tb、V這樣的大平臺經歷過多年“雙十一”、“春節紅包”等極限場景,投入了大量資源建設分佈式系統、彈性計算架構。說白了:砸錢。

小結

xhh的崩潰,其實是“幸福的煩惱”——這正是盒友們在社區的熱情和凝聚力。

每次這樣的“壓力測試”都會讓平臺發現薄弱環節,促使技術升級。就像每次大型活動後,城市的交通管理都會得到改善一樣。

下次遇到這種情況,不妨看看還在上面講課的老師,別刷了喂!

求點贊關注!

更多遊戲資訊請關註:電玩幫遊戲資訊專區

電玩幫圖文攻略 www.vgover.com