在2025年3月19日舉辦的NVIDIA GTC 2025大會上,英偉達(NVIDIA)宣佈,其搭載Blackwell GPU的DGX系統成功創造了滿血DeepSeek-R1模型AI推理性能的世界紀錄。這一突破不僅刷新了AI推理速度的天花板,更向全球展示了英偉達在AI硬件與軟件協同優化上的驚人實力。究竟是什麼讓這臺“AI怪獸”如此強悍?讓我們一探究竟!

Blackwell DGX

▶︎單機8卡狂飆:每秒3萬token的吞吐量

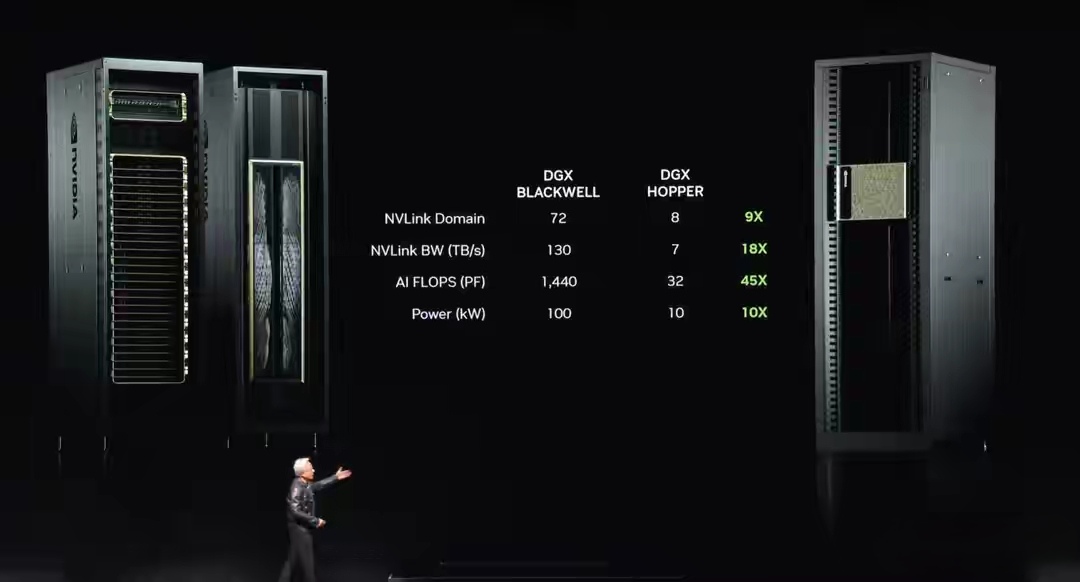

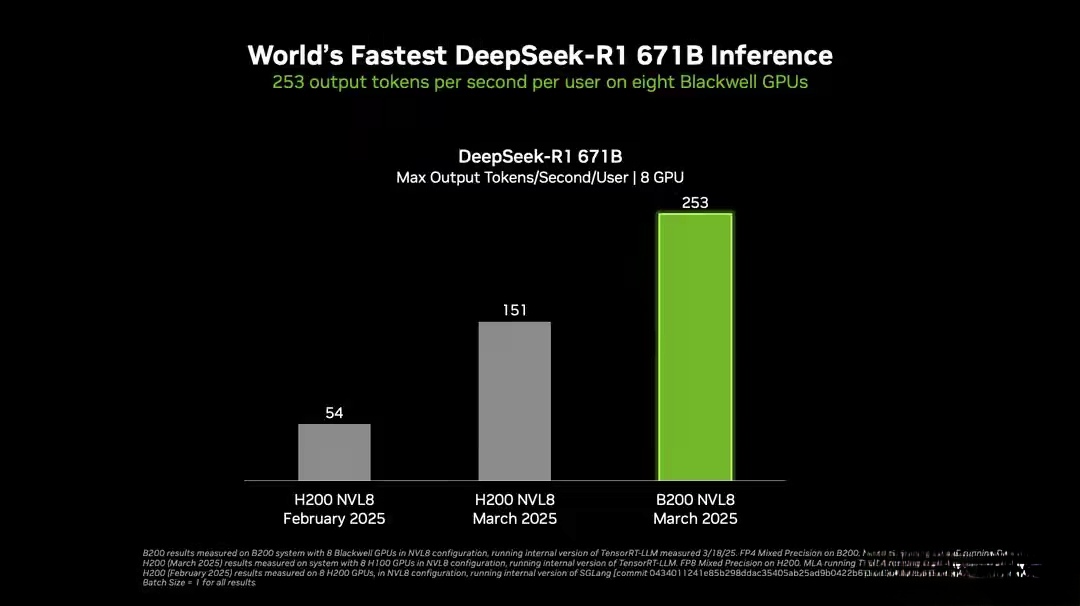

英偉達透露,在一臺配備8塊Blackwell GPU的DGX B200系統上,運行6710億參數的DeepSeek-R1模型時,每位用戶可獲得超過250 token/秒的響應速度,而整機最高吞吐量突破了驚人的3萬 token/秒。這一性能得益於Blackwell架構的第二代Transformer Engine、FP4 Tensor Core以及第五代NVLink高速互聯技術的加持。

8塊Blackwell GPU

相比之下,基於Hopper架構的DGX H200(同樣8卡配置)雖然表現出色,但在相同測試條件下吞吐量明顯遜色。英偉達表示,自2025年1月以來,通過硬件升級和TensorRT-LLM軟件優化,DeepSeek-R1的吞吐量提升了約36倍,成本效率更是躍升32倍。這種飛躍式進步無疑將爲AI開發者帶來更高效的推理體驗。

DeepSeek R1的推理性能飛躍

▶︎測試細節曝光:FP4精度下的極致優化

本次測試採用了TensorRT-LLM內部版本,輸入長度爲1024 token,輸出長度爲2048 token,相比此前1月和2月的測試(輸入/輸出均爲1024 token),任務複雜度顯著增加。計算精度方面,DGX B200使用FP4精度,而DGX H200和H100則採用FP8精度。即便在更低的FP4精度下,Blackwell依然展現了無與倫比的性能優勢。

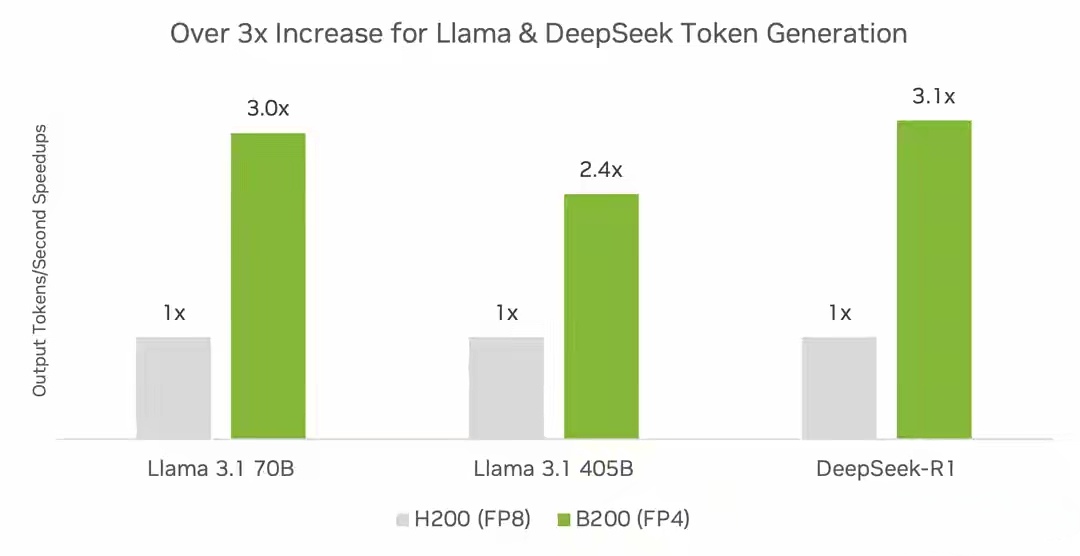

英偉達還對比了多節點配置的表現:單臺DGX B200(8卡)、單臺DGX H200(8卡)以及雙臺DGX H100(共16卡)。結果顯示,Blackwell架構配合TensorRT軟件,在推理吞吐量上比Hopper架構高出數倍。例如,在運行DeepSeek-R1、Llama 3.1 405B和Llama 3.3 70B等大模型時,DGX B200的FP4推理吞吐量是DGX H200的三倍以上。

▶︎精度與性能兼得:FP4僅微損

低精度計算是提升AI推理效率的關鍵,但精度損失往往令人擔憂。英偉達通過TensorRT Model Optimizer的FP4訓練後量化(PTQ)技術,成功將精度損失降至最低。以DeepSeek-R1爲例,FP8基準精度在MMLU、GSM8K等數據集上的表現分別爲90.8%和96.3%,而FP4精度僅略降至90.7%和96.1%,在AIME 2024和MATH-500等數學任務上甚至幾乎無差別(80.0% vs 80.0%、95.4% vs 94.2%)。這意味着開發者可以在不犧牲模型質量的情況下,享受FP4帶來的性能紅利。

▶︎Blackwell的祕密武器

相比Hopper架構,Blackwell爲何如此強悍?答案在於硬件與軟件的雙重突破。Blackwell架構引入了FP4 Tensor Core,支持更高效的低精度計算,同時第五代NVLink和NVLink Switch提供了超高帶寬的數據傳輸能力。配合開源的NVIDIA推理生態(如TensorRT-LLM),開發者可以輕鬆優化從DeepSeek-R1到Llama系列的各種大模型,滿足從極致用戶體驗到最大效率的多樣化需求。

英偉達技術博客指出,隨着Blackwell Ultra GPU的進一步迭代,推理性能還將持續提升。未來,無論是個人開發者還是企業用戶,都能借助這一平臺推動AI應用的邊界。

▶︎結語

英偉達在GTC 2025上用Blackwell DGX系統創下的DeepSeek-R1推理性能世界紀錄,不僅是技術的勝利,更是對AI未來的大膽宣言。每秒3萬token的吞吐量、36倍的性能飛躍,以及近乎無損的FP4精度優化,無不彰顯英偉達在AI硬件領域的霸主地位。無論你是AI研究者還是行業從業者,這臺“推理之王”都值得你關注。

更多遊戲資訊請關註:電玩幫遊戲資訊專區

電玩幫圖文攻略 www.vgover.com