知名科技公司英伟达,市值突破了4万亿美元,超过微软和苹果,成为全球市值最高的公司,在过去的30年时间里,英伟达从一家开发图形处理游戏显卡的小公司,一路成长为全球AI巨擘!欢迎大家来到老黄发家史的第12期,今天承接前11期内容,继续聊老黄的创业史!

01 数据为王

上文讲到在与微软合作破裂后,黄仁勋秘密启动了CUDA项目,

这导致英伟达的游戏显卡业务搁置,成本激增,

面对AMD的激烈竞争和内部股东的严重分歧,

黄仁勋陷入了创业以来的最大危机,

然而,他坚信CUDA能为科学家提供超级计算工具,

尽管当时并不清楚具体应用领域,

但他预感一定会有人利用英伟达GPU掀起一场技术革命。

斯坦福教授李飞飞受到了WordNet的启发,

意识到数据是未来技术发展的新燃料,

构建了规模庞大的ImageNet数据集,

包含2200万张图像和2.2万个类别,其规模是同类数据集的1000倍。

起初,学术界并不看好,

认为突破需要算法而非数据。

为了验证数据的价值,李飞飞于2010年推出了ImageNet挑战赛,

前两届比赛的冠军团队日本NEC-UIUC和XRCE小组,

都主要依靠传统的特征工程方法取胜,错误率的下降速度缓慢,

如果继续按照这个速度,比赛可能失去意义,

而特征工程加SVM的组合似乎成为不可撼动的权威,AI革命也无从谈起,

就在ImageNet陷入僵局之际,

一个不起眼的团队引起了李飞飞的注意,

这个团队的领队正是多伦多大学的杰弗里·辛顿教授,

日后辛顿教授成为了AI教父,还拿下图灵机和诺奖两项最高荣誉!

黄仁勋与深度学习三巨头

02 神经网络

但是在当时,辛顿在学术界被认为是过时老掉牙技术的代表,

原因也很简单,辛顿坚持研究的神经网络已经是被证明是“死去”的领域,

神经网络的雏形最早源于1943年,

到58年罗森布拉特教授提出了感知机(Perceptron)算法,

掀起了60年代的AI热潮,甚至被《纽约时报》誉为“胚胎计算机”,

不过到了70年代初期,马文·明斯基和西摩尔·帕珀特

指出感知机无法解决异或(XOR)等非线性问题,

这个结论无疑也宣判了神经网络的死刑,之后学术界转而研究专家系统等AI方向。

到了80年代,神经网络的寒冬短暂复苏,

霍普菲尔德提出了霍普菲尔德网络,辛顿与特伦斯·塞诺夫斯基推出了玻尔兹曼机。

霍普菲尔德、辛顿 2024诺贝尔物理学奖

而在1986年,奠定英伟达日后取得成功的反向传播BP算法兴起,

辛顿还提出了多层感知机(MLP),能够解决复杂的非线性问题,

然而,由于计算资源匮乏和对神经网络营销的厌倦,

这些研究并未得到广泛认可。

到了1998年,Lecun开发了人类历史上第一个卷积神经网络(CNN)——LeNet-5,

LeNet-5引入了卷积层和池化层,特别适用于图像数据,

但当时英伟达才刚成立,

缺乏强大的显卡来支持如此庞大的计算量,因此也未能引起广泛关注。

进入21世纪,辛顿继续探索更深层的神经网络架构,

到了2006年,他首次创建了深度信念网络(DBN),

标志着深度学习概念的萌芽,

09年辛顿又提出了深度玻尔兹曼机(DBM),

展示出无监督预训练和生成模型的潜力。

03 黑箱模型

经过了多轮的AI泡沫,无论是学术界还是华尔街都不看好神经网络的发展,

在当时,训练深层的神经网络主要有四个问题,

第一是数据非常稀缺,获取大量高质量的标注数据耗时且成本高昂;

第二是过拟合问题,数据有限时,复杂模型容易过拟合;

第三是梯度消失问题,传统的激活函数会导致反向传播中梯度指数级缩小;

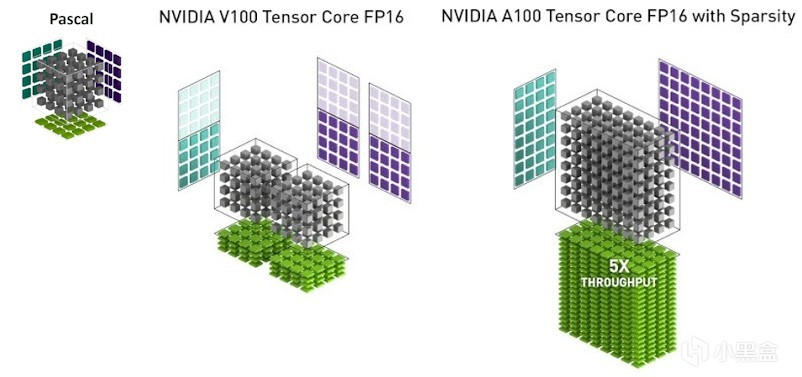

第四则是最困难的问题,传统的CPU无法高效运算,而GPU也未广泛用于通用计算。

多数学者仍认为神经网络是效果不佳的“黑箱模型”。

时间来到2011年,黄仁勋(算力)、李飞飞(数据)和辛顿(算法),

三条独立的人物线奇迹般地重合,

数据科学的这些问题也首次得到同时解决

此时距离神经网络提出时间已经过去了近70年,

英伟达和老黄的命运也即将在2012年的ImageNet大赛上彻底得到改变,

2012年也成为全球人工智能领域公认的AI元年。

接下来上场的主人公就是辛顿的两位学生,

他们即将成为全球AI领域最著名的明星,

我们还是从两位天才的故事开始讲起。

04 俄裔天才

时间来到2000年初,辛顿仍然在多伦多大学研究神经网络,

由于神经网络遇冷,研究生普遍不愿意给辛顿当研究生,

但是其中一位留学生Alex Krizhevsky对神经网络很感兴趣(下文简称为Alex),

Alex本人是俄裔母语为俄语,到了青年时期才移民加拿大,

不过Alex英语说得非常流利,但他很少在公众面前说话,

有一天,Alex突然找到了辛顿,Alex说自己是多大软件工程最优秀的研究生,

觉得学习有些无聊,希望加入辛顿团队一起做研究,

辛顿觉得非常惊讶,因为哪怕是在多大,

也有一群对他的神经网络表示冷漠甚至是敌意的学者,

这也是为何辛顿没有去斯坦福或者MIT这样的计算机学术中心,

反而“流落”到多伦多,当时多大的CS专业远远比不上北美高校,

辛顿提醒Alex可以去斯坦福、MIT这些顶级强校,

没有必要留在多伦多读博,而且研究的还是最不受欢迎的神经网络,

Alex却并不在意这些,他的优点是数学极好总能一眼抓住问题的精髓,

辛顿回忆,Alex为了让项目更容易获得学校的审批,

还特意将神经网络工作描述为“机器学习”或者“深度学习”,

以便可以从学校获得资金,唯独避免提及“人工智能”一词。

在Alex坚持不懈的努力下,最终成功加入辛顿团队,

还成为辛顿最器重的博士生!

与Alex一起成为辛顿学生的也是一位俄裔移民Ilya Sutskever(下文简称为Ilya),

Ilya同样也是数学天才,编程能力非常强,

他对神经网络的信心甚至比辛顿还要强,

Ilya在2005年时就告诉辛顿,“神经网络终有一日会超越人类的智能。”

(事实也是这样进行的,Ilya日后成为了OpenAI的四位创始人之一)

奥特曼和Ilya

05 ImageNet大赛

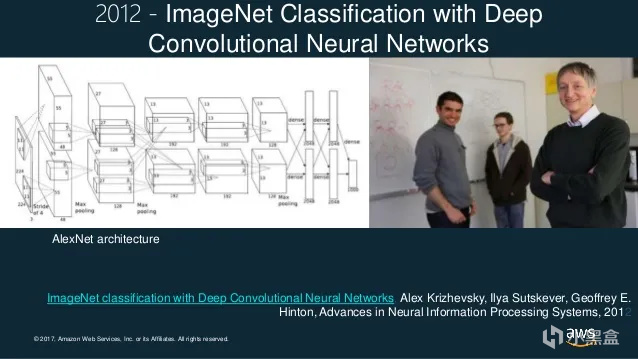

2012年,辛顿决定带着自己的卷积神经网络技术,

去挑战第三届ImageNet挑战赛,

辛顿给两位学生Ilya和Alex布置了一项看起来非常难以完成的技术,

就是利用英伟达的GPU,去训练计算机学会图像识别,

前面几期已经浓墨渲染了老黄坚持CUDA的故事,

辛顿也在自己的实验室开始运用CUDA

(不过他自己的编程能力并没有自己的学生强,

所以实际干活的都是他的研究生和博士生)。

辛顿与英伟达结缘其实是在2008年,

当时辛顿就指派自己的研究生阿卜杜勒拉赫曼和乔治·达尔,

开发了一个基于英伟达服务器的语音识别模块,

到了2009年初,这个语音识别模块已经与最优秀的机器学习模型不相上下,

这个成果让辛顿感到震惊,于是在同年的顶会NeuralPS上面,

辛顿向整个研究领域宣称,

在并行计算处理器上运行神经网络是AI的未来发展方向,

希望研究人员们立即放下手头的工作,转而采购英伟达的GPU,

不过辛顿的话并没有引起学术界的普遍注意,

甚至也没有引起老黄的注意。

06 老黄的冷落

在NeuralPS会后,辛顿亲自给英伟达发了一封电子邮件,

非常自豪地说,“我刚刚告诉这次会议上的1000名机器学习专家,

他们都应该去买英伟达的显卡。

所以,你们能送我一张免费的吗?”

结果老黄和英伟达直接拒绝了。

比较搞笑的是,当时老黄在各个高校实验室推销CUDA,

想要和高校合作,但当辛顿讨要一张英伟达GPU时,

老黄都不愿意给,

因为机器学习并不在柯克计划领域之内,

CUDA小组有时甚至故意不回复辛顿的电子邮件。

当时英伟达的AI课程也尤其让人难绷,

因为课堂里还在说神经网络无法解决简单的逻辑函数问题,

但实际上BP算法早在几十年前就突破了这一限制,

辛顿对老黄的冷落极度不满,他心想既然无法和英伟达合作,

唯一的方法就是彻底打败他们,搞一个大新闻出来,

辛顿仔细看了下自己的研究生和博士生团队,

最终挑出了两位他最得意的门生,

没错也就是上面介绍的Alex和Ilya,

接下来辛顿以多伦多大学的名义正式参加第三届ImageNet挑战赛。

07 李飞飞的危机

除了老黄的CUDA危机、辛顿的神经网络危机,

李飞飞的ImageNet也遇到了大危机,

因为从ImageNet创立之初,学者就嘲笑李飞飞是想大力出奇迹,

认为ImageNet就是规模大,没有太大的意义,

2010年吸引了35位参赛者之后,

2011年的参赛者却锐减至15人,

到了2012年,更是只剩下7位参赛者,

竞赛是否能够再延续一年都成了未知数,

如果ImageNet失败,李飞飞能否可以保住自己在斯坦福的教职还是个问题,

更别提成为AI教母、三院院士,

站在2012年,辛顿已经65岁即将退休,

老黄和李飞飞都处于危机之中,

拯救他们命运的钥匙,就落在了Ilya和Alex身上。

08 秘密实验

在辛顿看来,Ilya和Alex有很多共同点,

他们的数学和编程能力强,很多时候只需要辛顿开启一个问题,

Ilya和Alex便会开始用俄语讨论,然后直接给出正确的答案,

这次的ImageNet挑战赛,辛顿希望两人用卷积神经网络构建一个图像识别系统,

虽然是首次参赛,辛顿鼓励两人不仅要赢,

而且还要彻底击败所有其他的竞争对手,

这样英伟达才有可能注意到他们,

辛顿的建议可以先从简单的图像识别任务练手,

还让Alex研究下英伟达的CUDA。

于是Alex开始了自己的秘密实验,

只花了几个月时间,Alex迅速成为并行计算编程的专家,

比全世界任何人都能更有效地使用那些GPU板卡运行卷积神经网络,

2012年初,Alex已成功改造了一个原本仅用于教学练习的经典学术图像识别网络,

而且还可以在CUDA上顺畅运行,

更加令人震惊的是,GPU仅用30秒就完成了训练

(而用英特尔的CPU则需要1个小时以上),

辛顿自己是理论派大师,他想过自己的卷积神经网络肯定有前途,

但这样的速度也让他大吃一惊,而且他没想到英伟达的GPU居然这么厉害,

当时辛顿并没有将这些实验公开,因为他想直接在ImageNet这个更大的舞台证明自己!

Alex krizhevsky

09 GTX 580

ImageNet有2200万张图像和2.2万个类别,数据集非常庞大,

为了支持研究,Ilya和Alex两位研究生开始筹集资金,

希望打造出一台运行尽可能快的计算机。

然而两人都是从俄到加拿大的留学生,并不是什么富二代,

资金有限的情况下,Ilya和Alex省吃俭用买了两块游戏显卡——GTX 580。

GTX 580在2010年11月发布,一张卡的单价约为500美元,

580是英伟达的旗舰游戏卡,支持DX11,

当时比较火的3A大作是显卡杀手孤岛危机系列,

多数人买580其实都是为了打游戏,

而Ilya和Alex则是为了搞科研。

Ilya回忆,当时580送过来的时候,

外形看起来就像是电影《异形》中的道具一样,

每张显卡大约重1.36公斤,外壳是黑色的,装饰是鲜绿色的,

还有一个圆形的通风口,里面装有强力风扇,

而在这个外壳之下,是一块巨大的英伟达芯片,

它被嵌入黑色的电路板,周围布满了散热片,

这块芯片由30亿个晶体管构成,被排列在32个并行核里,

这也正是Alex最需要的东西

(现在大家认为H100、A100这类才是AI计算卡,但在当年580就是AI的初代神卡)。

10 疯狂科学家

回到家中,Alex一刻都没有停歇,

将两块GTX 580交火插在自己的PC上,

然后在自己搭建的卷积神经网络上持续运行了1周

(辛顿回忆自己也没有给Alex付电费,后来是Alex父母承担了这笔实验费用),

此时此刻,老黄还完全蒙在鼓里,

他完全没想到,Alex成为了全世界第一个吃螃蟹的人,

未来在GTX 580基础上诞生的英伟达计算卡,

甚至会成为各个国家核战略级别的算力资源!

而改变这一切的Alex,甚至还是自己省钱买显卡,

老黄给Alex磕一个都不过分!

为了参加ImageNet比赛,Alex搭建了一个约有65万个独立神经元的网络,

要训练如此庞大的模型,数据需求量极大,

在训练的开始阶段,神经元是以随机方式连接的,

但随着训练深入,它们会重新组织成一个错综复杂且精美的结构,

Alex的神经网络会接收到随机选取的数据集图像,

并需要从李飞飞提供的数千个类别中为其选定一个标签。

图像内容可能是一条黄貂鱼,也可能是一只苏格兰梗犬,或者是一辆高尔夫球车,

不论何种内容,神经网络都是首次接触,

因此在选定标签时,它只能进行猜测,

所以第一次猜测往往都是错误的,

然而在这次错误的猜测中,网络也获取了一些关于图像内容的微弱线索,

比如至少能确定图像并非黄貂鱼,

然后神经网络会借助辛顿提出的反向传播方法,

来调整神经元间的连接处理这些信息,

真正麻烦的也就是BP这一步,因为需要涉及到大规模的“矩阵乘法”。

11 Matrix

过去,许多训练神经网络的尝试,其实都卡在BP做矩阵计算的这一步,

而Alex拥有比其他科学家更厉害的神器——GTX 580,

而且他还专门写了适配矩阵计算的CUDA代码,

可以用GTX 580的并行架构进行高效运算,

一旦数学运算完成,Alex的网络便会接收到第二张图像,

紧接着是第三张、第四张,直至成千上万张,甚至数百万张。

为了“观看”这些图像,神经网络实际上并不处理光线,

相反它接收的是一串数字,这些数字代表着特定像素阵列的排列与颜色,

随后,神经网络会更新代表不同解释层突触权重的数字网格,

在训练刚开始的几分钟内,Alex就取得了重大收获,

因为他的神经网络意外地成功标记了首张图像——花盆,

这次成功触发了大量的矩阵乘法运算,BP会不断向神经网络传达,

是什么特征让“花盆”区别于“黑猩猩”“台球桌”或“自卸卡车”。

就这样,这个过程日复一日地重复了数百万次,

Alex的卧室仿佛变成了一个高速进化的世界,

每天晚上,Alex都会被显卡风扇噪音吵得无法睡觉,

但是他发现图像识别的准确率从0%开始缓慢攀升,

逐渐达到1%、10%、40%、60%,

这说明他们的实验和假设成功了,神经网络的时代已经到来!

12 一鸣惊人

2012年的ImageNet大赛,Alex带着自己全新的卷积神经网络参赛,

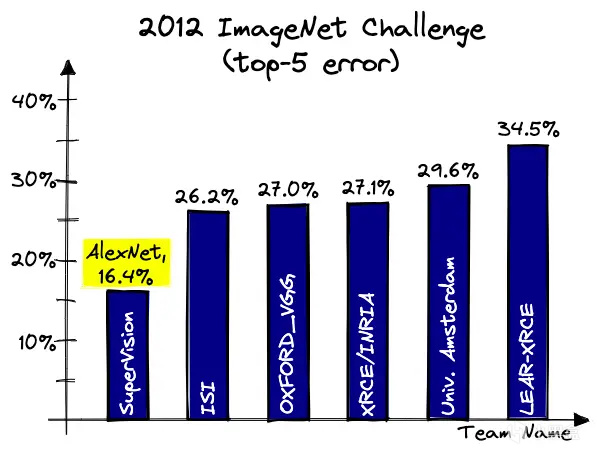

过去传统的机器学习方法比如SVM、手工特征提取的Top-5错误率高达25%以上,

而辛顿团队的Top-5错误率15.3%,

较第二名(26.2%)提升近11个百分点,创历史最大幅度提升,

辛顿和两位学生Alex、Ilya从此也一鸣惊人,

成为全世界最炙手可热的AI明星,

不夸张地说,如今的AI时代,正是他们三人开启的,

背后李飞飞凭借ImageNet大赛奠定在学术界的地位,

而世俗意义上赚得最多的是闷声发大财的老黄,

曾经英伟达团队对辛顿的神经网络爱答不理,

还要Alex和Ilya省钱去买显卡,

如今英伟达却因为他们的成绩名声大噪,

一跃成为全球第一大公司,

背后有太多太多的偶然,

而当所有偶然都聚集在一起时,似乎也成为了必然。

Alex将他的神经网络命名为“SuperVision”,

日后大家将这个神经网络用Alex的名字命名为AlexNet,

2012年也成为AI元年,GTX 580这张显卡也成为AI博物馆里程碑级别的标志!

2013年,就在AlexNet发布一年以后,

辛顿很快就遇到了新的挑战,老黄也遇到了新对手,

AlexNet虽然出来了,但是从学术竞赛到如今的大模型开花,

还有很长很长的一段路要走,

辛顿、Alex和Ilya的故事才刚刚开始,

老黄的命运也从此被绑上AI的战车,

欲知后事如何,且听下回分解!

游戏&AI系列:

老黄发家史——英伟达市值突破4万亿,老黄的传奇人生!

老黄发家史——传奇AMD工程师,老黄人生的第一份工作!

老黄发家史——世嘉主机拯救英伟达,老黄曾差点破产!

老黄发家史——FPS天才成就英伟达,N卡的诞生!

老黄发家史——N卡大战A卡,上古芯片巨头ATI!

老黄发家史——英伟达创造显卡,PC游戏的崛起!

老黄发家史——极客玩家的一次灵感,启发英伟达进军AI!

老黄发家史——让玩家为 AI 买单,老黄成功的秘诀!

老黄发家史——CUDA崛起,英伟达AI的护城河!

老黄发家史——华人AI教母李飞飞,老黄发家的贵人!

老黄发家史——神经网络,AI革命的起点!

AI——是游戏NPC的未来吗?

巫师三——AI如何帮助老游戏画质重获新生

你的游戏存档——正在改写人类药物研发史

无主之地3——臭打游戏,竟能解决人类大肠便秘烦恼

一句话造GTA——全球首款A游戏引擎Mirage上线

AI女装换脸——FaceAPP应用和原理

AI捏脸技术——你想在游戏中捏谁的脸?

Epic虚幻引擎——“元人类生成器”游戏开发(附教程)

脑机接口——特斯拉、米哈游的“魔幻未来技术”

白话科普——Bit到底是如何诞生的?

永劫无间——肌肉金轮,AI如何帮助玩家捏脸?

Adobe之父——发明PDF格式,助乔布斯封神

FPS游戏之父——谁是最伟大的游戏程序员?

《巫师3》MOD——制作教程,从零开始!

#gd的ai&游戏杂谈#

更多游戏资讯请关注:电玩帮游戏资讯专区

电玩帮图文攻略 www.vgover.com

![好想回到公司没钱的时候[cube_doge]](https://imgheybox1.max-c.com/bbs/2025/11/21/56ce39f9ee8ebbfa0618d755eb4b17a6.jpeg?imageMogr2/auto-orient/ignore-error/1/format/jpg/thumbnail/398x679%3E)