前言:深度學習並不難

在2024年的當下,人工智能成爲最熱門的方向,一提到AI,總會有各種各樣的熱詞,機器學習、深度學習、大模型、生成式AI、通用AGI等等,AI同樣是肉眼可見地影響着我們的生活,像AlphaGo這樣的應用直接顛覆了圍棋職業選手的生態,而Stable Diffusion、SoVits、GPT這些技術也在改變各行各業,幾乎各個專業都開始做AI的交叉方向,筆者差不多四年前系統寫過機器學習入門,本篇文章就聊聊深度學習入門。

前言

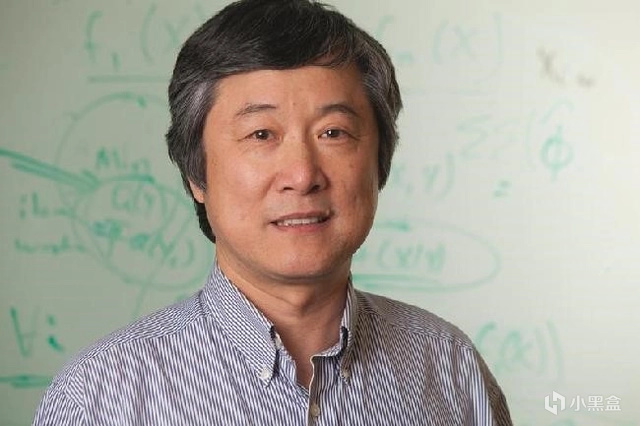

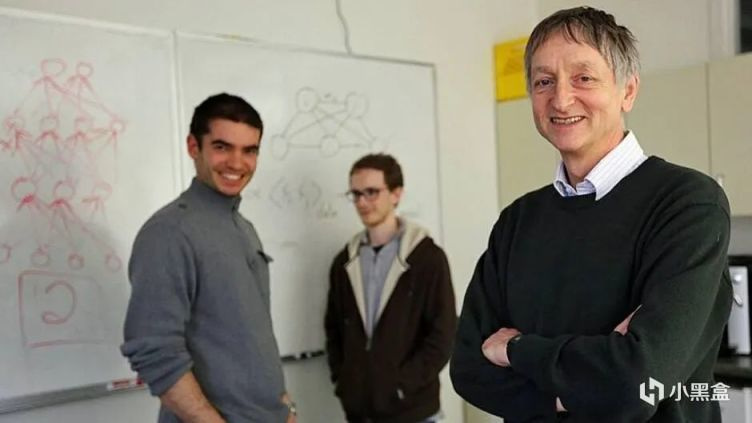

計算機領域的諾貝爾獎是大名鼎鼎的“圖靈獎”,今年圖靈獎剛剛頒佈,普林斯頓高等研究院教授艾維·維格森成爲歷史首位拿下數學領域阿貝爾獎和計算機科學領域圖靈獎的學者。最近十年,圖靈獎破圈是在2018年,當時號稱是人工智能深度學習三巨頭的Yoshua Bengio、Geoffrey Hinton 和 Yann LeCun,三人共同獲得了18年的圖靈獎,成爲深度學習領域的標誌性事件。

Hinton辛頓教授是當之無愧的C位,三巨頭之一的Yann Lecun還是Hinton的學生。而就在三人獲獎的前一年,柯潔在烏鎮不敵AlphaGo,宣告人類棋手不敵人工智能,之前寫圍棋系列柯潔那張老圖,就是出自烏鎮這次歷史標誌性事件。多個關於AI的頭條輪番轟炸下,就像近兩年的大模型一樣,深度學習成爲18年的熱詞。

同年,Bengio和學生Ian Goodfellow推出了新書《Deep Learning》,中文版《深度學習》,也就是大家熟知的花書,被譽爲深度學習領域聖經,爆火的還有李沐的《動手學深度學習》、邱錫鵬的《神經網絡與深度學習》以及《Python深度學習》幾本包含代碼實戰的深度學習書。

往前還有筆者四年前推薦的周志華西瓜書和李航的《統計學習方法》,再往前還會啃PRML、ESL等經典的統計學習書籍,對於初學者來說,晚入門優勢是學習資料成熟,通往大模型的學習路徑更加清晰,比如2014年入門的時候還是VGGNet,到2024年入門的時候整個世界都變了。

這也是我又開始寫深度學習入門的原因,技術發展速度太快,每一年重新回顧深度學習的時候,會發現主軸一直在變化,站在19年回望14-19年這五年,大家以爲GAN會一統江湖,但是站在19-24年這五年,原來GPT纔是主軸,創新是很難被預測或者計劃的,我想到了29年再回顧24-29年,到時候可能又會調整對深度學習的看法。

深度學習入門

本文主要面向有一定數學基礎的研究生和博士生。如果說什麼方法能夠最快最好的入門深度學習,那麼一定是耐心讀基礎的論文,瞭解原理然後進行復現,深度學習領域可以說是距離我們時間最近的新興方向之一,從全面爆發到現在也不過十多年時間,雖然時間不長,但是論文數量一點也不少。

1. ImageNet比賽(AlexNet)

深度學習元年,一般被視作是2012年,斯坦福大學李飛飛教授創立ImageNet項目,一個大規模的圖像數據庫,李飛飛舉辦了ILSVRC計算機視覺比賽,旨在推動圖像識別技術的進步。圖靈獎三巨頭之一Hinton辛頓教授,他的兩位學生Alex Krizhevskyh和Ilya Sutskever在ILSVRC12上奪冠,並取得了壓倒性的勝利,他們發佈的AlexNet是一個深度卷積神經網絡,在圖像分類任務上的表現,遠遠超過了以往的最佳方法。

Imagenet classification with deep convolutional neural networks.

相比於傳統的機器學習算法,AlexNet使用了卷積神經網絡CNN,並在神經網絡中使用ReLU作爲卷積神經網絡的激活函數,解決了傳統激活函數Sigmoid在網絡更深時遇到的梯度消失問題,爲了防止過擬合,訓練時採用Dropout隨機忽略神經網絡中的一部分神經元,從平均池化改成了Max Pooling提升特徵豐富性等等,AlexNet讓深度學習開始逐漸成爲人工智能研究的主流技術。

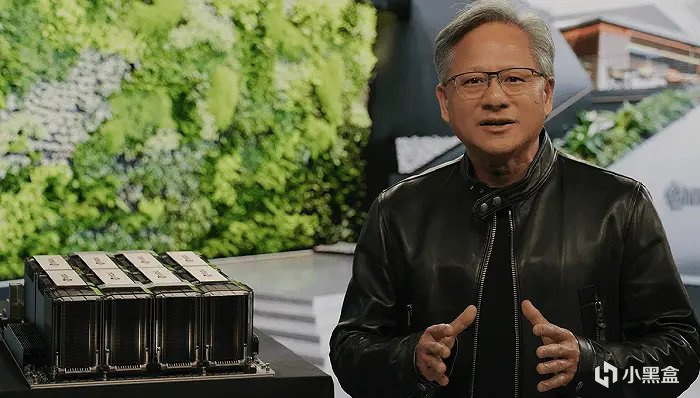

一系列的改進,AlexNet成爲全球關注的焦點,大家發現深度學習在處理複雜的視覺分類任務上,居然比傳統方法要好得多。當然,AlexNet還有一大成功法寶就是使用了英偉達老黃的GPU進行加速,當時Alex負責搭建網絡,而IIya負責寫CUDA代碼,多年以後,IIya成爲了OpenAI的創始人兼首席科學家,而黃仁勳的英偉達成爲全球市值增長最快的科技巨頭。

2. 更深的網絡(VGGNet、GoogLeNet)

既然AlexNet深層卷積神經網絡這麼好用,大家開始研究到底爲啥它好用,以及如何調整改進AlexNet,2014年,ImageNet大規模視覺識別挑戰賽(ILSVRC)上,GoogLeNet和VGGNet成爲前兩名。

Very deep convolutional networks for large-scale image recognition.

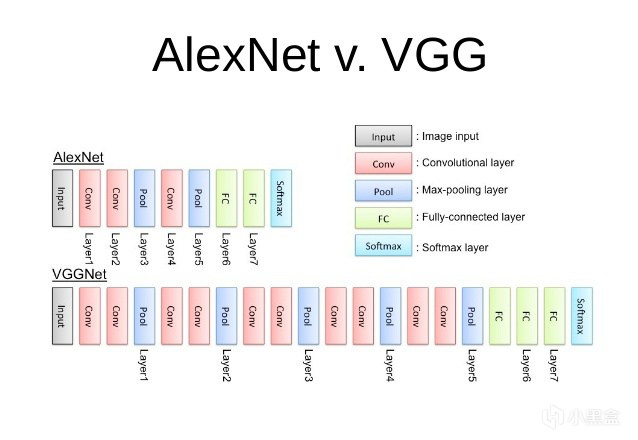

首先來看VGGNet,對比AlexNet,VGGNet更深了,如果包含全連接層,一共達到了22層,這樣的設計在當時是前所未有的,VGGNet使用了3x3的小卷積核,能夠捕捉到圖像中的局部特徵,每個卷積層後面緊跟着一個2x2的最大化池化層(Max pooling),用來減少參數數量避免過擬合,當時VGGNet還允許研究者通過增加層數來進一步提升性能,例如VGG-16和VGG-19。

Going deeper with convolutions.

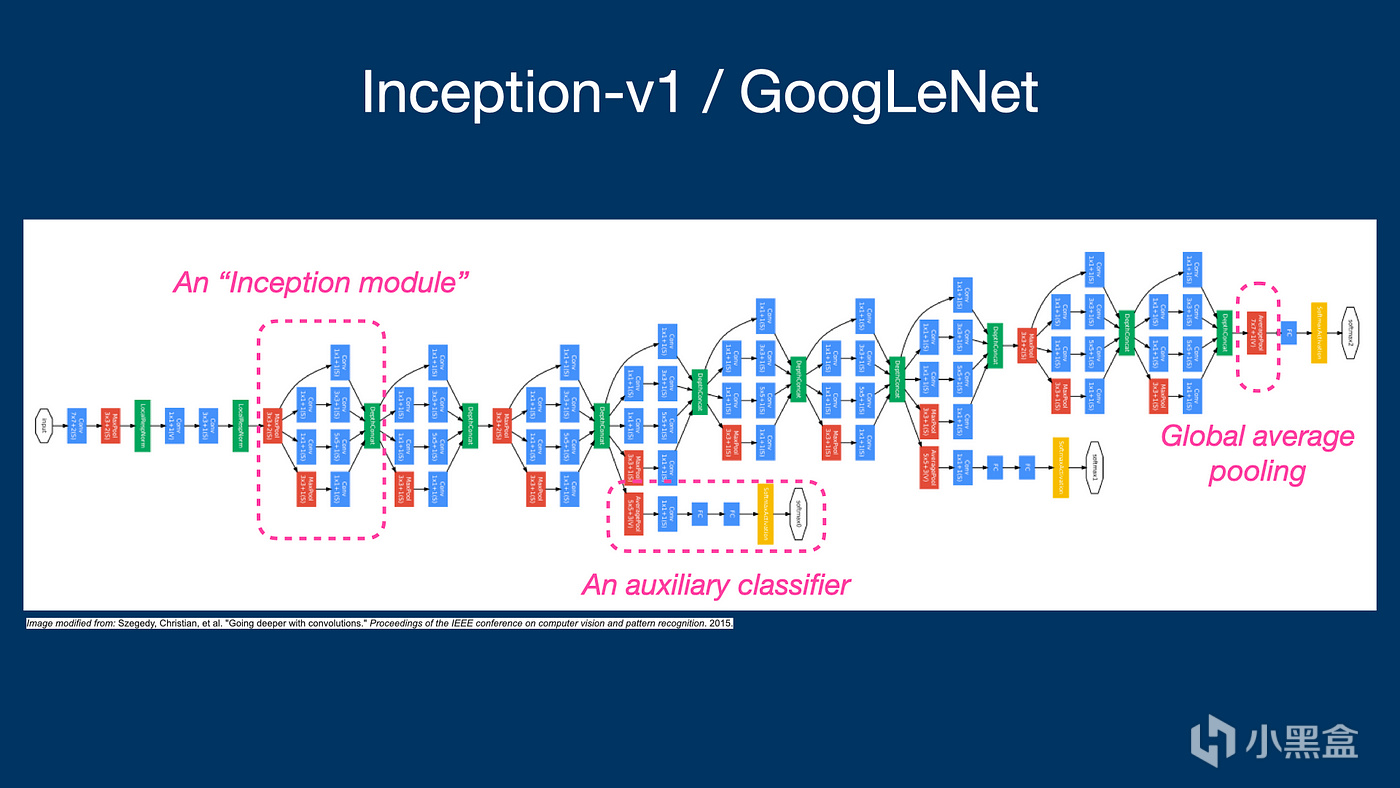

GoogLeNet在ILSVRC14取得了第一名,核心是Inception模塊,對比VGGNet使用的3x3小卷積核,GoogLeNet使用1x1, 3x3, 5x5不同尺寸的卷積層,給人印象最深的當然是1x1卷積核,能夠在不顯著增加計算負擔的情況下,增加網絡的深度和寬度,GoogLeNet在分類和檢測任務中均取得第一名的成績,對後續的設計理念對深度學習研究的啓發也同樣很大,Inception模塊的概念被廣泛應用於後續的網絡架構中,如Inception-v3、Inception-v4和EfficientNet等等等。

3. 初代神經網絡(LeNet)

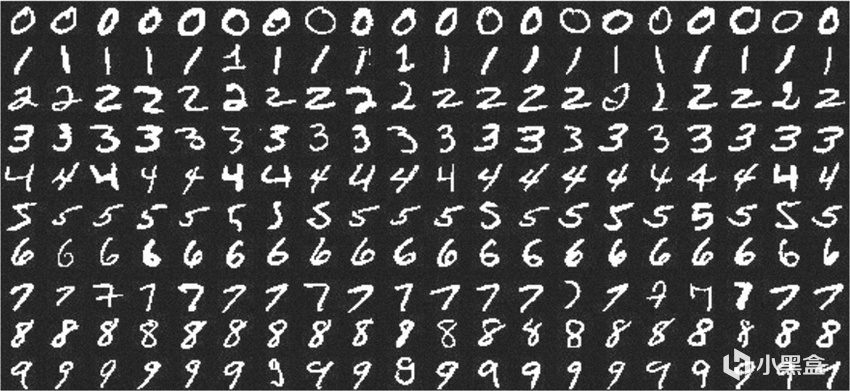

提到GoogLeNet,就不得不聊聊初代的神經網絡LeNet,1988年,圖靈獎三巨頭之一的Lecun,利用反向傳播BP算法,成功訓練多層神經網絡,進行MNIST手寫數字識別,1998年,Lecun推出的LeNet-5模型,成爲深度學習和卷積神經網絡發展史上的重要里程碑。

LeNet結構包括卷積層、下采樣層和全連接層,這些成爲後來深度學習模型的基礎,在1980年代到2012年之前的這段時間裏,儘管BP算法和神經網絡已經存在,但深度學習的發展相對緩慢。這主要是因爲當時的計算資源有限,無法支持大規模的神經網絡訓練,此外,傳統的機器學習算法,如支持向量機(SVM)等,在許多問題上也能取得不錯的效果,這在一定程度上減少了對深度學習模型的需求。

4. 殘差網絡(ResNet)

Deep Residual Learning for Image Recognition

接下來15年,何愷明的ResNet橫空出世,直接統治了ILSVRC 15和COCO 15,ResNet可以說是在前Transformer年代最知名的一篇論文,拿下CVPR的最佳論文,ResNet核心思想是殘差學習,將網絡層學習的內容,從直接映射轉變爲學習輸入與輸出之間的殘差(差異),緩解網絡深度增加而出現的梯度消失和梯度爆炸問題,ResNet由多個殘差塊組成,每個殘差塊包含兩個或更多的卷積層,通過Shortcut連接,對比此前的AlexNet等結構,ResNet能夠訓練高達152層的網絡,這在當時是一個前所未有的深度。

實驗結果表明,隨着網絡深度的增加,ResNet的性能也相應提高,這也成爲解決了之前“網絡深度增加會導致網絡表現下降”的問題,ResNet在訓練過程中使用了Batch Norm和ReLU激活函數,但不需要使用Dropout或者Maxout這類正則化,因爲殘差學習本身就有正則化的效果,ResNet因其出色的性能和可擴展性,在計算機視覺領域的多個任務中得到應用,包括圖像分類、目標檢測、語義分割等,爲後續的深度學習模型設計提供了新的思路。

深度學習從ImageNet開啓的計算機視覺CV時代而起,早期的自然語言理解NLP等領域,相對於CV其實並沒有那麼火,但是同樣也值得一聊,畢竟今天的Transformer時代,也是同樣建立在前人的肩膀上完成的。2012年,除了AlexNet以外,Hinton辛頓教授還有一篇將神經網絡用於語音識別的論文。

5. 轉折點

Deep neural networks for acoustic modeling in speech recognition: The shared views of four research groups.

深度學習始於2006年Hinton辛頓的深度置信網絡(Deep Belief Nets/Deep Belief Network,DBN),到了12年開始,大家開始研究如何把網絡變得更深,深度神經網絡(DNN)成爲當時最熱門的方向,在應用領域方面,辛頓將DNN應用在語音識別方向,希望能夠代替之前的隱馬爾可夫模型(HMMs)。

論文中提到了用循環神經網絡(RNNs)和長短期記憶網絡(LSTM)架構用於語音識別領域,辛頓這篇論文成爲語音識別領域的轉折點,爲接下來幾年快速發展奠定基礎,論文的作者來自多個不同的研究小組,代表了當時語音識別領域的頂尖力量,其中包括微軟研究院語音研究首席科學家鄧力。

後話:放在四年前,還是Bert和GPT等模型爭雄的時候,許多人認爲AI離自己很遠,但是短短四年後,AI方面的應用已經在各方面開花,英偉達、OpenAI、微軟,成爲當下全球科技聚光燈中心的公司,人人都在聊GPT,海量的資金湧入大模型領域,大量研究生博士生即使不是CS領域,也開始做與AI大模型的交叉方向。本文暫時先更到這裏,預計完結至少需要15篇左右的篇幅,如果大家喜歡的話,再繼續將這個坑填完,之後有時間再繼續寫大模型的發展史&入門,Hinton的學生們成爲臺上的焦點。

機器學習基礎:

AI編年史——深度學習的發展史(收藏向)

AI編年史2——GPT是如何誕生的?

AI學術巨佬——何愷明,從遊戲中獲得論文靈感

AI領軍人物——孫劍,重劍無鋒的經典之作

AI傳奇巨佬——湯曉鷗,中國人工智能領袖人物!

張益唐——黎曼猜想,華人數學家再創重大突破!

B站大學——線代不掛科,MIT傳奇教授的最後一課!

微軟免費AI課程——18節課,初學者入門大模型!

機器學習——科學家周志華,成爲中國首位AI頂會掌門人!

機器學習入門——數學基礎(積分篇)

機器學習入門——數學基礎(代數篇)

機器學習入門——數學基礎(貝葉斯篇)

遊戲&AI系列:

AI——是遊戲NPC的未來嗎?

巫師三——AI如何幫助老遊戲畫質重獲新生

AI女裝換臉——FaceAPP應用和原理

AI捏臉技術——你想在遊戲中捏誰的臉?

Epic虛幻引擎——“元人類生成器”遊戲開發(附教程)

腦機接口——特斯拉、米哈遊的“魔幻未來技術”

白話科普——Bit到底是如何誕生的?

永劫無間——肌肉金輪,AI如何幫助玩家捏臉?

Adobe之父——發明PDF格式,助喬布斯封神

論文相關:

畢業季雜談——如何隨時免費使用中國知網?

畢業季雜談——論文降重的“奇技淫巧”

畢業季雜談——大學教材如何獲取

畢業論文——Latex論文排版語言介紹

更多遊戲資訊請關註:電玩幫遊戲資訊專區

電玩幫圖文攻略 www.vgover.com