明天就是除夕了,祝喝油們新年快樂喵,本來今天放假的,有感而發又寫了一篇。

在國內 AI 火起來,是一年前的 DeepSeek。

差不多就是去年的這時候。

我感覺,

AIGC 的童年時代結束了,即將到來的是 AIGC 的青年時代。

這幾天整個互聯網,尤其是 B 站都被Seedance 給刷屏了。

(有點像當時 Sora2,畢竟視頻的傳播屬性就是強。)

也就是去年二月這個時候,

那時候 DeepSeek 剛出來,

以一種近乎破局者的姿態登場,用混合專家模型MoE架構證明了高效能與低成本可以兼得,

一轉眼,整整一年過去了。

你會發現歷史總是驚人的相似卻又在螺旋上升,這次輪到字節跳動了。

Seedance 2.0 這次的震撼,我個人感覺更大。

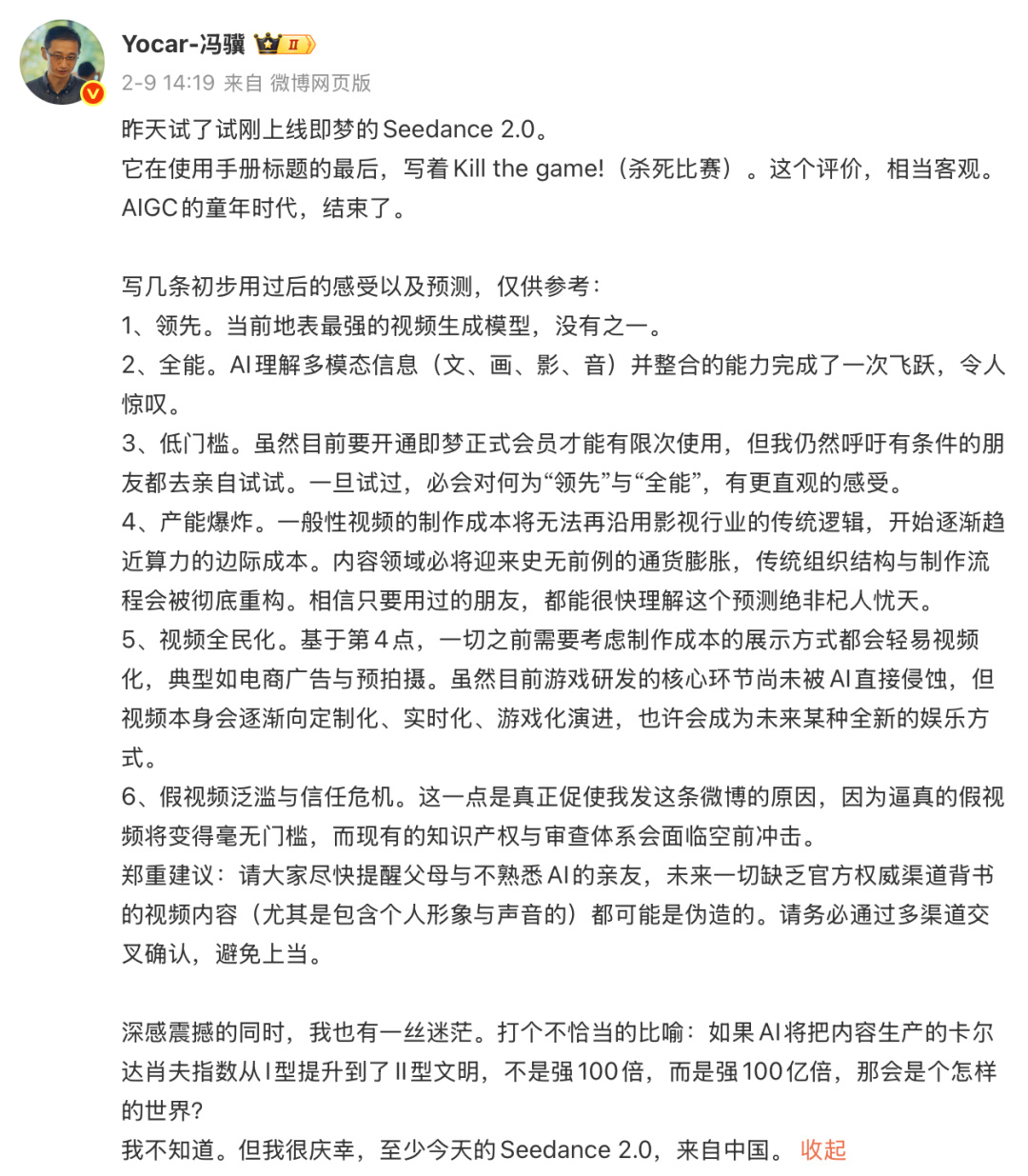

我這裏直接上馮驥老師(遊戲科學創始人)的評價:

馮老師的洞察特別深刻,我就是看了他這番話有感而寫這篇文章。

我也分享一下自己做的即夢 Case(這是米哈遊絕區零的一個角色,甚至連胸部的抖動都復刻了。。。)

我把視頻上傳即夢了,放鏈接又被判定引流。。。

https://jimeng.jianying.com/s/tgrAqKSwiKM/

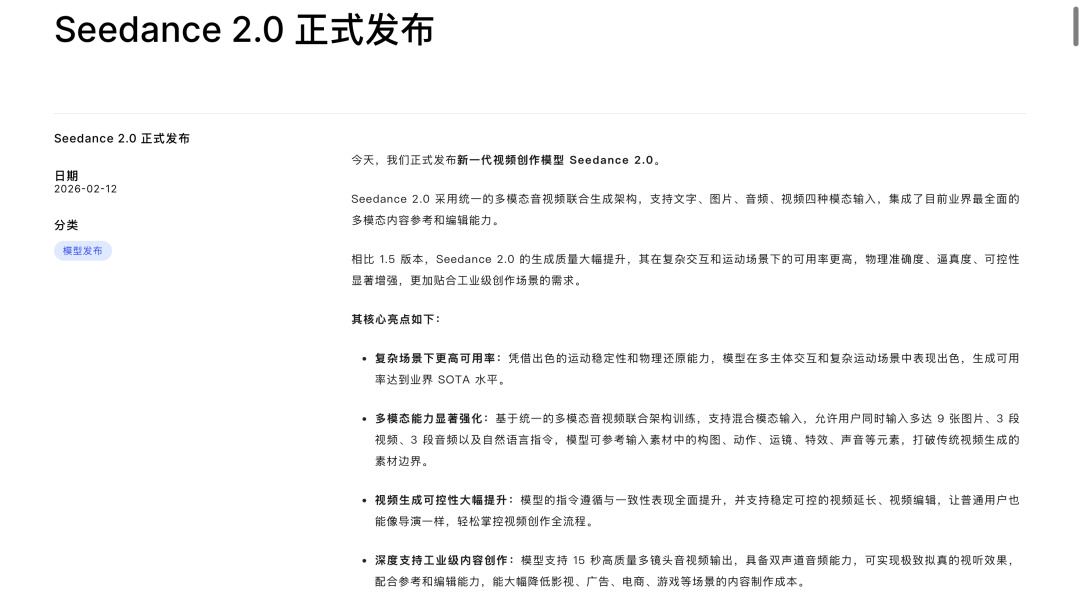

也附上即夢官方的焚訣:

https://bytedance.larkoffice.com/wiki/A5RHwWhoBiOnjukIIw6cu5ybnXQ?from=from_copylink

我問了我身邊的影視從業者,漫劇行業的朋友,

他們的回答都是十分悲觀,甚至有些開始恐慌自己將要失業了。。。

在 Seedance2.0 還沒出的時候,我大言不慚的說影視從業者要培養導演思維,

因爲這是 AI 目前不會的。

結果 Seedance2.0的分鏡,剪輯,導演思維,超過 90% 的普通人。

現在網絡上已經有非常多 Seedance2.0 的測評了,

本文就不花太多篇幅講它有多強,主要來自己發發牢騷和分享一些拙見。

未來的初級影視創作者的方向。

說實話,我非常迷茫。

如果說DeepSeek打破了西方在基礎大模型上的壟斷神話,

那麼Seedance 2.0則是把AI視頻從玩票性質的抽卡遊戲,真正推向了工業化生產的新階段。

我試着點開了幾個演示視頻。

是 Sora2 之後給我最大的驚豔,以前那些 AI 視頻,

人臉動不動就崩壞,喫麪條能喫到鼻子裏去,看着跟恐怖片似的。

Seedance2.0 的神力,隨便打開抖音 B 站都能看到。

Seedance其核心技術底座在於雙分支擴散Transformer架構。

(圖源自字節跳動官方)

不同於市面上常見的先生成視頻後匹配音頻的串行邏輯,Seedance 2.0通過注意力橋接機制,

讓視覺與聽覺在毫秒級的時間維度上實現了視聽同構,這意味着視頻裏的玻璃破碎聲和腳步聲都能實現原生的聲畫同步,而無需後期對位。

(圖源自字節跳動官方)

用戶可以像向攝影師下達指令一樣,通過自然語言並配合最多12個參考文件,

其實更誇張的是,你可以直接上傳一張分鏡圖,它就可以根據分鏡圖生成短片。

(更更離譜的,上傳一張小說圖片,他會識別圖片中文字內容,生成視頻。。。這個 Case沒放出來)

再放一個《絕區零》的分鏡圖 Case(op 實錘)

等待時間,11 個小時。。

沒辦法,實在是太火了,而且我還氪金了會員。。。。

等了差不多 6 小時,終於生成出來的,質量也是超級高。

(鏈接同上)

那一刻我有點恍惚。

我想起小時候在村口看露天電影,那時候覺得那是城裏人的魔法。

現在,這魔法就在我這個破iPhone裏。

這東西已經不是簡單的玩具了,是工業化。

OpenAI 的Sora2,現在看來,也沒那麼香了,甚至有點受潮了。

但我感覺年後應該沒過多久,其他大廠又會猛猛發力追上字節,

那現在,就讓我們,

先恭喜字節跳動,

也享受第一個 AI 時代的春晚吧。

更多遊戲資訊請關註:電玩幫遊戲資訊專區

電玩幫圖文攻略 www.vgover.com