凌晨兩點,你的畢業論文因爲DeepSeek雲端服務崩潰而卡在最後一章,這種絕望時刻只需要一個7B大小的『AI備胎』就能拯救。雖然本地部署的模型像迷你便利店不如雲端沃爾瑪商品齊全,但在雲端服務還在顯示正在故障或者繁忙卻緊急需要訪問LLM類服務時,本地部署的Deepseek-千問蒸餾7B模型能提供快速響應。日常的大部分LLM需求(如簡單Python代碼生成、問題解答)都可被本地模型消化。

但是本地化的推理不可避免的會遇到算力的問題,GPU的顯存是非常珍貴的資源,一個7B模型大概就要消耗5GB顯存,這樣本地部署一個大模型,當前的GPU就只能處理LLM推理任務,就沒辦法遊戲或者進行生產。如果使用CPU,雖然可以使用非常大的內存,但是LLM的計算負載又會大量佔用CPU,導致系統卡頓。但是核顯就是一個既能夠使用主機內存,又能和CPU獨立運行的中間地帶。而且高性能主機上一般都是獨顯負責視頻輸出和遊戲,核顯都是閒置資源。所以使用核顯進行本地模型的部署也不會對整機性能帶來影響。

最近具備高性能核顯和NPU的Ultra系列CPU大降價,所以入手了一顆Ultra 245K,用來本地化自己的DeepSeek模型,自建了一臺能跑AI的工作站,本文詳細記錄了使用UltraGPU本地部署DeepSeek模型的詳細流程和踩坑記錄,希望各位大神能夠輕噴哈哈哈。

裝機方案

裝機使用瞭如下方案:

1. CPU: Intel ultra 245K

2. 主板: 銘宣終結者B860M

3. 內存: 光威 龍武 DDR5 16*2 6000mhz 套條 (這個之前搞活動400多就能到手)

4. 機箱:拓撲龍 開放式機箱 (拓撲龍的nas機箱很出名,沒想到還做開放式機箱,只要30就能到手,比鞋盒豪華多了😂)

5. 愛國者EP650 650w電源 兩百塊左右的全模組電源,用起來還算穩定

Ultra245K採用了精緻的小黑盒作爲其包裝設計,這種包裝不僅給人一種高端而低調的感覺,還特別在正面設置了一個透明的觀察窗。通過這個觀察窗,消費者可以直接看到內部CPU的模樣,無需打開包裝就能一窺這款處理器的風采。這樣的設計既滿足了用戶的好奇心,也增加了產品的吸引力,讓人一眼就能感受到Ultra245K的強大性能與獨特魅力。此外,透明窗口的設計也讓產品更加直觀地展示給了潛在買家,有助於提升購買慾望。總之,從外包裝到內核展現,Ultra245K都體現了對細節的關注和對用戶體驗的重視。

打開包裝箱後,首先映入眼簾的是中央處理器(CPU)的正面。在這個表面上,精心雕刻着關於該CPU的重要信息,比如型號、序列號以及製造商等細節。除此之外,還印有一個二維碼。

背面爲觸電和電容,排布的非常規整。CPU整體爲長方形,同時CPU偏心開了兩個凹槽,這樣裝機時無需對CPU的小三角,直接通過凹槽就能確定CPU的安裝方向。

主板使用了銘宣的B860M終結者,整體爲黑白色調,採用了12相供電,能夠保證UltraCPU的穩定運行。同時,擁有支持雙通道4根DDR5內存,目前最大支持128GB內存。Ultra CPU徹底拋棄了對DDR4內存的支持,轉向原生的DDR5內存控制器,這直接帶來的就是對7000Mhz DDR5內存頻率的原生支持。在高內存負載的場景中,DDR4→DDR5升級可帶來15-35%的典型速度提升,極端情況下可達40%+。

機箱使用了拓撲龍的開放式機架,整體組裝完成後效果如下:

CPU性能測試

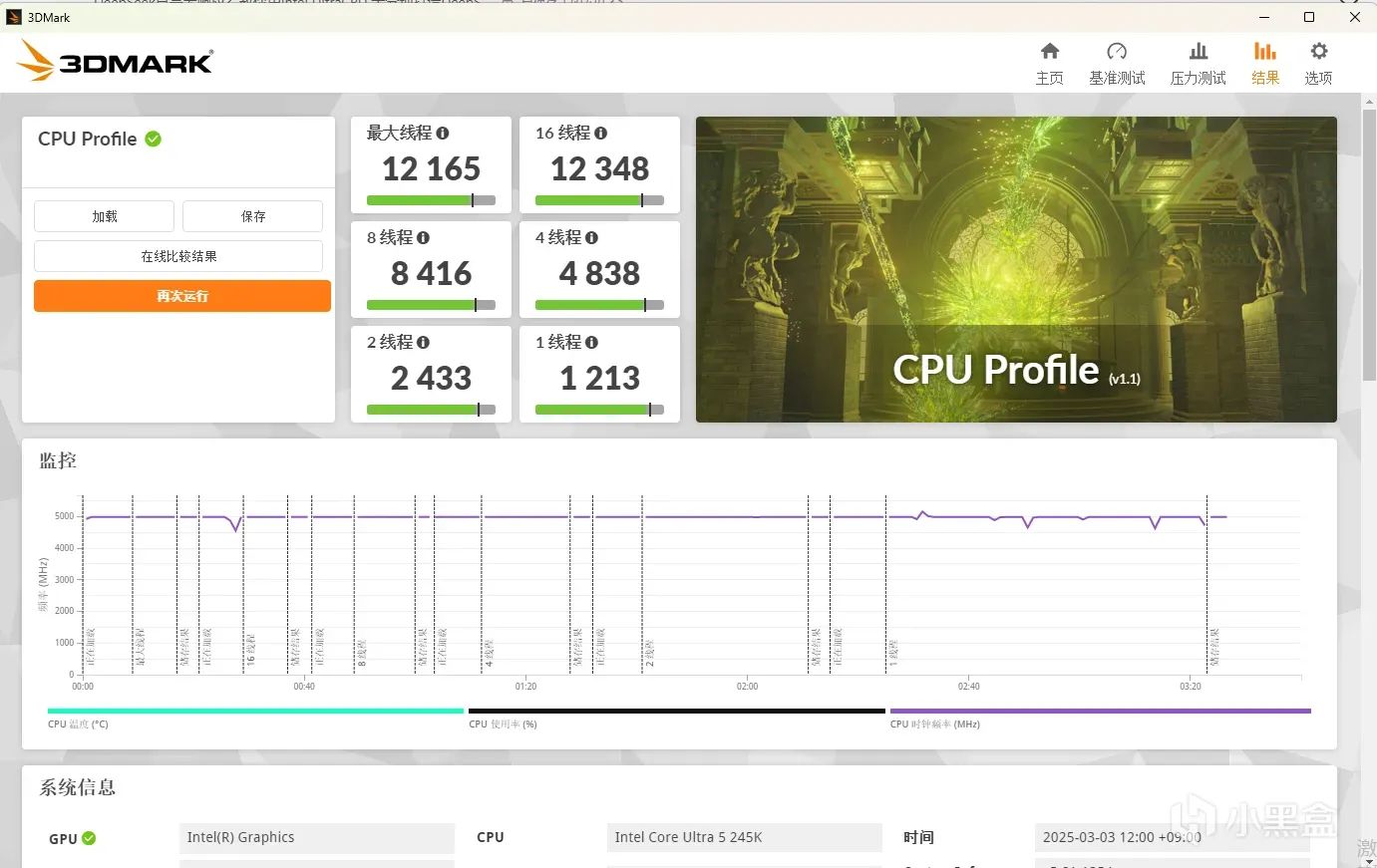

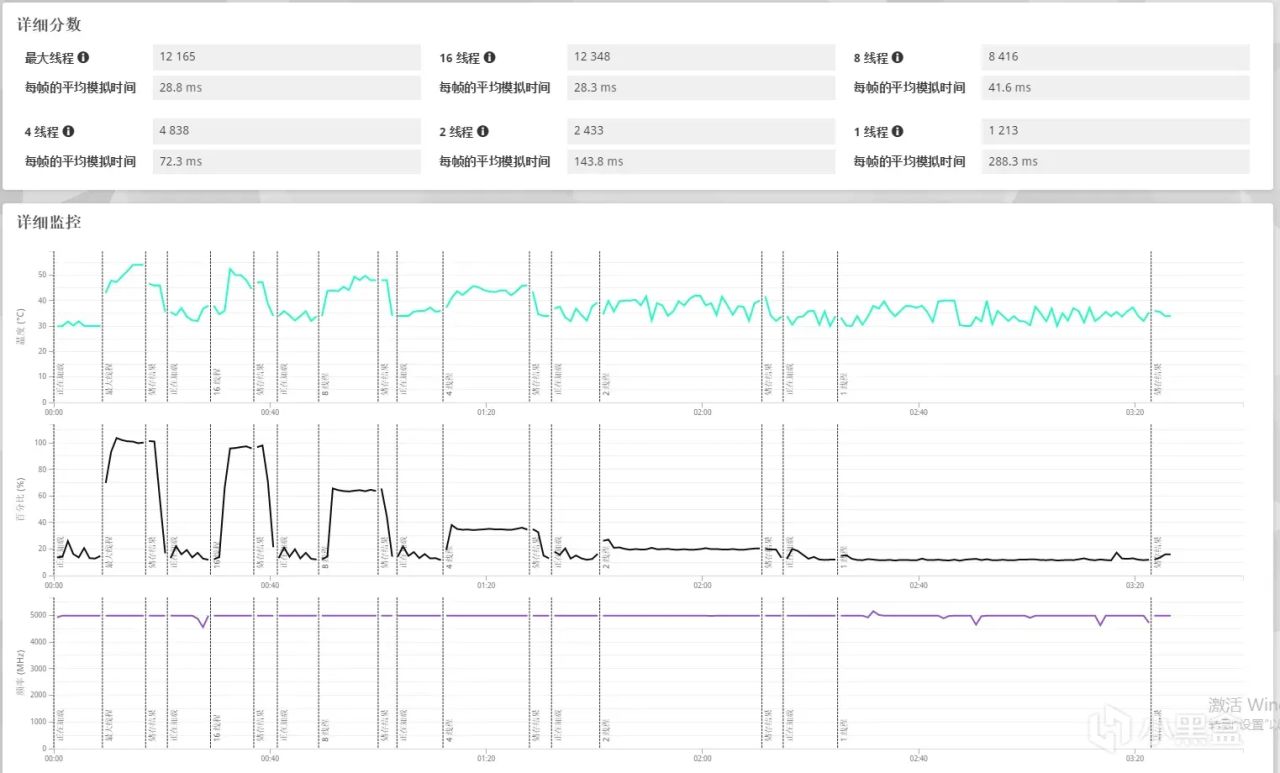

1. 3DMark CPU性能測試

3DMark CPU Profile 是一種新的CPU性能測試方法。與只給出一個總分不同,它能顯示CPU在使用不同數量的核心和線程時的表現如何變化。這個測試包括六個部分,可以幫助你瞭解CPU在各種情況下的性能,並進行比較。

這六個測試都用同樣的任務,只是改變使用的線程數。分數越高,說明CPU處理速度越快。

每個測試都是物理計算和自定義模擬的組合。爲了不讓顯卡性能影響結果,我們測量的是每幀的平均模擬時間,而不是幀率。然後把這個時間轉換成分數。

+ **核心**:是CPU的實際組成部分。核心越多,同時能做的工作就越多。

+ **線程**:是一種虛擬組件,負責給CPU分配任務。線程越多,可以同時處理的任務就越多。

在這次性能測試中,處理器展現了非常出色的單線程處理能力,其單線程分數達到了1213分,這一成績表明它在執行依賴於單一核心性能的任務時表現優異。此外,當利用到處理器的所有核心和線程進行多任務並行處理時,該處理器的最大線程得分更是高達12348分,這說明它不僅在單線程應用上有着卓越的表現,在需要高度並行計算的場景下也能提供強大的支持,滿足複雜應用場景的需求。這樣的性能指標對於追求高效能計算體驗的用戶來說無疑是個好消息。

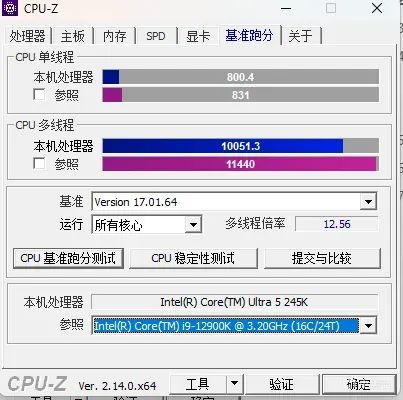

2. CPU-Z性能跑分

在CPU-Z測試中,用戶可以全面地評估其計算機處理器的性能和規格。用戶還可以對自己電腦上的CPU執行一系列標準化測試,以量化其單核與多核處理能力。

在單核心性能方面,Ultra245K獲得了800分,這表明它在處理依賴於單個核心性能的任務時表現優異。而更令人印象深刻的是其多核心得分達到了10051分,這一成績幾乎與曾經被譽爲頂級處理器之一的12900K持平。這樣的結果不僅證明了Ultra245K在多任務處理能力上的強大,也標誌着它能夠爲用戶提供流暢、高效的計算體驗,無論是對於日常使用還是更爲複雜的專業應用環境而言都是如此。

核顯性能評估

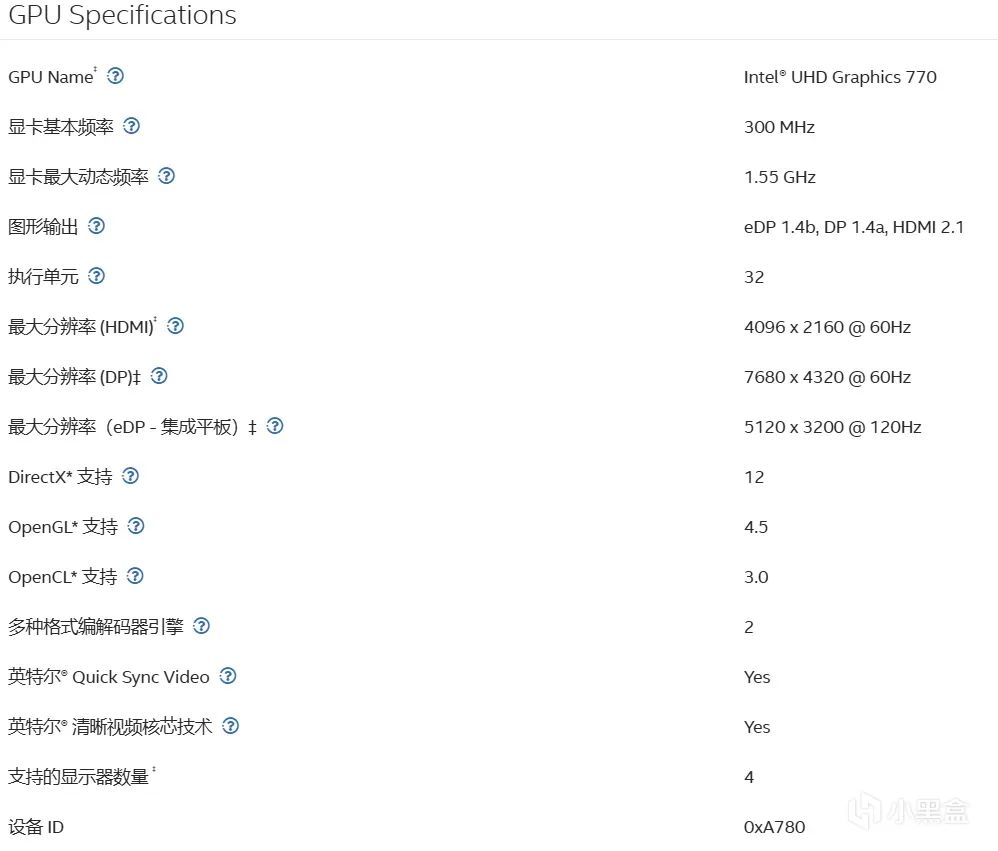

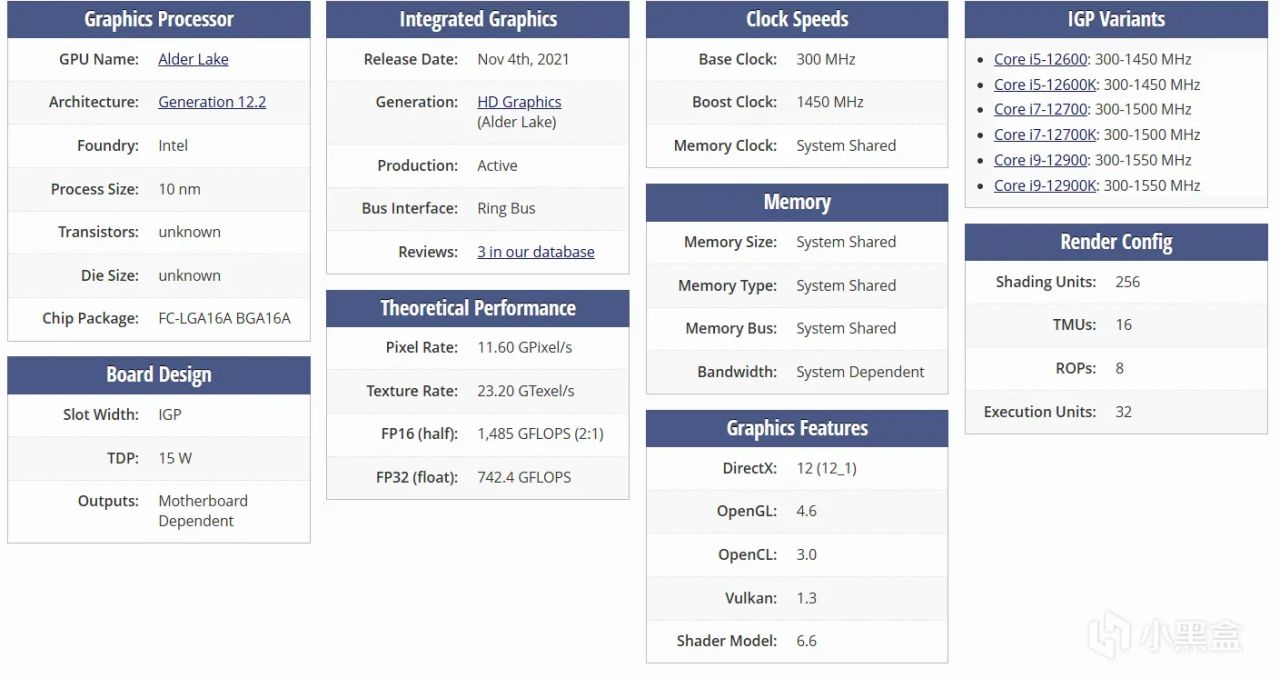

14代CPU帶有的核顯爲HD770,其具體參數如下所示

在覈顯方面,245K相比與14代的HD770升級到了4Xe-core的新式核顯

新的Xe核顯架構性能上實現了明顯的突破,具備4個1.9GHz的Xecore,最大支持8K 60hz編解碼,其AI算力在int8精度下達到8TOPS,較前代HD770核顯的3TOPS實現2.6倍性能躍升。更值得關注的是,該核顯支持英特爾DLBoost深度學習加速技術,當大模型推理採用int4量化部署時,算力爲16TOPS。真正達到大模型端側部署的10TOPS算力門檻要求(以瑞芯微RK3588的NPU算力爲基準)。通過硬件級低精度加速能力,Ultra核顯爲本地化AI推理任務提供了更高效的運算支持。

依賴軟件安裝

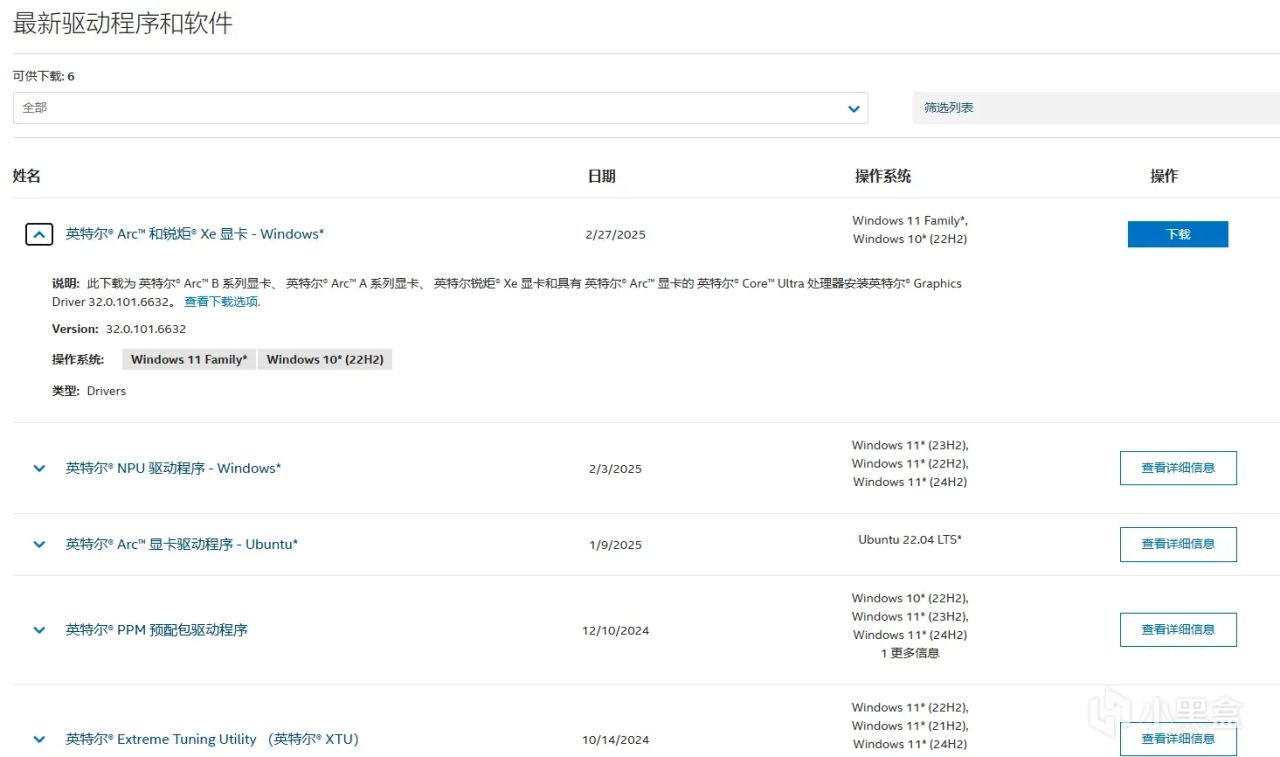

安裝IntelGPU驅動

前往鏈接下載最新的官網GPU驅動

[https://www.intel.cn/content/www/cn/zh/products/sku/241067/intel-core-ultra-5-processor-245k-24m-cache-up-to-5-20-ghz/downloads.html](https://www.intel.cn/content/www/cn/zh/products/sku/241067/intel-core-ultra-5-processor-245k-24m-cache-up-to-5-20-ghz/downloads.html)

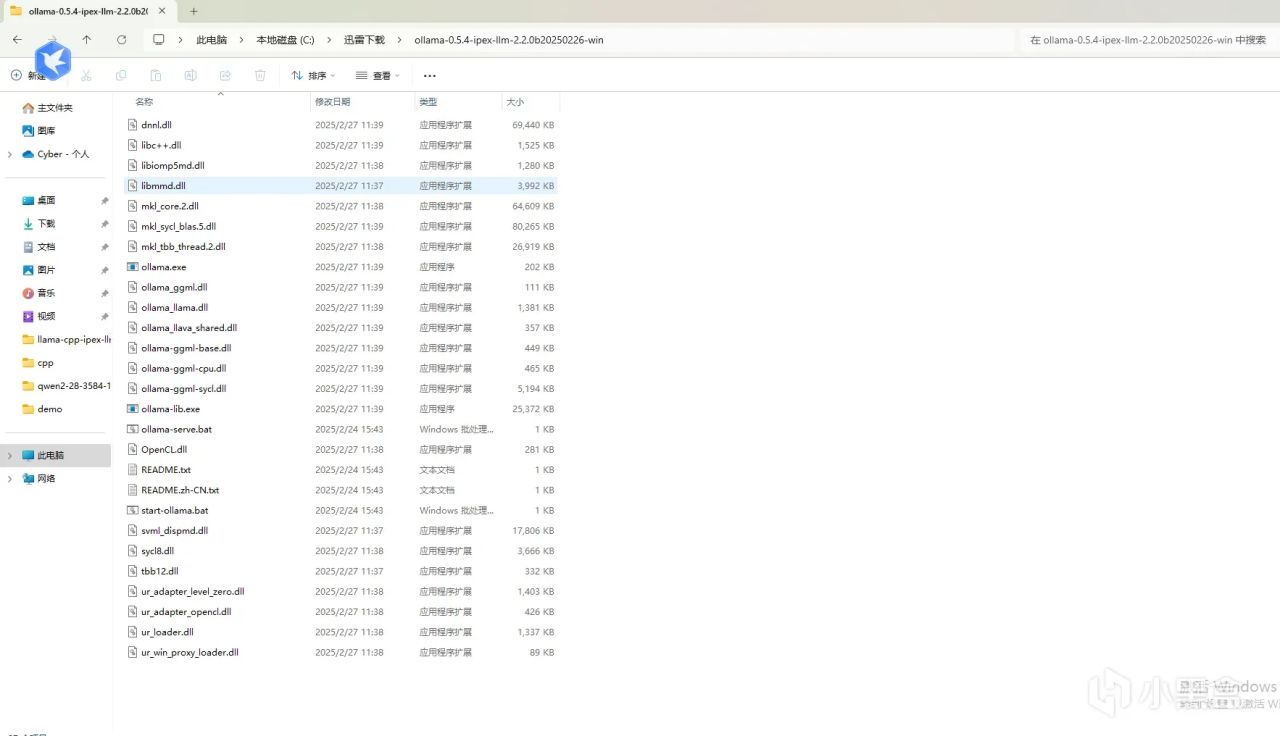

下載ipex-llm ollama部署包

ipex-llm是intel官方的開源大模型項目,支持使用intelgpu進行高性能大模型推理和訓練微調。

從該鏈接進入intel ipex-llm官方頁面[https://github.com/intel/ipex-llm/releases/tag/v2.2.0-nightly](https://github.com/intel/ipex-llm/releases/tag/v2.2.0-nightly)

下載[llama-cpp-ipex-llm-2.2.0b20250224-win-npu.zip](https://github.com/intel/ipex-llm/releases/download/v2.2.0-nightly/llama-cpp-ipex-llm-2.2.0b20250224-win-npu.zip)到本地解壓即可

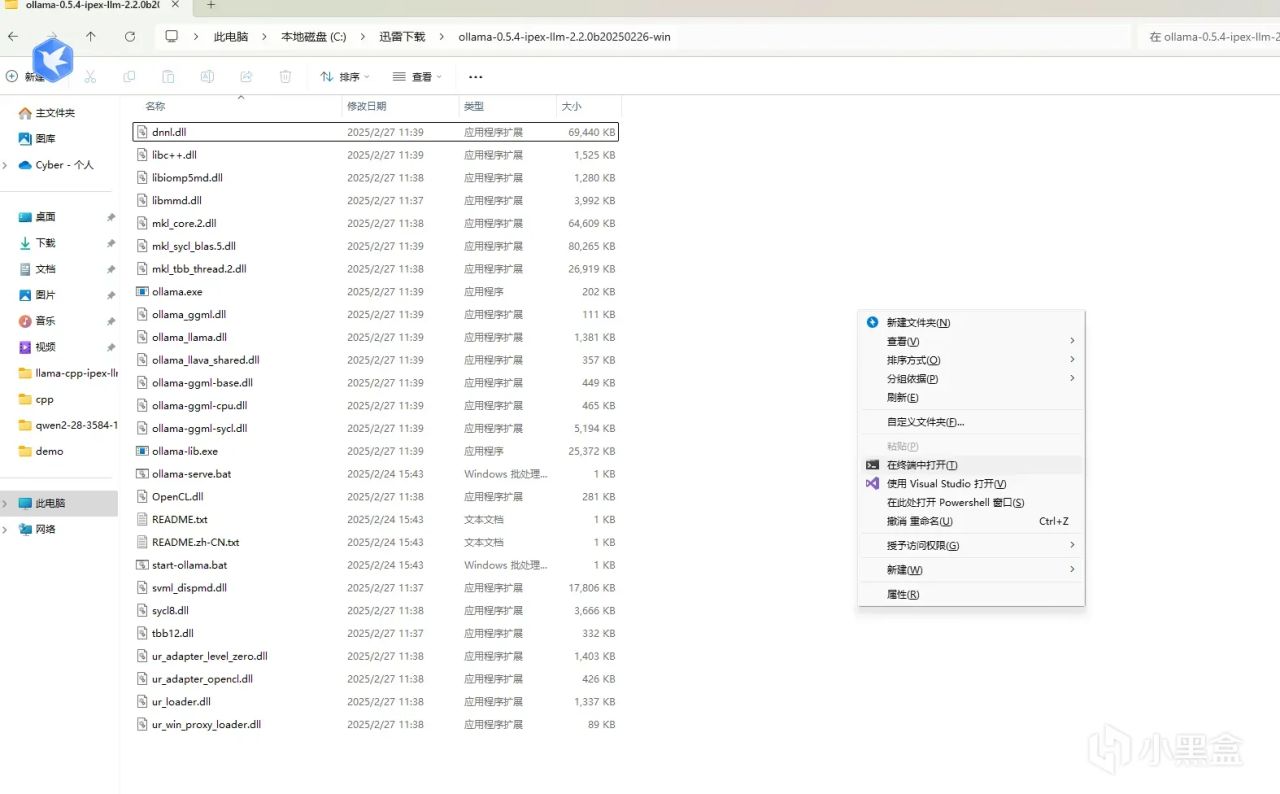

Ollama啓動和模型部署

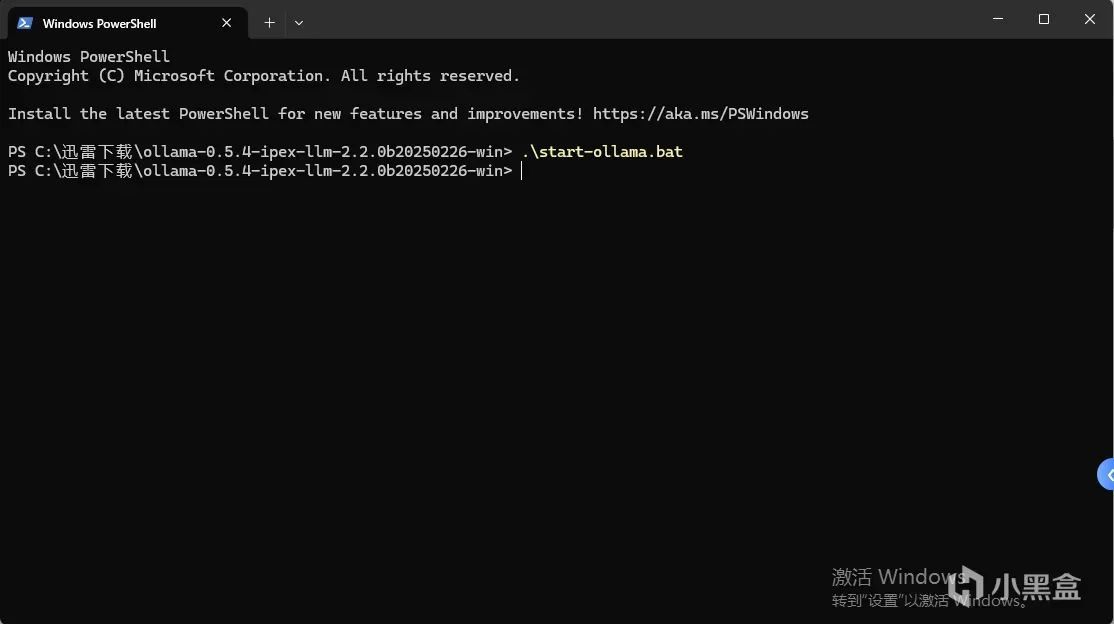

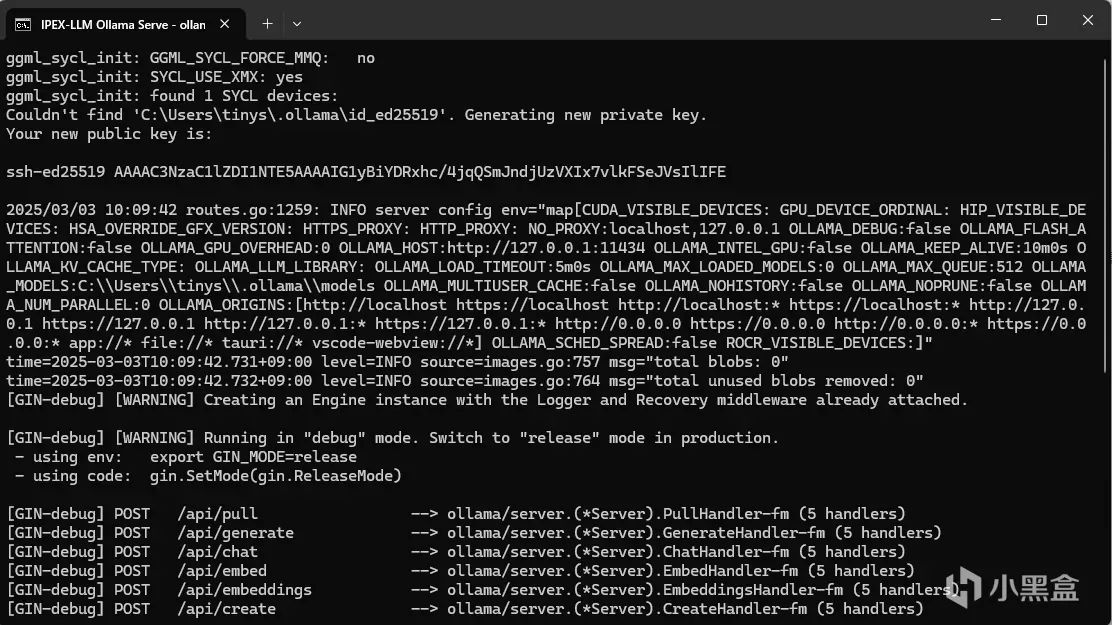

在文件夾中按住`Shift`+右鍵,選擇在終端中打開

在命令行中輸入

```plain

./start-ollama.bat

```

然後就會彈出來一個跑了很多日誌的命令行窗口,這就代表ollama啓動成功了,記得不要關閉他

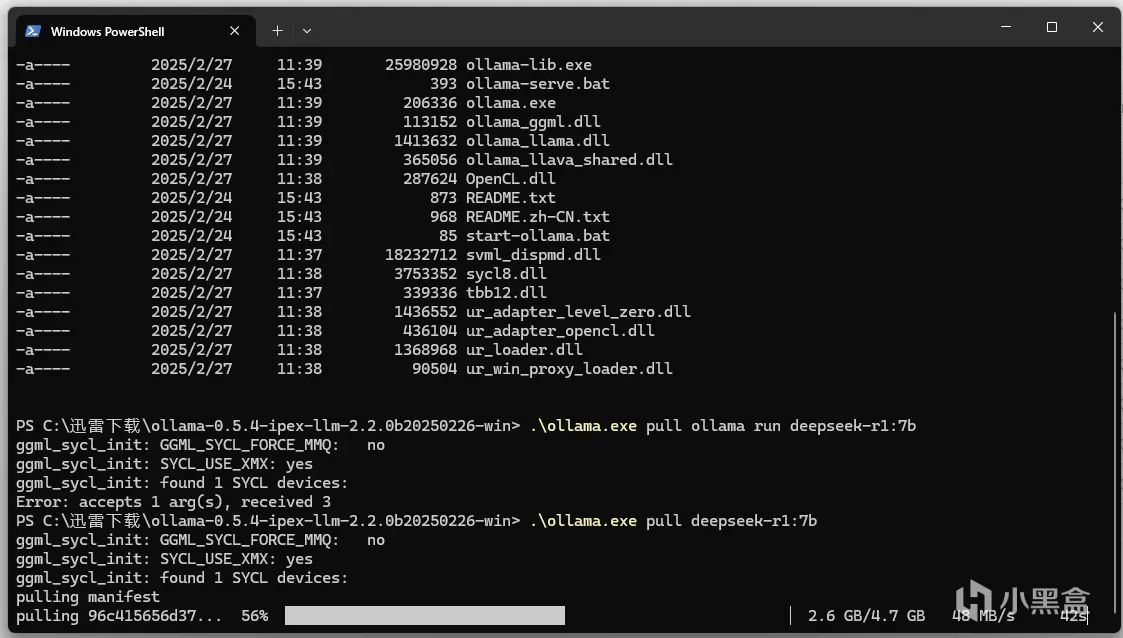

然後在前面我們自己打開的命令行窗口裏面輸入如下命令

```plain

.\ollama.exe pull deepseek-r1:7b

```

等待模型加載完畢即可

啓動大模型前端

等待模型下載完成後,我們的ollama已經在後臺就緒了,這時候需要我們就可以和大模型進行對話了,但是命令行的方式比較複雜並且不美觀,所以這裏我們直接使用一鍵安裝的軟件`AnythingLLM`來使用剛纔我們搭建好的Ollama服務。

前往AnythingLLM官網:[AnythingLLM | The all-in-one AI application for everyone](https://anythingllm.com/)

下載並安裝

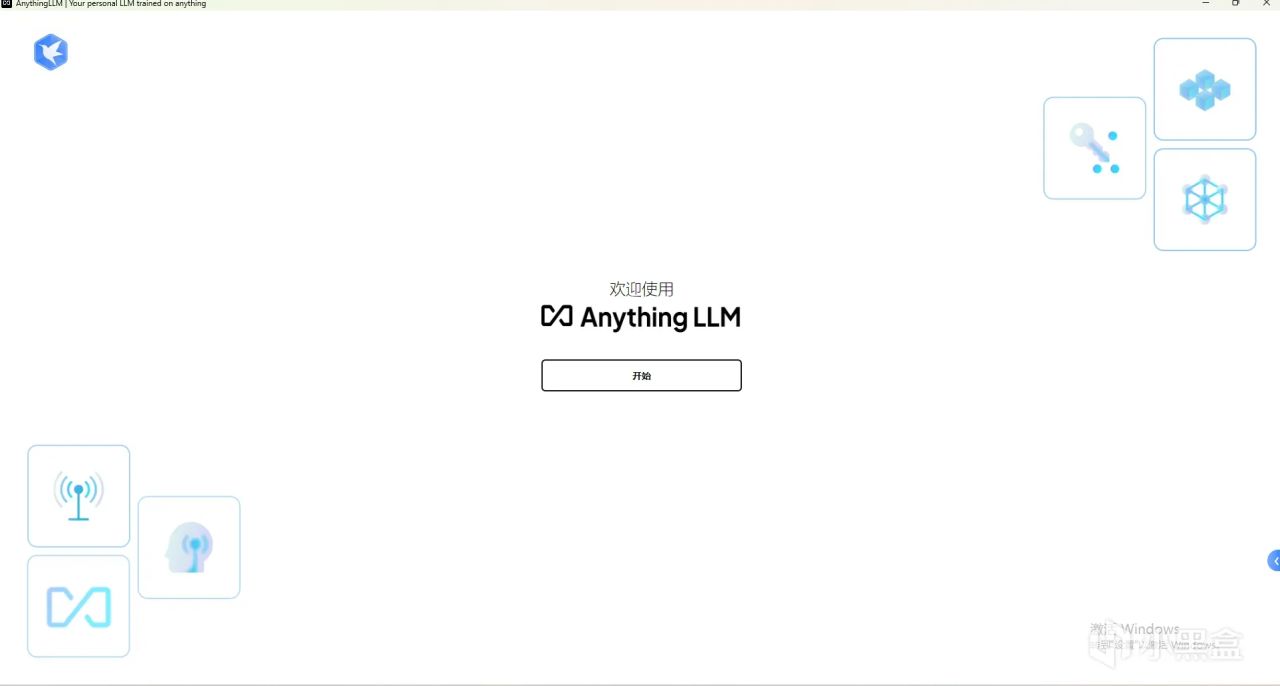

安裝完成後啓動軟件

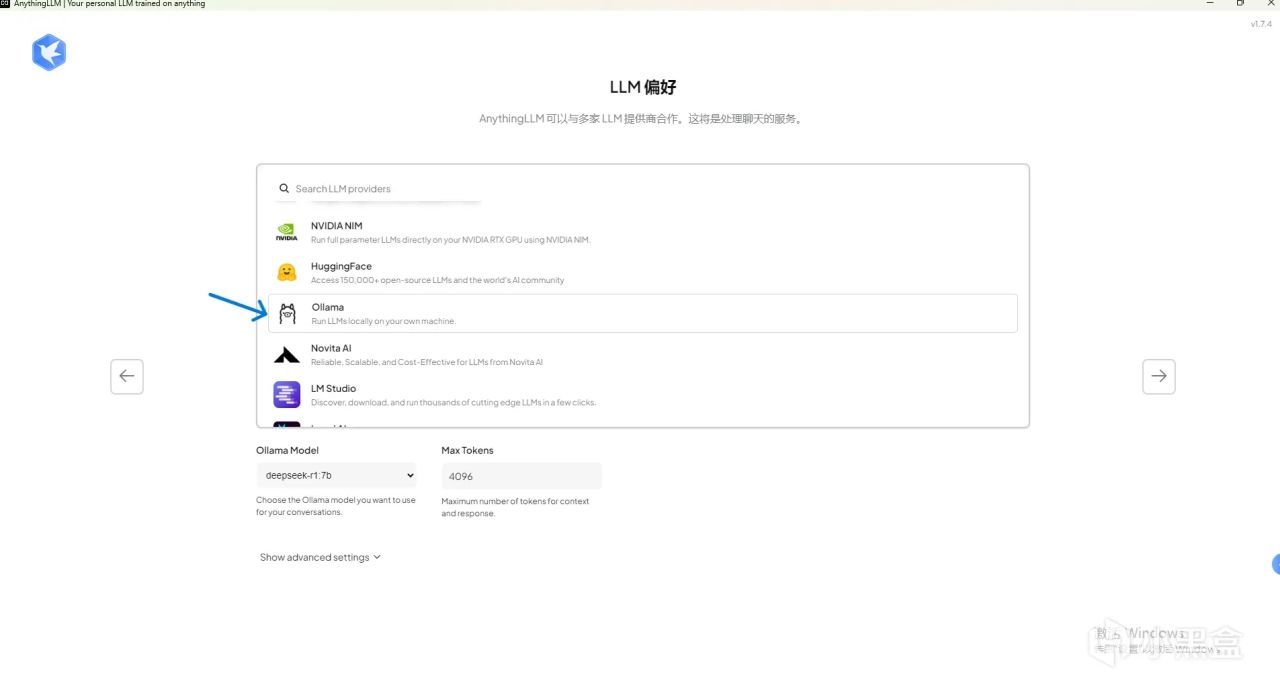

模型選擇位置我們選擇ollama

可以看到我們的DeepSeekR1已經被識別出來了.

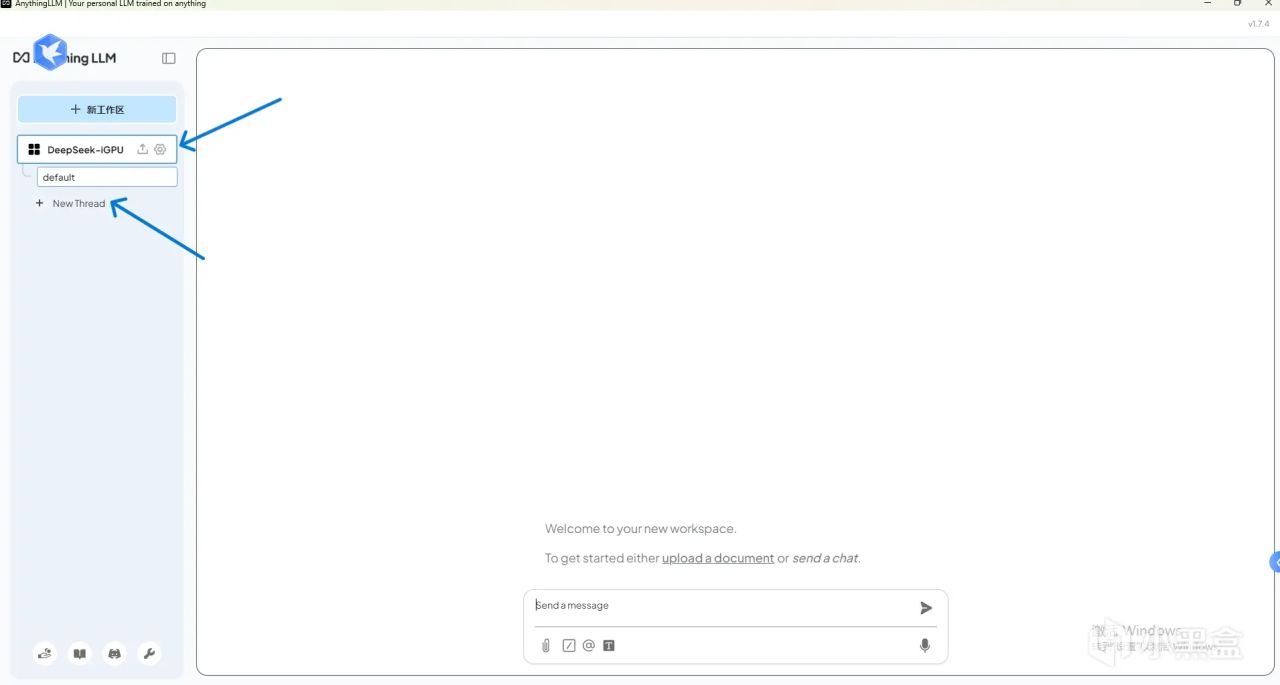

後面創建工作區,這個隨便取名,我就直接寫了DeepSeek-iGPU

首先點擊選中我們的工作區,然後選中`NewThread`開啓新對話即可

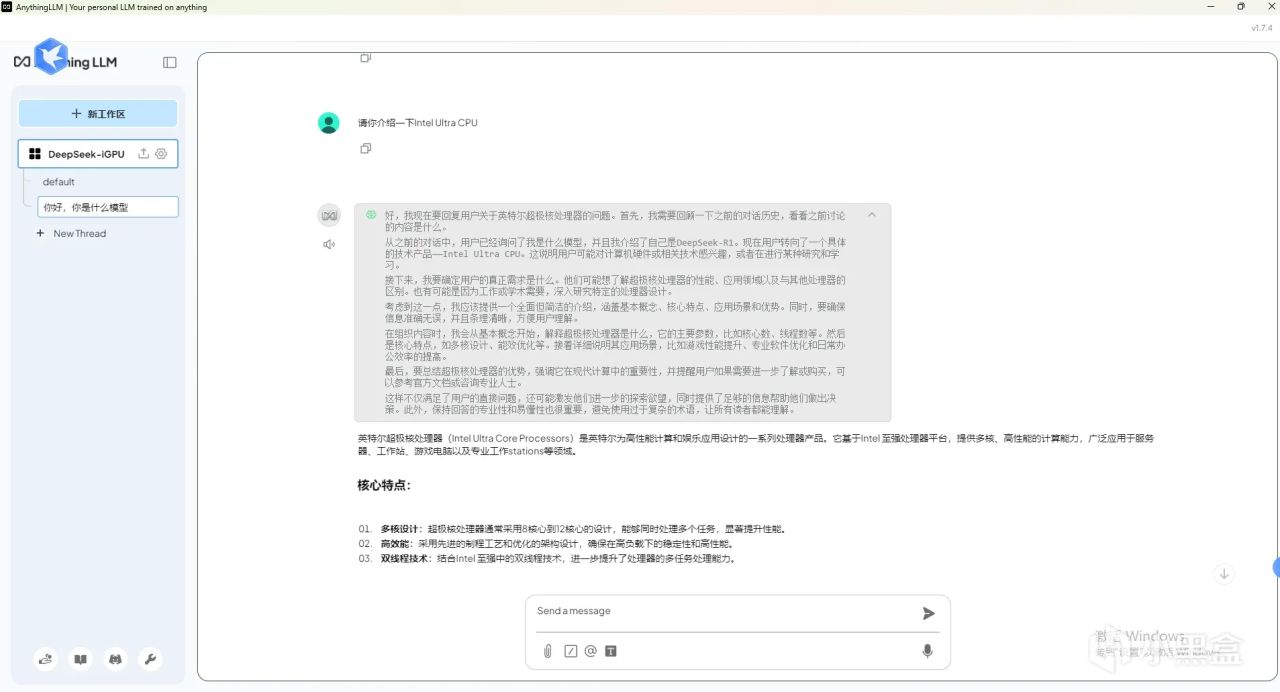

我們先讓DeepSeek介紹一下Ultra系列處理器吧

可以看到,DeepSeekR1的思考鏈也能夠正常工作。

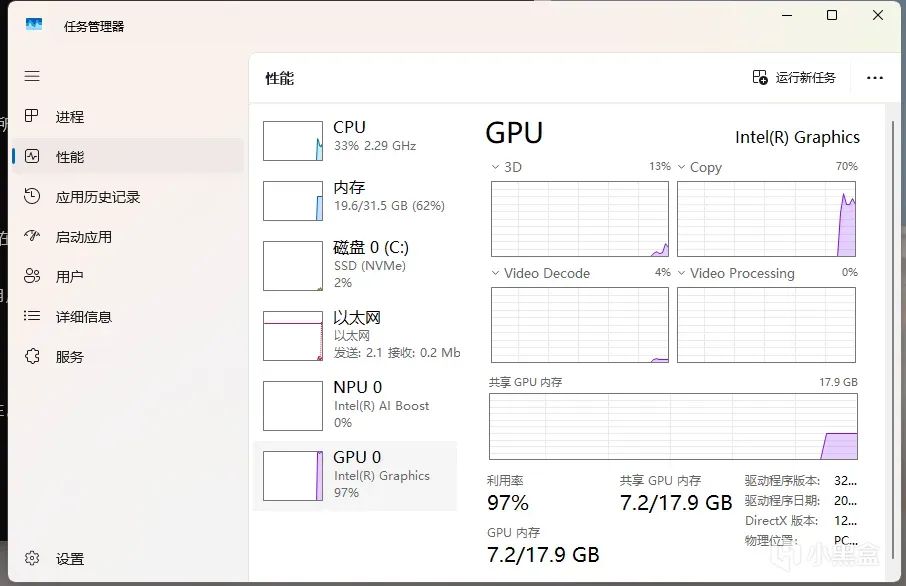

開啓任務管理器可以看到,核顯基本上已經被榨乾,並且使用了7.2G的主機內存

模型的token生成速率(近似每秒生成的單詞數量)大約爲10token/s,對於個人使用的話已經可以做到流暢的對話了!

Ultra 245K另一大亮點就是引入了NPU。本文其實一開始想用NPU進行部署。目前,intel ipex-llm給出了測試階段的npu大模型部署工具,因爲Ultra245K的NPU太新了(相比Ultra1和UltraV),NPU部署過程遇到了若干bug,目前這些Bug已經提交到Intel ipex-llm中。按照ipex-llm目前高速的更新速度來說,大約下個月應該就能使用NPU進行模型的推理與部署,這可以進一步解放核顯,同時構建一臺更高性能的AI工作站。

更多遊戲資訊請關註:電玩幫遊戲資訊專區

電玩幫圖文攻略 www.vgover.com