有點小衆,屬於整活,可能盒友用不上。

前言

現在放在你面前的是,兩塊來自Mellanox HPE 544+FLR QSFP 40G的四萬兆網卡。

現在又放在你面前的是,兩塊來自宏碁掠奪者PCIE 4.0 4T的滿速無外緩盤。

那麼它們之間能碰撞出什麼樣的火花呢?

我們這一次整個大活,我們將會以這兩塊40G的網卡和這兩塊4T的PCIE 4.0盤來組裝一臺NAS出來。

前排提示,本期純整活,方案實現並不完美,且並不具備日常使用價值。

選擇硬件

全閃NAS中最核心的三個部件就是硬盤、網卡、主板。

網卡是對外連接的上限,硬盤的速度是內部傳輸的上限,主板是承載這整個系統的基板,兼容性和通道的速度都由它決定。整個系統就像是一個水泵,網卡就像是出水口,出水口的直徑限制水的流量,硬盤就像水泵電機,轉速高低決定水流速度,主板就像整個水泵外殼。

硬盤選擇

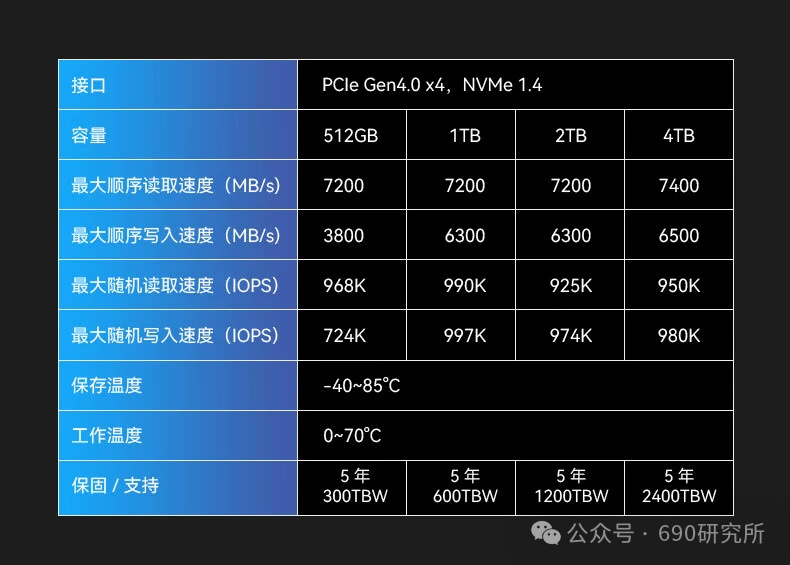

這一次選用這的兩塊4T的PCIe4.0盤是來自宏碁掠奪者GM7,是一塊非常經典的滿速無外緩盤。

官方標稱順序讀取速度能到7400MB/s,順序寫入速度能有6500MB/s,950K IOPS的隨機讀取性能,標稱性能可以說是無外緩盤的頂級性能了。

我們比較關心的售後方面是五年質保,寫入量保修4T版本給到了2400TBW,五年質保和TBW以先到者爲準,這樣的售後服務還是非常讓人放心的。

包裝依舊是宏碁掠奪者的經典包裝,黑色啞光搭配亮面的硬盤圖片,質感非常不錯。

正面是自帶的石墨烯散熱片,能有效導熱,也可以搭配金屬散熱片使用。

ps:盤自帶的散熱片被撕過所以有點褶皺。

硬盤背面就是常規的序列號信息。

正面四顆粒,沒有獨立緩存。所有芯片集中在正面,這一點非常不錯,散熱效率比較高,設備兼容性更加好了,適合筆記本用戶和主機用戶,當然也適合臺式機用戶,可以搭配主板自帶金屬馬甲散熱了,無需考慮像雙貼盤那樣背面顆粒散熱不佳的情況。

主控芯片是來自國產聯芸科技的MAP1602主控,是聯芸的第三代主控產品,採用了12nm製程工藝,無緩存設計,全盤模擬SLC策略。

顆粒是來自長江存儲的232層TLC顆粒——X3 9070,可以做到單顆1T容量,實現了高達 2400MT / s 的IO 速度,性能十分強悍。

那接下來上機看一下這塊硬盤能有怎麼樣的表現吧!

硬盤測試

首先測試單塊硬盤的測試平臺不是我們最終實現NAS的平臺。

測試平臺:零刻SER7 MAX這次換演員了(bushi,純屬是不想拆機器了)

CPU:R7 7840HS

系統盤和測試盤都跑在PCIe4.0 x4通道上,並且做好了散熱。

CDI

首先是檢測硬盤SMART信息的crystal disk info軟件,可以看到硬盤的傳輸模式正確跑在PCIe4.0 x4通道上,待機溫度在43度。

CDM

速度測試第一項是crystal disk mark軟件,1G測試,可以看到讀寫速度分別是7122MB/s和6503MB/s,最影響日常使用的4K隨機讀寫性能更是突破了1000K,順序讀取是927K IOPS,順序寫入高達1030K IOPS。

AS SSD

AS SSD 的策略與CDM不同,其測試成績更貼近日常使用一些,不過也是娛樂軟件,CDM追求標準的峯值性能,AS SSD每次測試波動會比較大。

順序讀寫能達到5668MB/s和5491MB/s,最終獲得了8568的好成績,可以用作同價位固態參考。

AIDA64 Disk Benchmark

接下來是最漫長且“殘酷”AIDA64的寫入測試,通過這個軟件測試,可以很直觀地看到這塊無外緩盤的模擬SLC緩存大小,和整體寫入速度,以及主控的策略。

只能說不愧是4T盤呀,測試足足跑了一個半小時才全部寫入完成。

從全盤寫入的情況來看,宏碁掠奪者GM7 4T呈現三段式寫入,SLC緩存的大小在1070G左右,緩內的讀寫的速度在5200MB/s左右,對於4T盤來說,將近30%的SLC緩存還是挺大的了。

當SLC緩存寫完的時候,進入到TLC直寫階段,速度還能保持在2400MB/s左右,但是TLC直寫階段非常短,當寫入到2T的時候就會進入到第三段,速度保持在840MB/s左右。

URWTEST

在最貼近實際使用的URWTEST測試中,宏碁掠奪者GM7緩內的速度實際能有3000到3500 MB/s,性能還是非常不錯的。

可是,硬盤實際緩內寫入還是隻有3000+ MB/s,根本沒辦法到達40G網卡的極限性能呀,那要怎麼辦?

我們準備直接給這兩塊盤組建

RAID0陣列

,我就不信跑不上40G!

網卡選擇

我們爲什麼會選擇賣螺絲核心的HP544+FLR網卡?

因爲便宜,實在是太便宜了。

40G的網卡只需要40塊錢,隔壁Intel的82599芯片的萬兆光口卡還要100塊錢呢,40G的網卡已經是白菜價格了。

HP544+FLR QSFP網卡是邁絡思CX3PRO芯片,同時支持10G、40G或56G的以太網和

InfiniBand。

以太網方面支持

IEEE Std 802.3ae 10 Gb 以太網

IEEE Std 802.3ba 40 Gb 以太網

IEEE Std 802.3ad 鏈路聚合

IEEE Std 802.3az 高能效以太網

IEEE Std 802.1Q/.1P VLAN 標記和優先級

IEEE Std 802.1Qau 擁塞通知

IEEE Std 802.1Qbg

IEEE P802.1Qaz D0.2 ETS

IEEE P802.1Qbb D1.0 基於優先級的流量控制

IEEE 1588v2

巨型幀支持 (9600B)

INFINIBAND支持

符合 IBTA 規範 1.2.1

基於硬件的擁塞控制

1600 萬 I/O 信道

256 至 4K 字節 MTU,1G 字節消息

兼容性

PCI EXPRESS 接口

符合 PCIe Base 3.0 標準,兼容 1.1 和 2.0

2.5、5.0 或 8.0GT/s 鏈路速率 x8

自動協商爲 x8、x4、x2 或 x1

支持 MSI/MSI-X 機制

但是這個網卡比較特殊的是,插槽並不是正常的PCIE插槽。這個也不是什麼問題,現在已經有這個KCORES開源的轉接板,有能力的可以自己打板,成品的轉接板也都不貴,一塊轉接板加擋板也就二十來塊錢。

我們這兩張網卡淘寶入手150,圖個省心。

別看40G網卡這麼快的速率,其實這已經是被淘汰的產品了,在服務器產品中,用於雲計算、超算、數據中心、人工智能等使用場景,主流IB網卡早已經到100G以上,甚至200G、400G的速率。

主板選擇

NAS端主板

因爲考慮到要使用PCIE 4.0固態做陣列,所以對主板有硬性要求,首先要支持PCIE 4.0,且有兩個4.0 M.2槽位,考慮到544FLR這個網卡在這兩代最新平臺上兼容性,有些平臺插在南橋出來的PCIE通道上並不能兼容,所以主板的選擇比較慎重。

我們目前手上能有兩條PCIe 4.0 M2插槽的主板,符合條件的只有三塊,分別是技嘉Z790 GAMING X AX,微星MSI H670戰斧導彈,爾英B760M幻翼。

雖然這三塊規格上差別很大,但是對於網卡來說,本質上大差不差,除了直連CPU的X16插槽,底下南橋走的PCIE通道都是不足X8的,且不兼容,這真是太難受了。

最後兜兜轉轉還是用了爾英B760這塊,插在直連CPU的X16插槽上。別問爲啥不用Z790這些上直連CPU的X16插槽,問就是不兼容(悲)

爾英這塊板子雖然性價比非常高,做工也不錯,但是這個散熱馬甲真是有點難受,會擋散熱器,無奈只能拆掉了,好在cpu是12100,毫無供電壓力。

客戶端主板

客戶端的平臺搭配反而更加讓我頭疼了,其實要雙向實現40G的傳輸速度,客戶端主板的需求其實和NAS端是一樣的,都需要雙M2插槽,且是4.0通道,這就很難受了。

我就只能退而求其次選擇了這塊微星的X299 Raider,之前玩四通道內存工作站平臺剩下的主板,閒置了好久,這一次再次請出山。

但是可惜的是X299是PCIE 3.0平臺,並不能用4.0盤來組陣列了,肯定會對最終實現有所限制的,但是目前也沒辦法了,要麼買張PCIE拆分卡,插滿六塊3.0固態來組陣列強制堆滿速度,要麼換主板。

不過最後我們選擇的是兩塊PCIe 3.0的盤組成RAID0,這樣也能變相實現。

選擇系統

要跑滿40G網卡的速度,我們需要用到一項技術——RDMA,

遠程直接內存訪問(即RDMA)

是一種直接內存訪問技術,它將數據直接從一臺計算機的內存傳輸到另一臺計算機,無需雙方操作系統的介入。RDMA最早在Infiniband傳輸網絡上實現,後來業界廠家把RDMA移植到傳統Ethernet以太網上,降低了RDMA的使用成本,推動RDMA技術普及。

RDMA本身只是一種概念,具體實現不同廠商都有自己的實現方式,目前市場上能見到的RDMA產品可以分爲三類:

1.

InfiniBand——“無限帶寬”,其誕生的目的是爲了取代PCI總線,後續轉向到計算機集羣互聯方向和存儲設備的連接,而Mellanox這家以色列芯片公司(現在是被英偉達收購)是目前InfiniBand市場的絕對領導者。

InfiniBand通過交換機在節點之間直接創建一個專用的受保護通道,並通過InfiniBand適配器管理和執行的遠程直接內存訪問(RDMA)和發送/接收卸載,方便了數據和消息的移動。適配器一端通過PCI Express(PCIe)接口連接到CPU,另一端通過InfiniBand網絡端口連接到InfiniBand子網。與其他網絡通信協議相比,這提供了明顯的優勢,包括更高的帶寬、更低的延遲和增強的可擴展性。

2.

RDMA最早在Infiniband傳輸網絡上實現,後來業界廠家把RDMA移植到傳統Ethernet以太網上,降低了RDMA的使用成本,推動RDMA技術普及。在Ethernet以太網上,根據協議棧融合度的差異,分爲iWARP和RoCE兩種技術,而RoCE又包括RoCEv1和RoCEv2兩個版本(RoCEv2的最大改進是支持IP路由)。

RoCE是爲了降低IB部署的成本而推出,實際上的核心就是把IB的包架在通用Ethernet上發出去,因此對於RoCE,實際上它的二層包頭已經是普通以太網的包頭。

(圖片來自互聯網)

在傳統TCP/IP中,來自網卡的數據,先拷貝到核心內存,然後再拷貝到應用存儲空間,或從應用空間將數據拷貝到核心內存,再經由網卡發送到Internet。這種I/O操作方式,需要經過核心內存的轉換。它增加了數據流傳輸路徑的長度,增加了CPU的負擔,也增加了傳輸延遲。

RDMA其實是充當了一個”沒有中間商賺差價”的角色,”像是某二手車交易網”。

落實到系統內功能,考慮到我們是要當作NAS使用,SMB功能是繞不開的。

Windows Server 包含一個稱爲 SMB 直通的功能,用來支持使用具有遠程直接內存存取 (RDMA) 功能的網絡適配器。 使用 RDMA 的網絡適配器能夠全速運行, 延遲時間非常低,CPU 使用量非常少。 對於 Hyper-V 或 Microsoft SQL Server 等工作負載,這讓遠程文件服務器如同本地存儲一樣。

在Windows server上SMB直通是自動配置的。

所以NAS端的系統我們就選擇Windows server 2022版本,那客戶端要選擇什麼呢?這是個比較難選擇的問題。

日常使用Windows server 2022肯定是不合適,那難搞的驅動和繁瑣的登錄,足夠勸退我了,最終還是在X299上部署了Windows 10專業工作站版,Windows專業工作站版支持SMB直通功能(單相直通)。

兩端都支持SMB直通,性能上會更好。

實際測試

首先我們跑一下陣列的峯值性能,我很好奇,雙PCIe4.0的滿速盤組成RAID 0會是怎樣恐怖的存在。

雙PCIe4.0的陣列固態速度真是牛逼啊!順序讀寫速度基本上是單盤的兩倍。

其實我們從測試結果可以看出,raid0確實能大大增加順序讀寫性能,但是4k性能並不會有明顯提升,甚至會有所下降,因爲軟raid0存儲一份數據要拆成兩份存到兩個盤中,那速度自然是相當快的,但是4K的小文件並不能拆開,同時因爲是軟raid陣列,CPU還要負責尋址,所以4k性能上不會有太大提升。

首先我們在Windows server端創建好用戶,創建好共享,並確保兩端都開啓SMB直通,然後開始測速,這裏總共112G的文件,拷貝到NAS裏,實際的速度能有2.3G每秒左右,之前測試的時候最高能跑到3G每秒,實際跑下來並不能完全跑滿40G網卡的速度,主要是被X299這套的3.0硬盤限制了發揮,如果再來兩條宏碁掠奪者的4.0的盤,跑滿40G的局域網應該是沒有什麼問題的。

總結

這次折騰雖然有點點遺憾,但是也算是完成了全閃40G NAS的組建,傳輸的速度還是很不錯的!

這次也算是第一次接觸這種PCIe4.0的大容量固態盤,價格貌似也是大容量固態盤中比較低的,這用來大容量存儲還是很不錯的選擇。

好啦,以上就是本篇文章的全部內容啦~

原創不易 喜歡的小夥伴可以點個贊

讓我們下篇文章

再見~

更多遊戲資訊請關註:電玩幫遊戲資訊專區

電玩幫圖文攻略 www.vgover.com