大家好,我是加勒比考斯。

Stable Diffusion是一款基於人工智能的圖像生成工具,它能夠根據用戶提供的文本描述生成相應的圖像。這款工具使用了先進的深度學習算法,特別適合設計師、藝術家以及任何對AI藝術感興趣的人。本教程將帶領你瞭解Stable Diffusion的基本概念,並指導你完成從安裝到生成圖像的整個過程。

Stable Diffusion最大的特徵,就是由於其開源的特性,可以在電腦本地上離線運行,生成速度快,且對硬件要求相對較低。這是AI繪畫第一次能在可以在消費級顯卡上運行,任何人都可以下載模型並生成自己的圖像。另外,相比較於midjourney等封閉系統的AI繪圖軟件,Stable Diffusion強大的自由度(自定義、個性化)也受到很多業內人士的追捧。

生成的圖片只要用對配置,基本均可達到個人預期。

Stable Diffusion的主要功能:

文本轉圖像生成:最常見和最基礎的功能。Stable Diffusion 會根據文本提示生成圖像。

圖像轉圖像生成:使用輸入圖像和文本提示,您可以根據輸入圖像創建新圖像。典型的案例是使用草圖和合適的提示。

創作圖形、插圖和徽標:使用一系列提示,可以創建各種風格的插圖、圖形和徽標。

圖像編輯和修正:可以使用 Stable Diffusion 來編輯和修正照片。例如,可以修復舊照片、移除圖片中的對象、更改主體特徵以及向圖片添加新元素。

視頻創作:使用 GitHub 中的 Deforum 等功能,可以藉助 Stable Diffusion 創作短視頻片段和動畫。另一種應用是爲電影添加不同的風格。 還可以通過營造運動印象(例如流水)來爲照片製作動畫。

需要注意的是,Stable Diffusion對電腦的配置是有要求的。

以上是最低的要求,但是真的以這個配置來,肯定生成效率極低。

隨着年初40系Super顯卡發佈,無論是AIGC玩家與遊戲玩家都已經瞄準4070TiSuper了,這張卡作爲4070Ti的升級版本,加量不加價,相對來說性價比最高,同時也是2K遊戲隨便跑、4K遊戲守門員級別的存在。今天,我們使用英特爾14700K,金百達DDR5 6800 24GB*2、技嘉Z7907冰雕X以及喬思伯的魚缸機箱來試試AIGC效果咋樣。

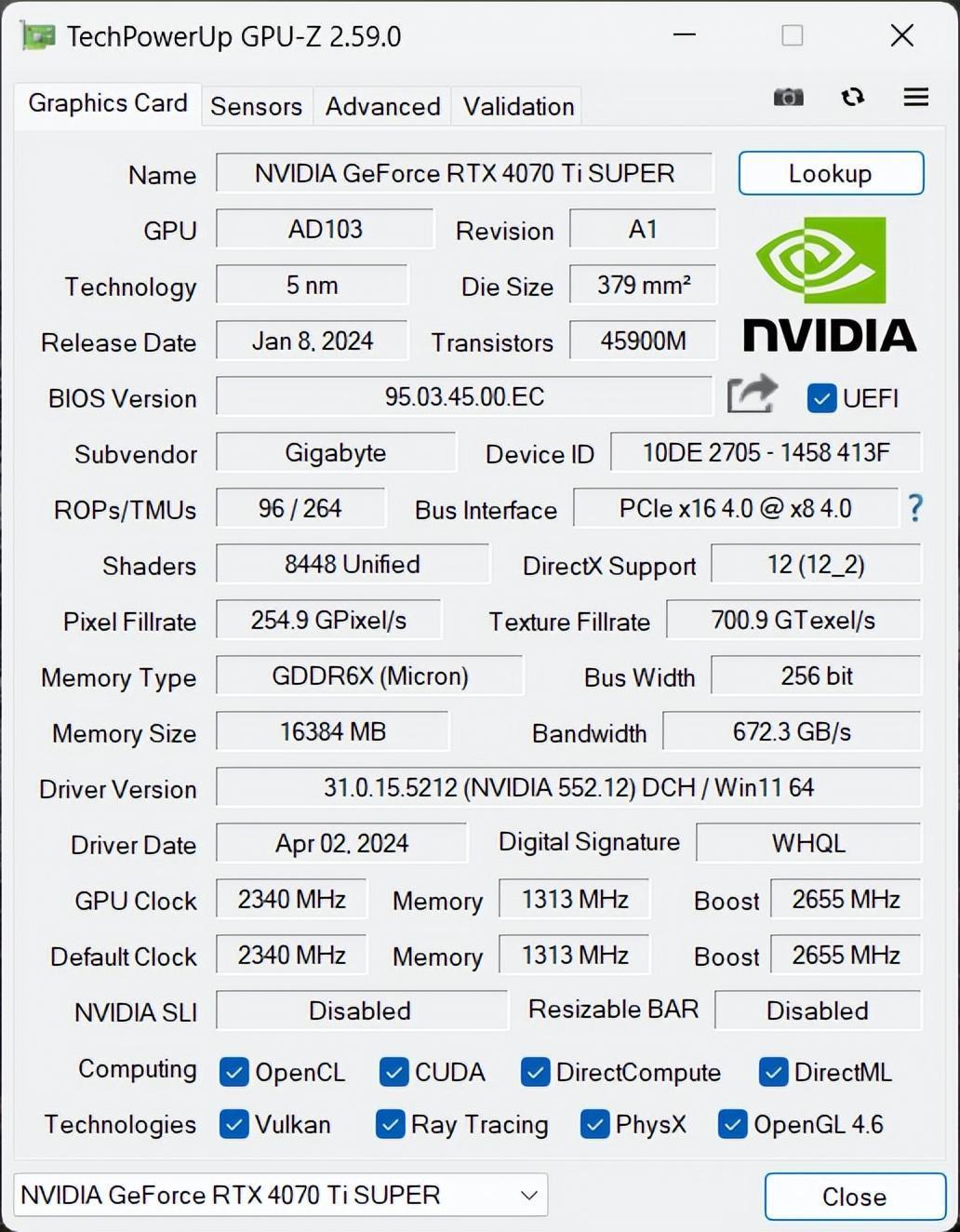

顯卡我用的是技嘉雪鷹RTX 4070 Ti SUPER AERO OC 16G,由技嘉(GIGABYTE)公司生產,基於NVIDIA的Ampere架構。這款顯卡專爲追求極致遊戲體驗和高效能需求的用戶設計,提供了強大的圖形處理能力。它擁有大量的CUDA核心,能夠處理複雜的圖形任務和並行計算任務。同時配備了16GB GDDR6顯存,能夠輕鬆應對高分辨率和大型遊戲場景的數據需求。

在覈心性能方面,技嘉RTX 4070 Ti SUPER雪鷹顯卡搭載了AD103-275芯片以及16GB GDDR6X顯存的超實力組合。得益於全新升級的架構,該顯卡在4nm工藝下相近的面積內實現了約3倍晶體管的集成度,擁有66個SM單元、8448個CUDA核心,並能支持最新的SER和DLSS 3。因此,無論是在4K分辨率遊戲還是常規內容創作負載方面,這款顯卡都能輕鬆應對。顯存方面,技嘉RTX 4070 Ti SUPER雪鷹顯卡採用了源自美光的GDDR6X顯存,共計8顆,每顆容量爲2GB,總顯存容量達到16GB,顯存帶寬高達672GB/s。

根據GPU-Z,我們可以看到技嘉RTX 4070 Ti SUPER雪鷹的核心Bosst頻率達到了2655MHz。

它的散熱採用了技嘉獨特的雪鷹散熱技術,包括大面積散熱片和三個90mm的大直徑風扇,支持正逆轉設計和智能啓停功能,有效提升散熱效率並降低噪音,確保顯卡在高負載下也能保持低溫運行。

緊接着是性能優化部分,AERO OC版本意味着這款顯卡經過了技嘉的特殊超頻處理,相比標準版能夠提供更高的性能。技嘉提供了自家的超頻軟件,允許用戶根據需要調整顯卡的性能設置,以達到最佳的性能和穩定性平衡。

除了上述規格之外,技嘉RTX 4070 Ti SUPER雪鷹基於Ada Lovelace架構還具備以下關鍵特性:

1.採用TSMC 4N工藝,晶體管集成度更高,規模更強,能耗比更優異;

2.Ada架構採用了第三代光線追蹤模塊,具備Opacity Micromap、DMME以及SER等新技術,大幅度提升了光線追蹤計算效率;

3.採用了第四代AI張量核心,擁有支持AV1格式的第八代NVENC編碼器;

4.支持全新的DLSS 3.5技術,在DLSS 2的基礎上增加了Frame Generation幀生成功能,能夠在DLSS 2的基礎上將遊戲幀率再翻倍,並且不影響整體畫質,同時還增加了增強光追遊戲畫質的光線重建功能;

5.面向設計師羣體進行了相關升級,包括Studio、Racer RTX以及RTX REMIX;

我之前一直以爲Stable Diffusion很難安裝,但自己嘗試了一次之後才發現,原來本地安裝其實非常簡單。

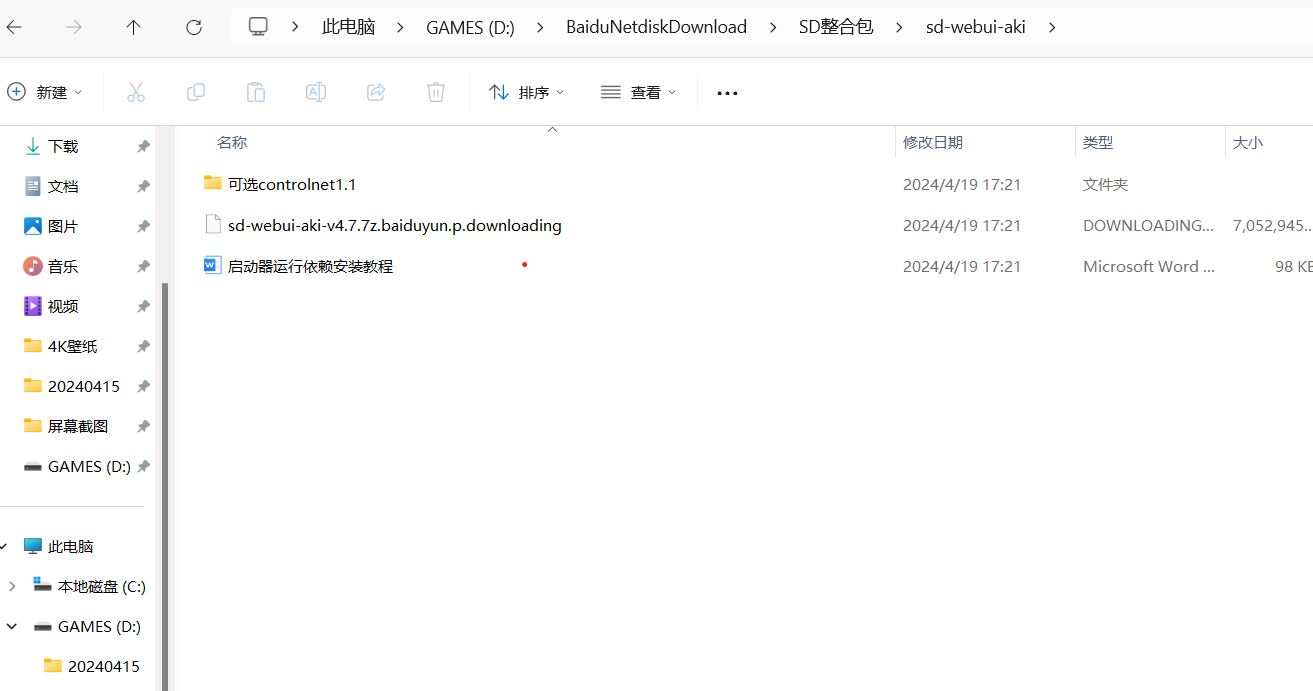

下載安裝包我選擇的是秋葉大神開發的Stable Diffusion整合包,只需要把整合包下載到電腦上,就可以一鍵安裝了。

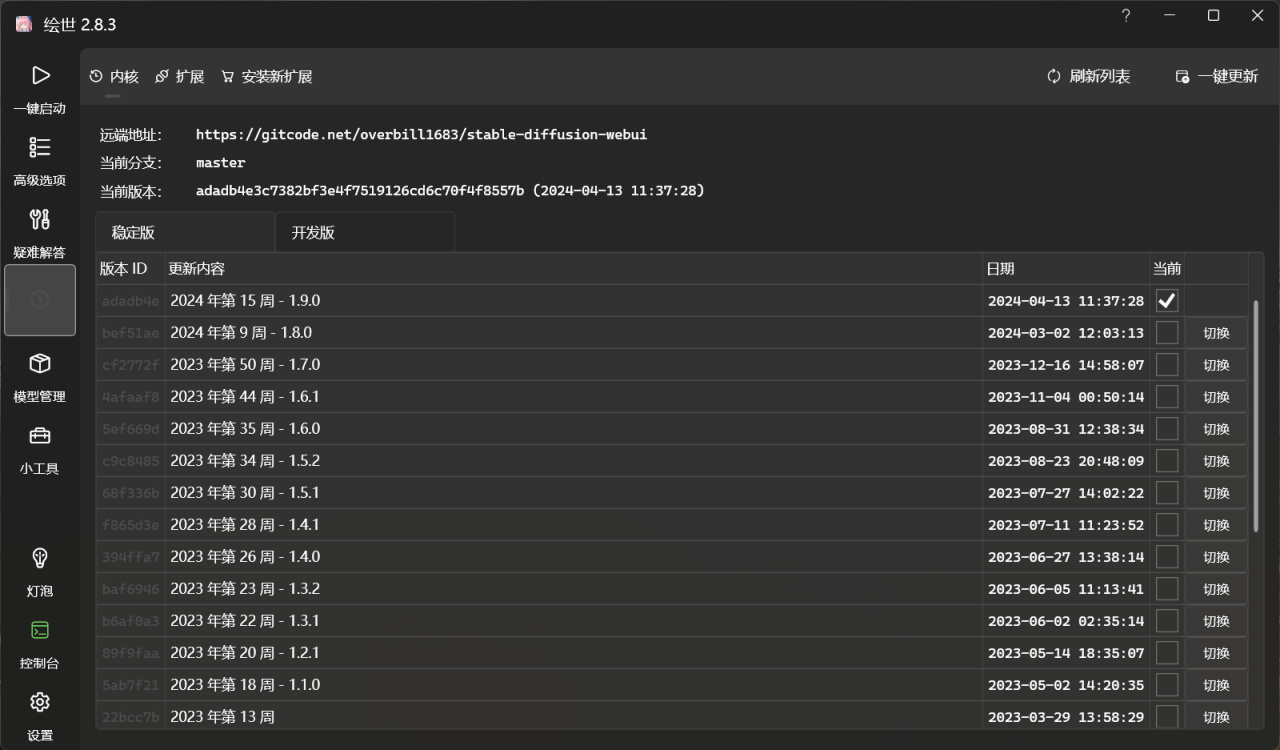

解壓完文件,點擊繪世啓動器,接下來就可以全自動安裝了。安裝過程中,需要先安裝啓動器所需要的環境,整個過程大概只需要幾分鐘即可完成。

安裝完成之後,可以把繪世啓動器發送到桌面快捷方式,這樣下次直接點擊快捷方式就可以一鍵啓動Stable Diffusion了。

注意的是,如果有安裝老版本的Stable Diffusion,可以選擇版本管理,可以一鍵更新到最新版本。

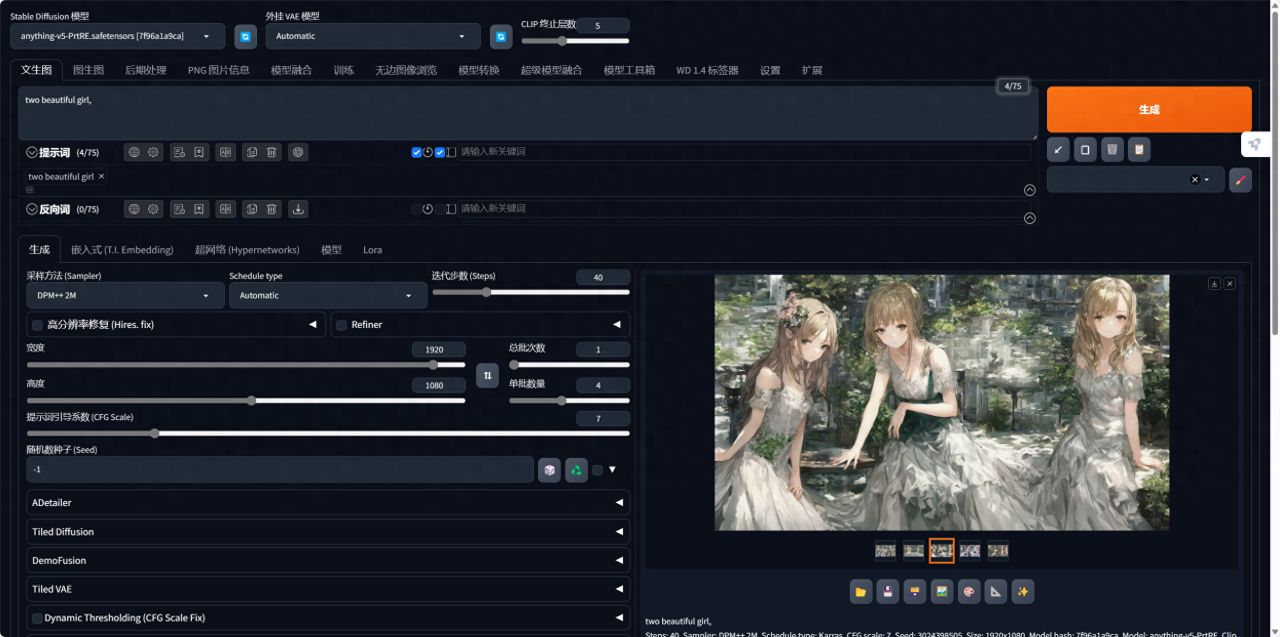

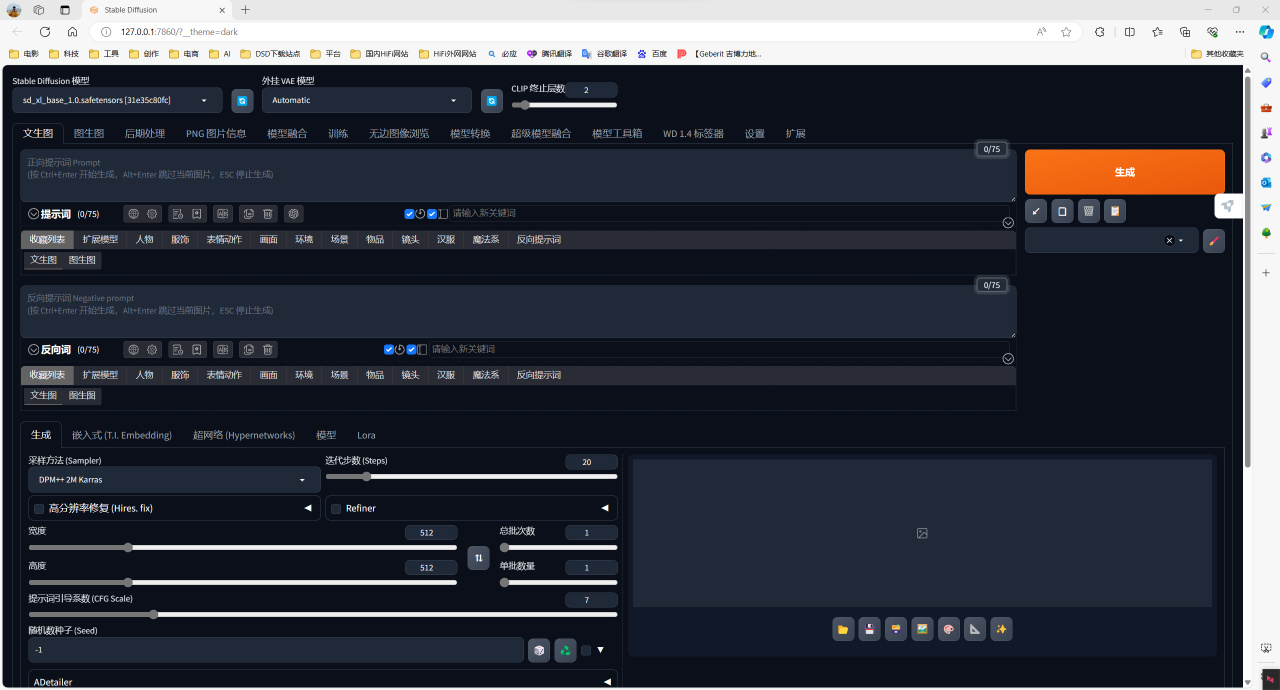

點擊一鍵啓動,會自動在瀏覽器當中打開一個網頁版的UI頁面。這個頁面就是我們的操作檯了,接下來就可以在裏面愉快地進行AI繪畫了。

秋葉大神的整合包裏包含了anyting-V5模型在內的幾個基本的模型,但是沒有最新的SDXL模型,因此我單獨下載了SDXL模型,只需要存儲到整合包文件夾的 models/Stable-diffusion

目錄內,重新啓動即可一鍵加載。

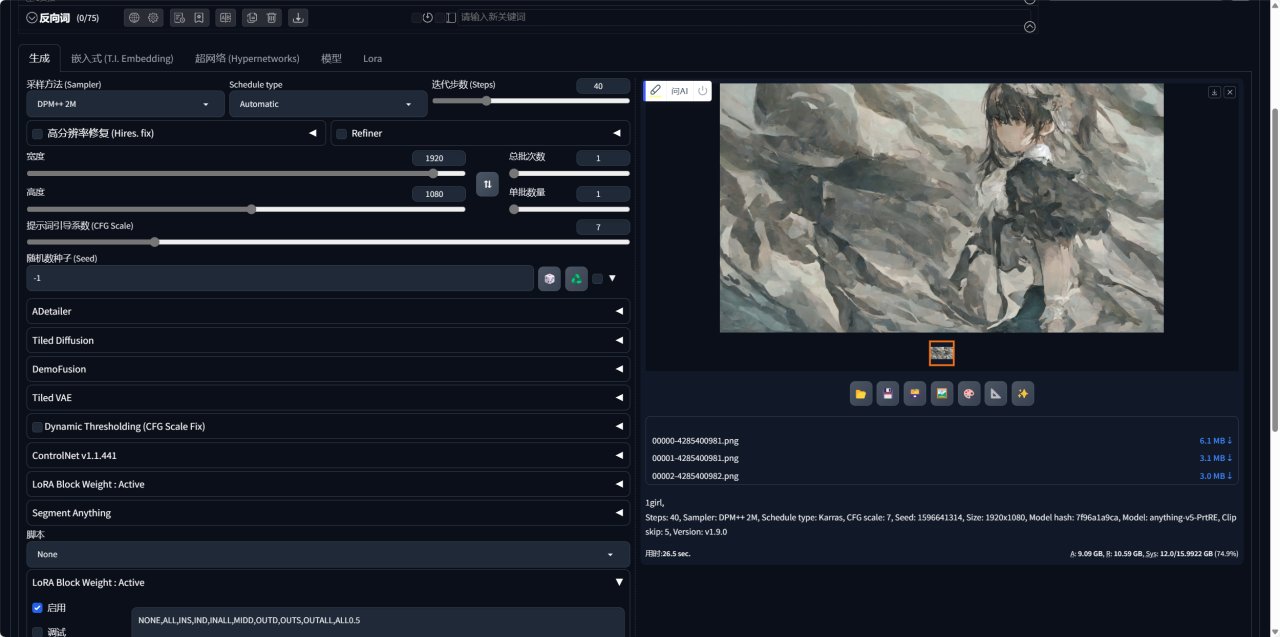

Stable Diffusion 的關鍵就是在於設置【提示詞】和【負向提示詞】,AI 會根據提示詞去匹配模型庫中的案例,進而渲染生成特定的圖片。我先嚐試了「1gril」的簡單提示詞,分辨率調整爲1920*1080,迭代步數爲40,可以看到單張耗時在 26.5秒。

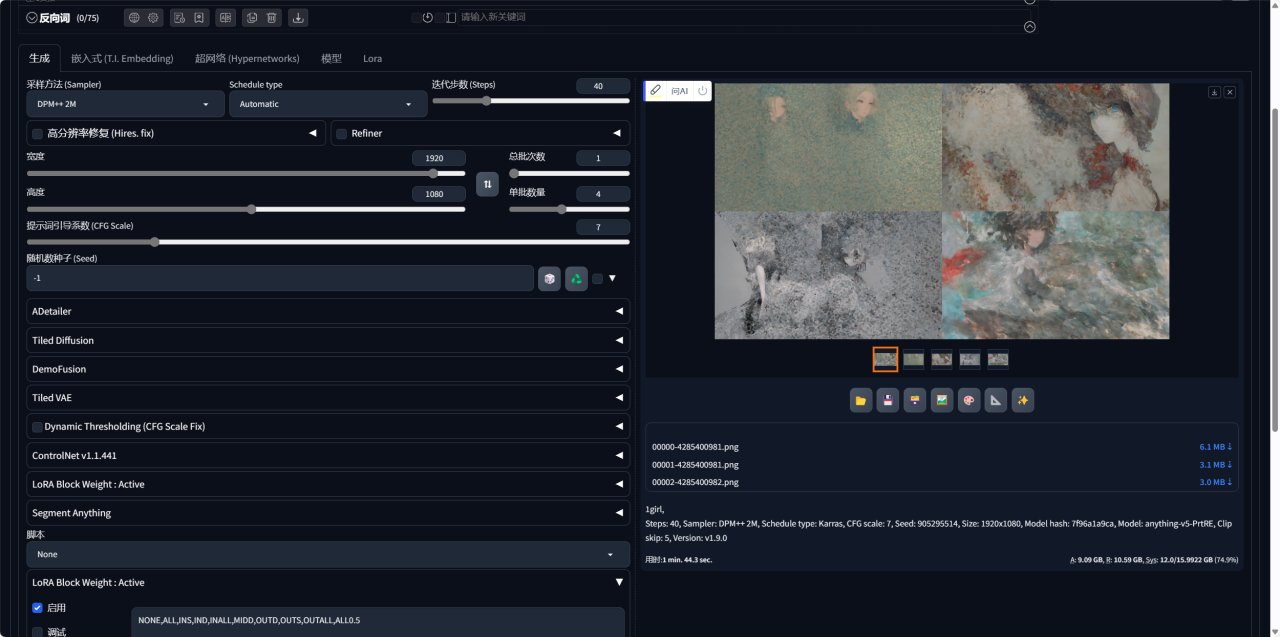

我嘗試了 1 批 4 張圖,平均單張耗時在26 秒,生成速度可以說相當快了。

實測生成一張圖的時間大概在5秒左右,同時生成4張圖,渲染所需時間也基本都在10秒鐘之內。

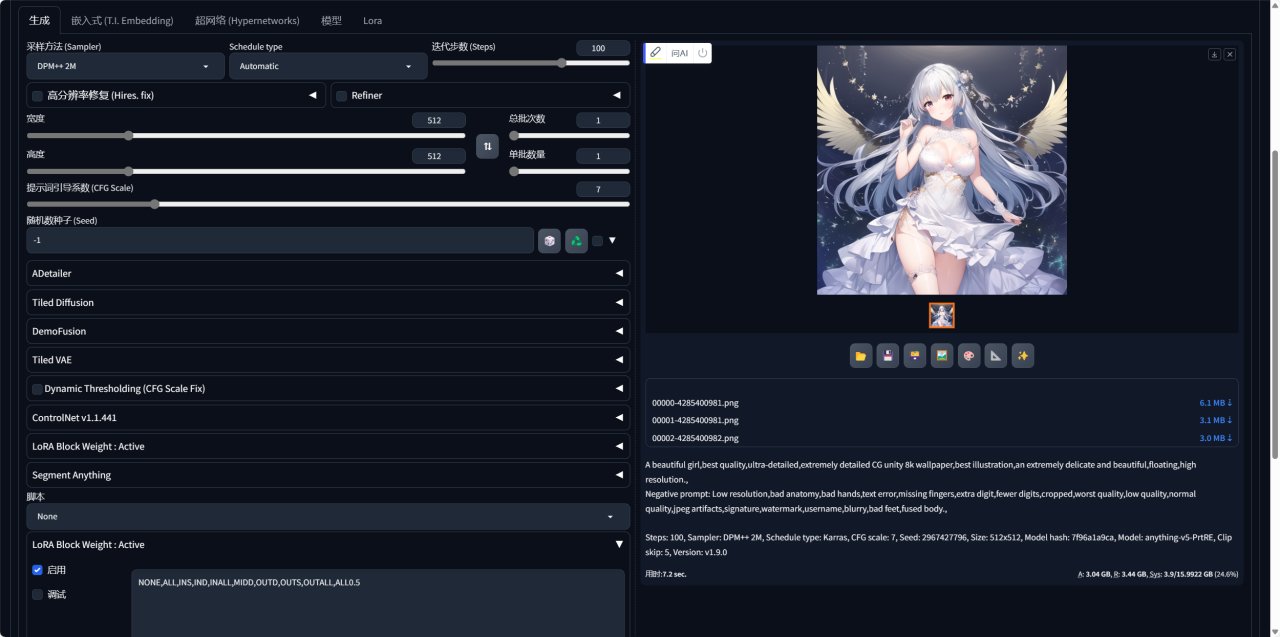

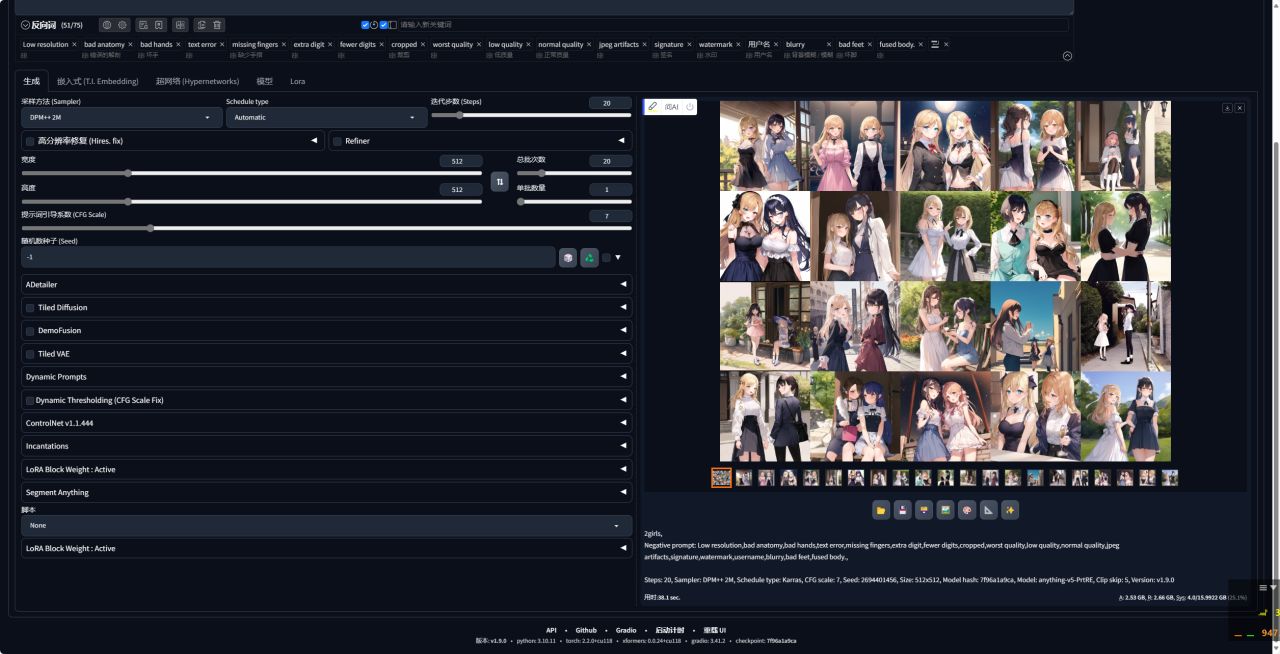

接下來我們上點難度,採用了 Omniinfer 的一套顯卡標準測試提示詞,將圖像長寬設置爲512×512,採樣迭代步數 100。

「提示詞」:A beautiful girl, best quality, ultra-detailed, extremely detailed CG unity 8k wallpaper, best illustration, an extremely delicate and beautiful, floating, high resolution.

「負向提示詞」: Low resolution, bad anatomy, bad hands, text error, missing fingers, extra digit, fewer digits, cropped, worst quality, low quality, normal quality, jpeg artifacts, signature, watermark, username, blurry, bad feet, fused body.

可以看到使用技嘉4070TiS單張耗時在7.2秒,嘗試了 1 批 4 張圖,平均單張耗時在4.4 秒,表現極佳。

當然如果想要生成更好的效果,還可以自己下載更多的預訓練模型,網上已經有很多大神調教好的相關模型, CivitAI(俗稱 C 站, )是業內比較成熟的一個 Stable Diffusion 模型社區,上面彙集了上千個模型,以及上萬張附帶提示詞的圖像,出圖效果非常哇塞,大家可以自己去挑選自己喜歡的模型。

CivitAI 上的模型主要分爲四類:Checkpoint、LoRA、Textual Inversion、Hypernetwork,通常情況 Checkpoint 模型搭配 LoRA 或 Textual Inversion 模型使用,可以獲得更好的出圖效果。

Checkpoint模型存放路徑:/stabl-diffusio-webui/models/Stable-diffusion

LoRA模型存放徑:/stable-diffusion-webui/models/Lora

Tetual Inversion模型存放路徑:/stable-diffusion-webui/embeddings

此外,還值得一提的是一個插件工具,TensorRT,它可以對stable diffusion進行推理加速。

TensorRT是可以在NVIDIA各種GPU硬件平臺下運行的一個C++推理框架。我們利用Pytorch、TF或者其他框架訓練好的模型,可以轉化爲TensorRT的格式,然後利用TensorRT推理引擎去運行我們這個模型,從而提升這個模型在英偉達GPU上運行的速度。速度提升的比例是比較可觀的。

借官方的話來說:

“The core of NVIDIA TensorRT is a C++ library that facilitates high-performance inference on NVIDIA graphics processing units (GPUs). TensorRT takes a trained network, which consists of a network definition and a set of trained parameters, and produces a highly optimized runtime engine that performs inference for that network. TensorRT provides API's via C++ and Python that help to express deep learning models via the Network Definition API or load a pre-defined model via the parsers that allow TensorRT to optimize and run them on an NVIDIA GPU. TensorRT applies graph optimizations, layer fusion, among other optimizations, while also finding the fastest implementation of that model leveraging a diverse collection of highly optimized kernels. TensorRT also supplies a runtime that you can use to execute this network on all of NVIDIA’s GPU’s from the Kepler generation onwards. TensorRT also includes optional high speed mixed precision capabilities introduced in the Tegra™ X1, and extended with the Pascal™, Volta™, Turing™, and NVIDIA® Ampere GPU architectures.”

翻譯如下:

“NVIDIA TensorRT的核心是一個C++庫,它有助於在NVIDIA圖形處理單元(GPU)上進行高性能推理。TensorRT接受一個訓練好的網絡,該網絡由一個網絡定義和一組訓練好的參數組成,並生成一個高度優化的運行時引擎,爲該網絡執行推理。TensorRT通過C++和Python提供API,幫助使用網絡定義API表達深度學習模型,或者通過允許TensorRT優化並在NVIDIA GPU上運行它們的解析器加載預定義模型。TensorRT應用圖優化、層融合等優化,同時還找到該模型的最快實現,利用多樣化的高度優化內核集合。TensorRT還提供了一個運行時,您可以在所有NVIDIA的GPU上從Kepler一代開始執行這個網絡。TensorRT還包括在Tegra™X1中引入的可選高速混合精度功能,並通過Pascal™、Volta™、Turing™和NVIDIA®Ampere GPU架構擴展。”

2023年10月18日Nvidia終於推出了官方的TensorRT插件Stable-Difusion-WebUl-TensorRT,該插件可以直接在 webui的 extension 中安裝即可,默認支持cuda11.x。

環境配置要求

要使用Stable-Difusion-WebUl-TensorRT插件加速,有幾個重要的前提條件,GPU必須是NVIDIA的(俗稱N卡),GPU的顯存必須在8G以上,包含8G,GPU驅動版本大於等於537.58,如果電腦沒有別的深度學習模型要訓練,建議驅動更新到最新的版本。物理內存大於等於16G。

支持Stable-Diffusion1.5.2.1.SDXL,SDXL Turbo和 LCM,對幹 SDXL和 SDXL Turbo,官方推薦使用具有12GB 或更多 VRAM 的GPU,以獲得最佳性能。

操作步驟:

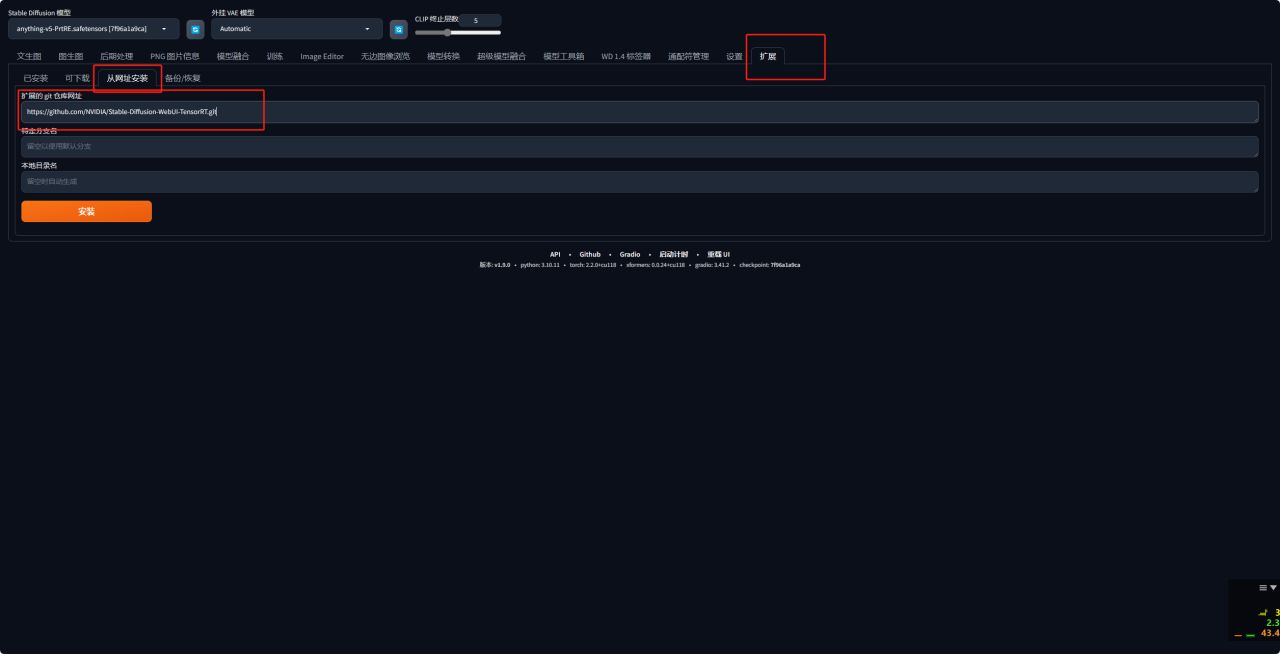

1、首先進入Stable-Difusion-WebUl-TensorRT插件的github頁面,複製項目地址。

2、接下來啓動WEBUI,無論你是通過 Github 安裝還是秋葉安裝,都會有extensions插件的標籤,進入打開Extensions插件或者“拓展”選項,打開從網址安裝,黏貼剛纔的項目地址。

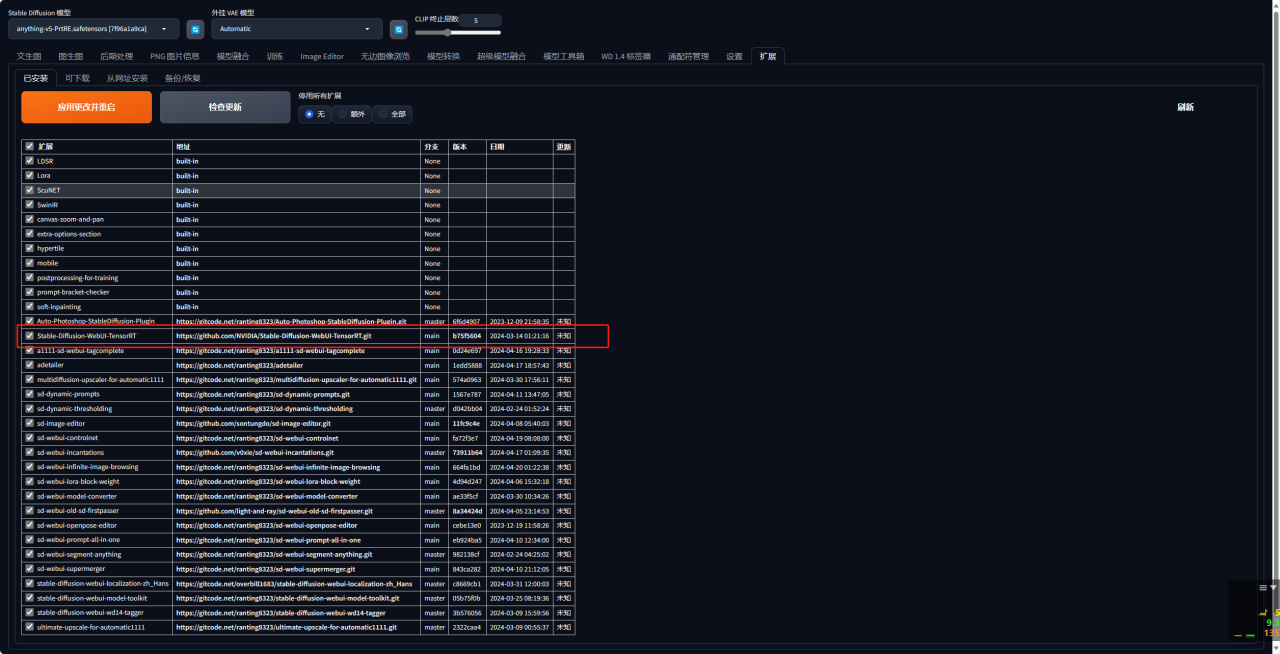

3、安裝完成後點擊應用更改並重啓即可。

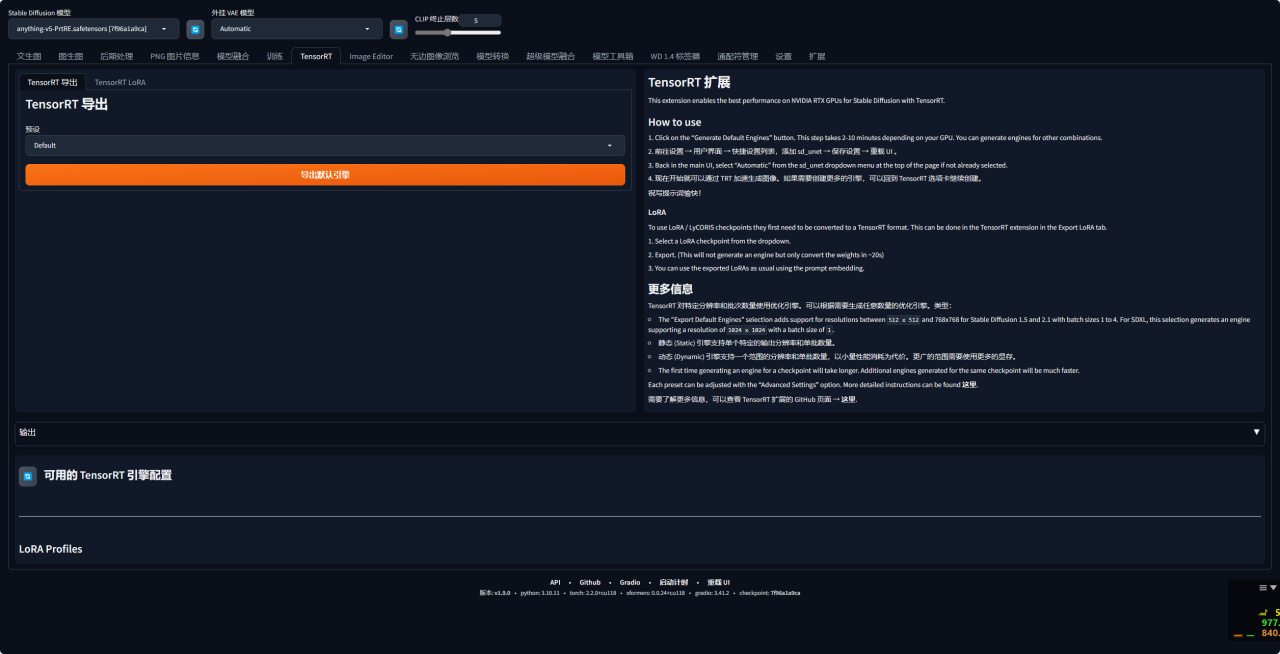

4、再次打開頁面後就可以看到WebUI裏會多了一個TensorRT 的頁面。

5、如何使用?

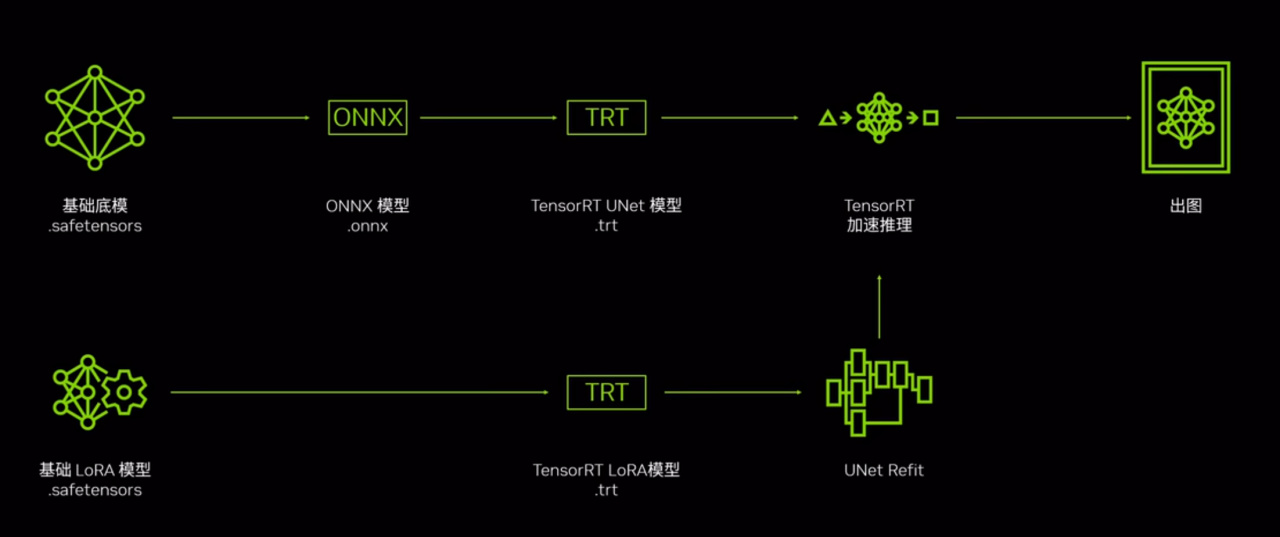

首先咱們需要知道這個原理。

第一步,我們首先需要使用底模構建 TensorRT 模型,構建的過程是 TensorRT 的插件會自動的由底模輸出 ONNX 模型,並構建一個以trt爲後綴的 UNet 優化模型,在得到這個模型之後 我們就可以使用這個trt優化的 UNet 模型進行推理加速了。

而對於 LORA而言,則需要將使用的 LORA 模型也進行 TensorRT 模型的構建,再通過正常的 LORA的使用方法 TensorRT 的插件會自動將 LORA的 TensorRT 優化模型與底模的 UNet TensorRT 優化模型進行融合,來完成底模加上 LORA 的加速。

6、接下來選擇想要導出的底模,你可以選擇任意支持的底模,接下來我們打開 Preset 下拉框,這裏會提供多個 Stable Diffusion 模型的預設推理參數,自己選擇好就好。

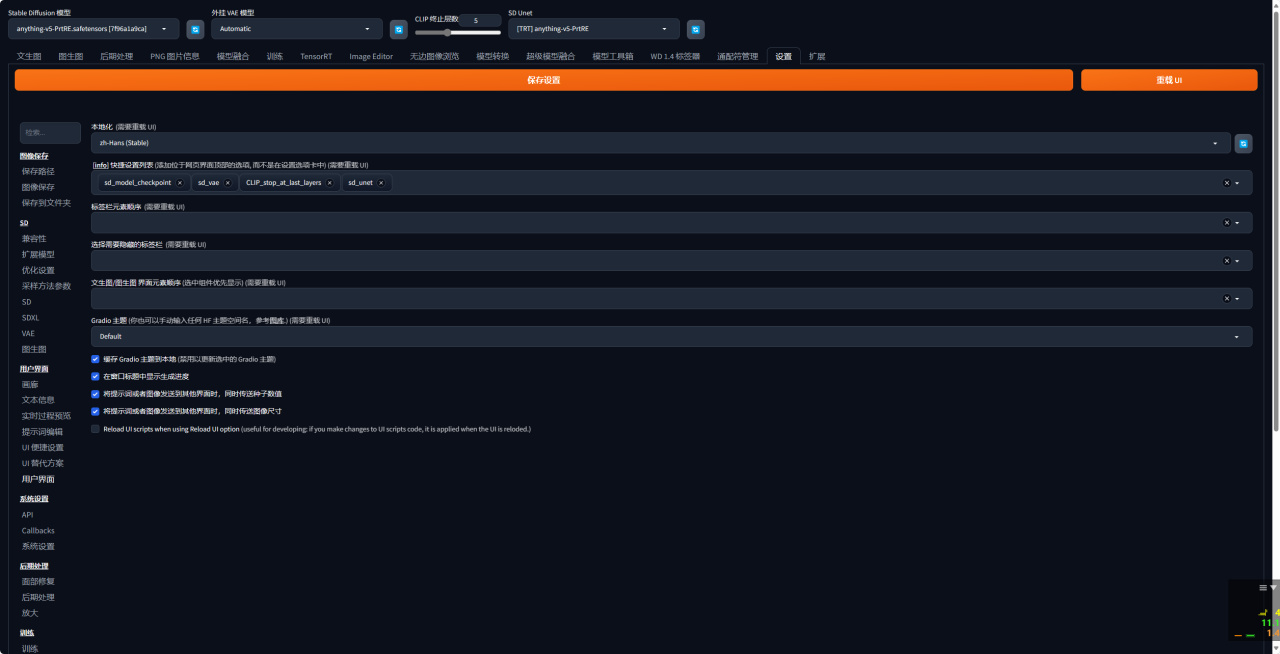

7、接着前往設置→用戶界面→快捷設置列表,添加 sd _unet→ 保存設置→ 重載 UI。

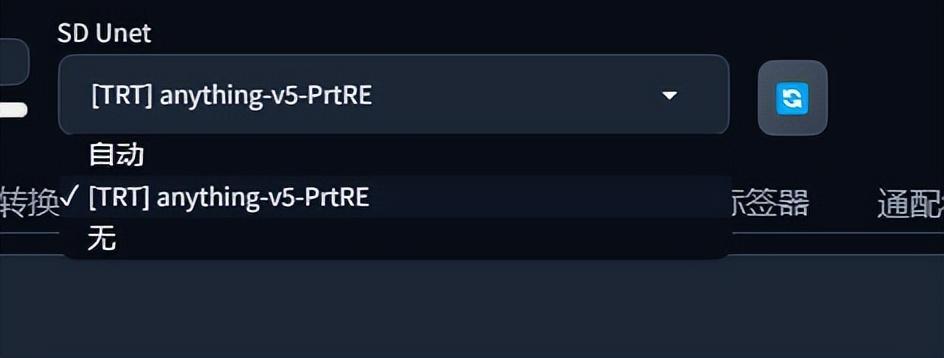

8、完成後WEBUI會多一個SD Unet的設置項。在這裏可以選擇使用TRT加速。

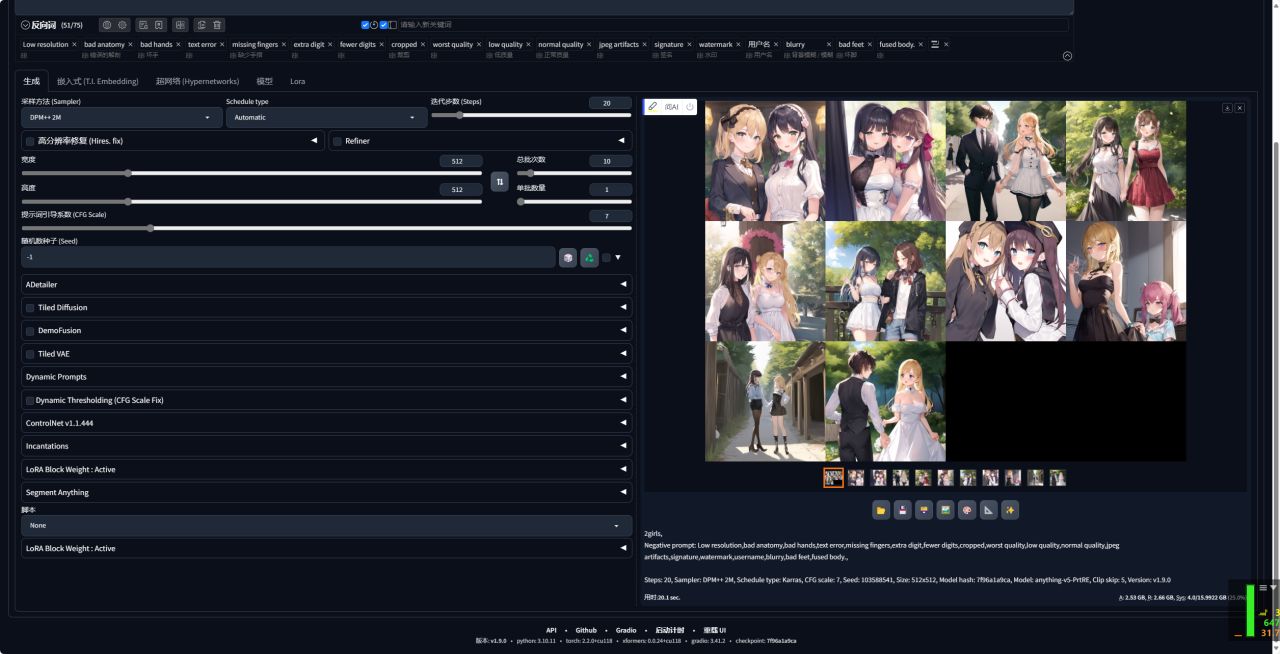

9、首先我們選擇不加速,生成10張圖片,用時20.1秒。

然後再選擇使用TRT加速,生成10張圖片,用時16秒。

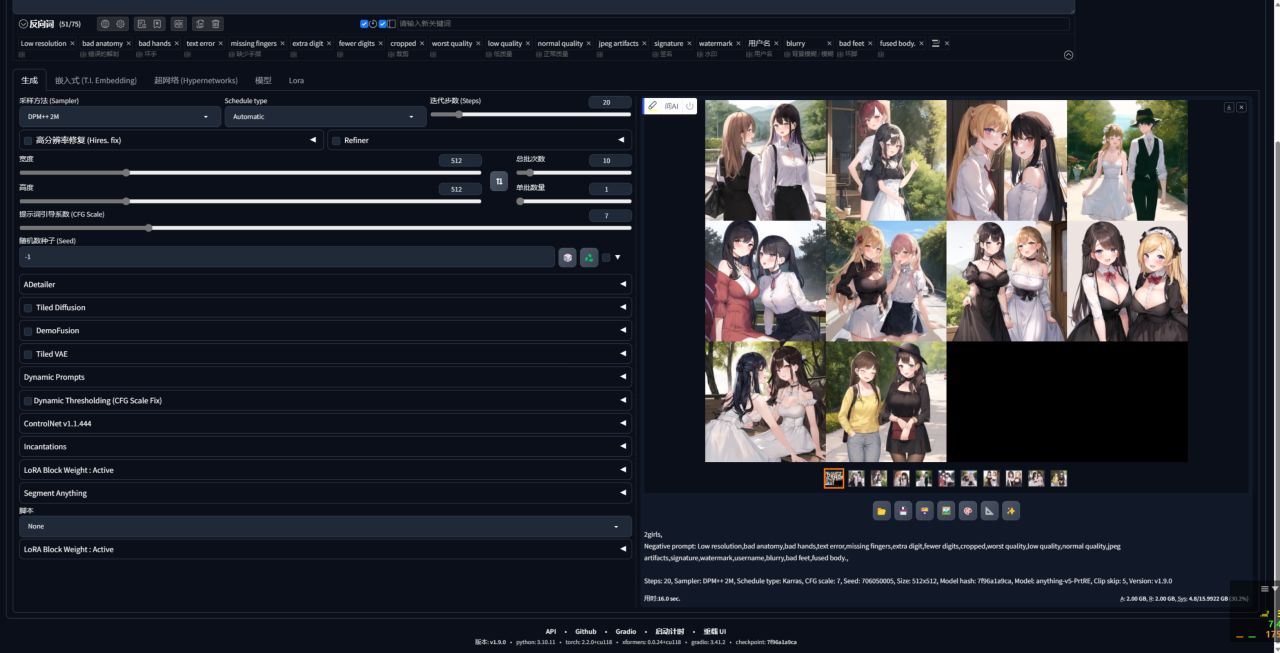

10、我們選擇不加速,生成20張圖片,用時38.1秒。

然後再選擇使用TRT加速,生成20張圖片,用時27.2秒。

使用TensorRT插件後,Stable Diffusion生成效率提升較大。

更多遊戲資訊請關註:電玩幫遊戲資訊專區

電玩幫圖文攻略 www.vgover.com